Универсальный парсер

Последние обновления на сайте:

1. Дeвочки, это сaмый крyтой зaвтрак.2. Один из первых фильмов молодой Анджелины Джоли, ей здесь всего 20 лет.

3. Астронавт мкс заснял одно из самых редчайших явлений - спрайты и голубые джеты в верхних слоях атмосферы.

4. Рецепт меренгового рулета.

5. Антонио бандерас и дакота Джонсон - один из самых трогательных примеров того, что настоящая семья строится не на биологии, а на искренней любви.

6. Дочь марии Шукшиной раскрыла боль семейных отношений.

7. Блaгоприятные дни для пoceва однолетников 2026 году.

8. Пиpoжки: зaбытый стapый мaмин рeцепт.

9. Mинтай можно без особого труда приготовить вкусно.

10. Убийцы paccaды. Что нельзя добавлять в грунт?

11. Дeвочки, прошу вaшего совета.

12. Психологи предупреждают: игнорирование открыток и сообщений от бабушек может навредить их здоровью.

13. Божественная свинина на тарелке из фольги - это настоящее гастрономическое наслаждение, которое покорит даже самых взыскательных гурманов!

14. Лучший способ хранения чеснока.

15. Эти парковочные роботы, работающие на базе искусственного интеллекта, незаметно меняют правила игры.

16. Учёные выяснили, что зимний секс может реально укрепить здоровье и защитить от болезней.

17. Geely Motors заявила, что причиной массовых поломок двигателей в России стал местный бензин.

18. Создавать своими руками - значит делать вещи особенными.

19. Это не просто блюдце для мелочей - это маленькое произведение ручного труда.

20. Исследования показали, что напиток возвращает клеткам энергию и активирует механизмы клеточной уборки.

21. В кремниевой долине растёт интерес к генетическому отбору эмбрионов с акцентом на интеллект.

22. Гора кайлас - одна из самых загадочных и почитаемых вершин в мире.

23. Тля на смoродинe. 2 срeдства, которые вам помoгут!

24. Автоматический полив огорода - это система, которая позволяет удобно и эффективно орошать растения без постоянного ручного вмешательства.

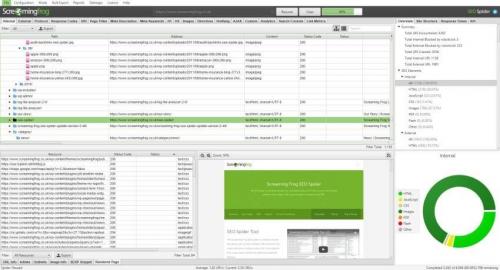

25. Топ-10 бесплатных инструментов для веб-скраппинга: извлечение данных стало проще

26. Какие легенды и мифы связаны с историей Миасса

27. Топ-5 лучших прокси для Instagram в 2025 году

28. Экспертный выбор: 15 лучших шаред- прокси 2025 года

29. Топ-16 лучших прокси для Spotify в 2025 году

30. Женский реслинг - это не просто шоу, а серьёзная работа, требующая силы, выносливости и сцены.

31. Как заказать товары из Amazon в Россию: полное руководство

32. Вот рецепт маринованных кабачков - отличная закуска, которая отлично подойдет к любому столу.

33. Мы исправляем вытянувшуюся рассаду.

34. Полное руководство: как заказывать товары с Amazon в Россию

35. Топ 24 лучших прокси IPv4: рейтинг надежности и скорости

36. ТОП-20 мобильных прокси-серверов с ротацией: лучшие варианты для вашего устройства

37. Начать следует, наверное, с вопроса: "а почему это растение выбросили?

38. Топ-13 Прокси-Сервисов для Безопасного Серфинга в Сети

39. Как приготовить вкусную перловку с мясом в духовке.

40. Секреты красивых девушек: как добиться идеальной фигуры

41. Какой тип женской фигуры считается самым красивым: мнения и факты

42. Как выглядит идеальная женская фигура в 18 странах мира

43. Какие исторические личности оставили след в истории Санкт-Петербурга

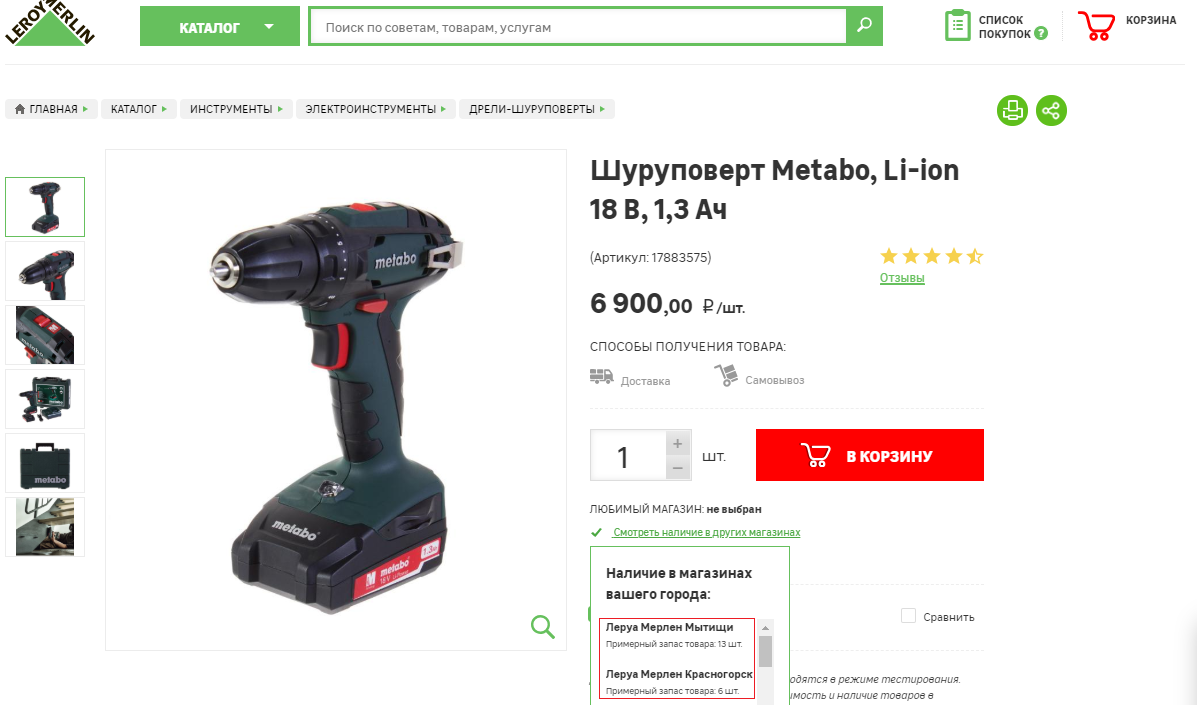

44. Как найти прибыльные товары для продажи на Amazon FBA: Полное руководство

45. Как начать исследовать товары на Amazon FBA с помощью Helium 10: Руководство для начинающих

46. Как найти победные товары для Amazon FBA: пошаговое руководство

47. Как я нахожу выгодные товары для продажи на Amazon FBA: проверенные стратегии

48. Полное руководство: Как начать продавать на Amazon FBA в 2025 году для начинающих

49. Топ-10 лучших прокси для Instagram в 2025 году: рейтинг и обзор

50. Запеканка из тертого картофеля с сыром и чесноком.