Топ-10 бесплатных инструментов для веб-скраппинга: извлечение данных стало проще

- Топ-10 бесплатных инструментов для веб-скраппинга: извлечение данных стало проще

- Связанные вопросы и ответы

- Что такое веб-скраппинг и для чего он используется

- Какие есть лучшие бесплатные инструменты для веб-скраппинга

- Как выбрать подходящий инструмент для извлечения данных из веба

- Какие преимущества использования бесплатных инструментов для скраппинга

- Какие основные функции должны быть у хорошего инструмента для веб-скраппинга

- Можно ли использовать эти инструменты для коммерческих целей

- Какие из инструментов лучше подходят для начинающих

Топ-10 бесплатных инструментов для веб-скраппинга: извлечение данных стало проще

Что такое веб-скраппинг и почему он важен?

Веб-скраппинг — это процесс сбора данных из веб-страниц. Это мощный инструмент для анализа, мониторинга и автоматизации. С помощью скраппинга можно собирать информацию о ценах, отзывах, новостях и многом другом.

Топ-10 бесплатных инструментов для веб-скраппинга

| № | Инструмент | Описание | Особенности | Пример использования |

|---|---|---|---|---|

| 1 | Beautiful Soup | Библиотека Python для парсинга HTML и XML. | Легко использовать, гибкая настройка. | Скраппинг новостных сайтов. |

| 2 | Scrapy | Фреймворк Python для высокопроизводительного скраппинга. | Быстрый, поддерживает асинхронность. | Сбор данных с электронных магазинов. |

| 3 | Selenium | Инструмент для автоматизации браузера. | Имитация пользовательских действий. | Парсинг динамических веб-страниц. |

| 4 | Octoparse | Визуальный скраппер без кодирования. | Подходит для начинающих. | Скраппинг данных из таблиц. |

| 5 | ParseHub | Визуальный инструмент для извлечения данных. | Поддержка JavaScript. | Парсинг сложных сайтов. |

| 6 | Import.io | Платформа для конвертации веб-страниц в данные. | Простой интерфейс. | Скраппинг данных из каталогов. |

| 7 | WebHarvy | Визуальный скраппер с поддержкой JavaScript. | Подходит для начинающих. | Скраппинг данных из веб-сайтов. |

| 8 | DataMiner | Инструмент для извлечения данных из веб-страниц. | Поддержка регулярных выражений. | Парсинг данных из форумов. |

| 9 | Content Grabber | Профессиональный инструмент для скраппинга. | Поддержка крупномасштабных проектов. | Скраппинг данных из бизнес-каталогов. |

| 10 | Mozenda | Платформа для извлечения и анализа данных. | Поддержка машинного обучения. | Парсинг данных для аналитики. |

Как выбрать подходящий инструмент?

- Определите свои цели: для каких задач вам нужен скраппинг?

- Учитывайте уровень сложности: нужен ли вам визуальный интерфейс или готовы писать код?

- Проверьте поддержку необходимых функций: работа с JavaScript, обработка больших объемов данных и т.д.

- Оцените удобство использования и доступность документации.

Советы по использованию инструментов

Перед началом скраппинга убедитесь, что это не нарушает условия использования веб-сайта. Также важно соблюдать этические нормы и не перегружать сайты слишком большим количеством запросов.

Связанные вопросы и ответы:

Что такое веб-скраппинг и для чего он используется

Web Scraping – это популярный метод получения контента практически даром. У нас такой метод называется «парсинг контента» или «парсинг сайтов». Метод состоит в том, что специально обученный алгоритм заходит на главную страницу сайта и начинает переходить по всем внутренним ссылкам, тщательно собирая внутренности указанных вами div-ов. В качестве результата работы – готовый CSV файл, в котором вся нужная информация лежит в строгом порядке.

Зачем?

Полученный CSV можно использовать для последующей генерации почти уникального контента. Да и в целом, как таблица, такие данные представляют большую ценность. Представьте, что весь ассортимент какого-то строительного магазина представлен в таблице, притом для каждого изделия, для каждого подвида и марки изделия заполнены все поля и характеристики. Если наполнением интернет-магазина занимается копирайтер, то он будет счастлив иметь такой CSV файл, и вы можете увидеть на его глазах слезы благодарности. Если созданием контента занимается бездушный алгоритм и душевным именем «Нина», то тексты приобретут осмысленность, пользу и, конечно же, силу земли.

Какие кнопки жать?

Инструментов, на самом деле, море, и попробовать все нет ни возможности, ни желания. В нашей команде мы благополучно пользуемся ScrapingHub. Давайте-ка посмотрим, как именно мы это делаем.

Вначале логинимся или регистрируемся:

После этого появляется идиотичный аватар, который просит вас ввести какие-то данные. Забиваем на это дело и судорожно жмем Next:

Затем вы попадаете в личный кабинет. Здесь вам необходимо создать новый проект – вот так:

Здесь вам нужно выбрать алгоритм (будем рассматривать алгоритм Portia), а также дать имя проекту. Назовем его как-нибудь необычно. Например, «111».

Все, попадаем в рабочее пространство алгоритма, где уже нужно вводить сайт, который мы будем парсить. Нажимаем «New Spider».

Затем переходим на страницу, которая будет являться примером. В хедере обновится адрес. Жмем Annotate This Page.

Ведем курсор мыши вправо, после чего появляется меню. Здесь нас интересует вкладка «Extracted item», где нужно нажать «Edit Items».

Отображается пока пустой список наших полей. Жмем «+Field».

Здесь все просто: необходимо создать список полей. Для каждого item нужно ввести имя (в нашем случае, это заголовок и контент», указать, является ли это поле обязательным («Required») и может ли оно изменяться («Vary»). Если вы указываете, что какой-то Item является обязательным, то парсер будет просто пропускать страницы, где не сможет заполнить это поле. Если галочку не ставить, то парсинг может длиться бесконечно долго. Жмем Save Changes.

Теперь тупо мышкой щелкаем по нужному нам полю и указываем, что это такое:

Все указали? Тогда в шапке сайта жмем «Save Sample». После этого можете возвращаться в рабочий кабинет. Теперь парсер умеет что-то доставать, нужно поставить ему задачу. Для этого нажимаем “Publish Changes”.

Переходим к доске с заданиями. Жмем “Run Spider”. Выбираем сайт и приоритет. Пуск! Ой… то есть RUN! RUN, FOREST, RUN!

Ну, собственно, парсинг пошел. На бесплатных версиях идет он долго: около 10-50 запросов в минуту, в зависимости от скорости сервера, погоды и знака зодиака, в котором сейчас находится Меркурий. Скорость парсинга показывается по наведению на количество отправленных запросов:

Скорость получения готовых строк в CSV – по наведению на другое число.

Чтобы увидеть список уже сделанных Items – просто щелкните по этому числу. Увидите что-то подобное:

Когда парсинг закончится, результат можно сохранить вот по этой кнопке:

Как видите, здесь есть все, что может понадобиться начинающему специалисту в области парсинга.

На этом лекция окончена. Домашнего задания не будет. Первый ряд – вы неподражаемы. Есть вопросы?

— Простите, а как можно от этого защититься?

— Сайт WinStyle.Ru защищается от этого хитро: каждый раз при обновлении страницы все их div-ы получают новые названия (соотвественно, меняются и названия классов в CSS). Этого более, чем достаточно для того, чтобы парсинг перестал иметь смысл.

— Сколько длится парсинг одного сайта?

— А сколько стоит одна таблетка? Смотря какие размеры имеет сайт, как долго сервер отвечает на запросы. На нашей практике некоторые сайты полностью парсились почти за неделю. Конкретно сайт "Строительные Советы" парсился 44 минуты 10 секунд, было получено 1550 записей при 1897 запросах. Такие дела.

— Как реагируют поисковики на подобного рода контент?

— Как использовать в дальнейшем полученные данные, решать вам. Готовые CSV вы можете использовать для генерации новых текстов; как уже говорилось выше, такой CSV файл будет очень полезен как копирайтеру, так и алгоритму "Нина" . Можно ли вставлять такой контент целиком без обработки? Мы не знаем. Если вам удастся представить этот контент в более удобном виде, ваш сайт будет проще и комфортней для пользователя, чем источник - почему бы нет. Но мы бы на это ставку не делали. Парсенный контент - это "сырье", которое еще нужно переработать.

Какие есть лучшие бесплатные инструменты для веб-скраппинга

Ознакомьтесь с нашим списком лучших инструментов для веб-парсинга без программирования, отобранных и ранжированных на основе вышеизложенных критериев.

1. Bright Data

Bright Data лидирует в индустрии сбора веб-данных благодаря обширной прокси-сети из миллионов IP-адресов. Основываясь на этой надежной инфраструктуре, компания предоставляет различные инструменты для веб-парсинга. К ним относится No-Code Scraper , решение, предназначенное для не разбирающихся в технике пользователей, которым нужны простые способы извлечения данных с веб-сайтов.

Благодаря поддержке десятков шаблонов No-Code Scraper позволяет извлекать данные с множества сайтов всего за несколько кликов. Извлеченные данные можно отформатировать в несколько типов файлов и отправить непосредственно в облачное хранилище или загрузить локально.

Из всех поставщиков услуг по парсингу без программирования только Bright Data предлагает модель оплаты по факту использования, позволяющую платить только за то, что вы используете. Кроме того, это единственный поставщик, обеспечивающий полное соответствие требованиям GDPR и CCPA и поддерживающий этичные методы веб-парсинга.

Интегрированные функции защиты от ботов, полная совместимость с прокси-сетями, первоклассная адаптивная поддержка и широкий спектр шаблонов делают No-Code Scraper от Bright Data лучшим выбором на рынке для парсинга без программирования!

Основная цель : упрощенный сбор данных по запросу для всех. Сохраняйте полный контроль, гибкость и масштабируемость, не беспокоясь об инфраструктуре, прокси-серверах и блокировках

Особенности :

- Интуитивный пользовательский интерфейс для удобного сбора данных и управления ими

- Пакетная обработка запросов

- Экспорт данных в JSON, CSV и других форматах

- Интегрированные решения для обхода ботов, включая решение капч

- Время безотказной работы — 99,99 %

- Поддерживается сетью из 72+ млн резидентных прокси-адресов в 195 странах

- Возможность запуска сбора данных по запросу

- Соответствует требованиям GDPR и CCPA

- Глобальная поддержка 24/7

Платформы : облачный инструмент Plug-and-Play доступен во всех браузерах

Бесплатный вариант : доступна бесплатная пробная версия

Цены : от 1 $/1 тыс. записей

Отзывы пользователей : 4,6 из 5 (756 отзывов) на Trustpilot

2. Octoparse

Octoparse является заметным игроком в индустрии парсинга без программирования. Предоставляет программное обеспечение для получения неструктурированных данных с любого веб-сайта и преобразования их в структурированные наборы данных. После установки вы можете выбрать один из сотен доступных шаблонов или создать собственный. Эти настраиваемые задачи извлечения данных определяются с помощью простого пользовательского интерфейса типа «укажи и щелкни».

Основная цель : решение для парсинга без программирования, позволяющее превращать страницы в структурированные данные за несколько кликов

Особенности :

- Возможности автоматического циклирования

- Множество шаблонов для парсинга данных с популярных сайтов

- Помощник по веб-парсингу на базе ИИ

- Облачная автоматизация 24/7 для планирования работы парсеров

- Решение проблем с ротацией IP-адресов и капч

- Авторотация IP-адресов и решение капчи

- Поддержка бесконечной прокрутки, разбиения на страницы, выпадающего списка, наведения курсора и имитации многих других действий

Платформы : настольное приложение для Windows и macOS

Шаблоны : сотни шаблонов для Google Maps, Amazon, Twitter, Glassdoor, LinkedIn, Zillow, YouTube и многих других сайтов

Бесплатная опция : бесплатный план с ограниченными заданиями

Цены : от 99 $/мес.

Как выбрать подходящий инструмент для извлечения данных из веба

Чтобы изображение, созданное нейросетью (дальше мы будем называть их нейрокартинками), считалось объектом авторского права, по российскому закону оно должно соответствовать следующим критериям:

Имеет творческий характер. Это предполагает интеллектуальное усилие человека для создание чего-то нового. Судебная практика говорит, что все результаты интеллектуальной деятельности созданы творческим трудом, пока не доказано иное.

Выражено в объективной форме. Мысли, озвученные голосом и нигде не зафиксированные, выраженными в объективной форме не считаются.

Нейрокартинки не соответствуют двум из трёх названных критериев.

Во-первых, изображение создаёт не человек, а компьютерная программа.

Это похоже на знаменитую историю про . Фотограф Дэвид Слейтер снимал дикую природу в Индонезии. Он установил камеру со штативом рядом с обезьянами и отошёл. Одна из обезьян нажала на пульт и сама сделала несколько селфи.

Дэвид пытался доказать, что ему принадлежат авторские права на эти фотографии, но американские суды с ним не согласились. Фотографии были сделаны обезьяной, поэтому фотограф не обладает авторским правом на них. Как и обезьяна, которая не является человеком, а значит, не может быть субъектом авторского права.

Во-вторых, если картинку создаёт не человек, мы не можем говорить о творческом характере. Пока нейросеть не признают существом с сознанием.

Есть мнение, что нейрокартинки всё-таки являются объектом авторского права, потому что человек творческим трудом создаёт саму нейросеть, которая генерирует изображения. Это спорно, потому что творческий труд направлен на создание нейросети, а не изображений.

Нейросеть — это инструмент, с помощью которого можно получить изображение. С таким же успехом можно признать создателя фотоаппарата автором всех фотографий, сделанных с его помощью.

Что в итоге? Российское законодательство пока не признаёт нейрокартинки объектами авторского права, как и многие другие страны.

Правда, есть некоторые подвижки. Недавно Бюро авторского права США выпустило рекомендации по регистрации контента, созданного с помощью ИИ (искусственного интеллекта). Из них следует, что регистрация авторского права на нейрокартинку возможна, если автор сделал что-то кроме запроса — например, отредактировал её. То есть исходная нейрокартинка не является объектом авторского права, а конечный продукт — вполне.

С теорией закончили. Перейдём к практике.

Какие преимущества использования бесплатных инструментов для скраппинга

Взять на себя обязательства по изучению инструмента - дело серьезное, поэтому стоит подумать о том, что сделает этот опыт приятным для вас. Есть несколько ключевых моментов, о которых стоит помнить, прежде чем приступать к занятиям, поэтому давайте разберем их по порядку.

Цели

Что вы хотите делать с этим инструментом? Хотите ли вы играть свои любимые песни у костра, присоединиться к группе или даже создавать музыку в студии? Ваша конечная цель имеет значение, потому что некоторые инструменты лучше подходят для определенных музыкальных стилей или ролей. Если вы хотите просто неспешно джемовать, вам подойдет что-то простое, например укулеле. Но если у вас большие амбиции, вам может понадобиться инструмент, который даст вам больше возможностей, например фортепиано или клавишные.

Портативность

Эта модель для тех, кто любит быть в движении. Если вы планируете играть в гостях у друзей, брать инструмент с собой на концерт или просто часто переезжать, портативность - ключевой момент. Пианино звучит прекрасно, но таскать его с собой… не очень. Поэтому подумайте, нужно ли вам что-то легкое для переноски или вы собираетесь большую часть времени жить на одном месте.

Стоимость

Не все инструменты созданы одинаковыми, когда речь идет о стоимости. Некоторые из них вполне доступны по цене, в то время как другие могут стать серьезным капиталовложением. Кроме того, нельзя забывать об обслуживании и дополнительных приспособлениях, таких как струны, трости или кабели. Всегда полезно знать, во что вы ввязываетесь в финансовом плане, чтобы потом не было сюрпризов.

Личный интерес

В конце концов, вы должны понять, что вас действительно волнует. Если инструмент привлекает ваше внимание и вызывает желание взять его в руки, это уже большая победа. Не выбирайте что-то только потому, что это "практично". Выбирайте то, что вызывает у вас интерес. Так вы с большей вероятностью останетесь с ним.

Какие основные функции должны быть у хорошего инструмента для веб-скраппинга

В отличие от структурированных данных, которые соответствуют заранее определенным форматам или схемам, неструктурированные данные не имеют чёткой организации, что делает их сложными для извлечения информации вручную.

Отдельной проблемой является сбор неструктурированных данных. Вследствие большого объёма, разнообразия и сложности информации, это сложно делать. Для этого процесса необходимы извлечение данных из различных источников, например, при помощи API.

После сбора таких данных необходимо эффективно хранить и затем обработать эти данные. Для того, чтобы справиться со сложностью и объемами неструктурированных данных, компании должны вкладываться в современные решения.

Тем не менее, извлечение информации из неструктурированных данных представляет собой важнейшую вещь в сфере управления информацией: просеивая огромные объемы данных, можно обнаружить значимую для бизнеса информацию. Такими данными могут быть, например, электронные письма, новостные статьи, юридические документы и научные работы.

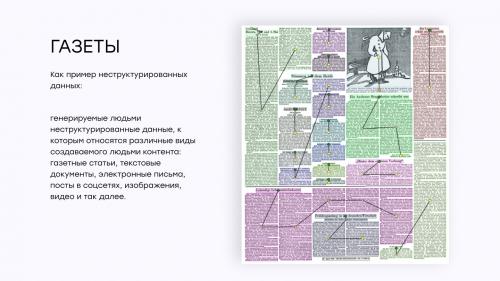

Газеты

Примером неструктурированных данных являются газетные статьи. Они часто содержат смесь текстового контента, изображений и метаданных, что затрудняет извлечение нужной информации вручную.

Используя ИИ-методы извлечения данных, можно автоматически анализировать газеты, извлекая такие важные сведения, как заголовки, даты публикаций, имена авторов и персонажей, содержание статей для цифрового архивирования и исследовательских целей.

Юридические документы

Юридические документы представляют собой еще один пример неструктурированных данных, которые можно эффективно анализировать, применяя технологии извлечения данных на основе ИИ. Юридические документы, такие как контракты, соглашения и судебные документы, часто содержат плотный, сложный язык и замысловатое форматирование.

Из судебных документов можно извлекать ключевые положения, пункты и даты, имена судей, подсудимых и ответчиков — доставать такие данные вручную может быть трудоемко и чревато ошибками. Лучше автоматизировать этот процесс, тем самым упрощая управление договорами и соблюдение требований.

Это лишь некоторые из примеров неструктурированных данных. С развитием цифрового мира могут возникать новые форматы, а уже имеющиеся форматы могут адаптироваться для включения в них новых неструктурированных типов данных.

Можно ли использовать эти инструменты для коммерческих целей

Smartproxy считается хорошим инструментом для веб-скрепинга по разным причинам, особенно для пользователей, которым нужны надежные и эффективные возможности сбора данных. Вот некоторые ключевые преимущества Smartproxy:

Обширный пул прокси : Smartproxy предлагает доступ к огромному пулу из более чем 40 миллионов прокси-серверов. Эта обширная сеть прокси-серверов позволяет пользователям направлять запросы на сбор данных через различные IP-адреса, что повышает анонимность и предотвращает блокировку IP-адресов.

Интеграция с веб-скрапингом : Smartproxy предоставляет инструмент для веб-скрапинга, который легко интегрируется с прокси-сервисом. Эта интеграция гарантирует, что пользователи смогут эффективно и без помех скрести веб-сайты, используя предоставленные прокси.

Бесплатная пробная версия: Smartproxy предлагает бесплатную пробную версию, позволяющую пользователям протестировать сервис и его возможности, прежде чем перейти на платный тарифный план. Этот пробный период позволяет пользователям оценить, насколько инструмент подходит для их конкретных потребностей в веб-скрапинге.

Сбор данных в режиме реального времени : Инструмент поддерживает сбор данных в режиме реального времени, что позволяет пользователям получать самую свежую информацию с веб-сайтов. Это очень важно для приложений, требующих постоянно обновляемых данных.

Универсальная совместимость с веб-сайтами : Smartproxy позволяет осуществлять скраппинг практически на любом сайте. Пользователи могут отправлять API-запросы инструменту, который запоминает запрашиваемый сайт и продолжает распространять информацию о нем до тех пор, пока не будет получено иное указание.

Экспорт сырого HTML : Извлеченные данные предоставляются в формате HTML, что делает их легкодоступными и готовыми к дальнейшему анализу или обработке.

Автоматизация Captcha : Smartproxy включает в себя функции автоматизации Captcha, которые эффективно работают, предотвращая потенциальные прерывания или ошибки, вызванные проблемами с Captcha на целевых сайтах.

Интеграция с прокси : Инструмент предлагает бесшовную интеграцию с прокси, гарантируя, что конфигурации, связанные с прокси, будут простыми и не потребуют обширных технических знаний.

Высокий коэффициент успешности : Smartproxy может похвастаться высоким коэффициентом успешности, заявленным на уровне 100%. Даже если фактический коэффициент успеха немного ниже (например, 99%), это все равно свидетельствует о надежности сервиса.

Доступные цены : Smartproxy предлагает ряд тарифных планов, которые позволяют удовлетворить различные потребности и бюджеты. План Lite, стоимостью от 50 долларов в месяц, является экономически выгодным вариантом для пользователей с умеренными требованиями.

Варианты для предприятий : Пользователи с большими или индивидуальными потребностями могут создать корпоративные тарифные планы с переменной ценой, обеспечивающие возможность масштабирования службы в соответствии с конкретными требованиями.

Какие из инструментов лучше подходят для начинающих

В последнее время получила распространение практика скрапинга сайтов, правомерность которой вызывает серьезные вопросы.

Скрапингом называется автоматизированный сбор информации с различных интернет-ресурсов, осуществляемый с помощью специально разработанной компьютерной программы — . Скрапинг включает в себя копирование веб-страницы в память компьютера для извлечения содержащейся в нем базовой информации. Если на исследуемом интернет-ресурсе находятся объекты авторских прав, то можно говорить о нарушении , поскольку происходит воспроизведение произведений без согласия правообладателя.

Если собираются и обобщаются данные, которые не являются объектами авторских прав, может иметь место иное нарушение — смежных исключительных прав изготовителя базы данных . В сфере смежных прав правовая охрана распространяется на объект как таковой, но не его отдельные элементы или модификации. Базы данных, для создания которых требовались существенные затраты, занимают особое место среди объектов смежных прав. П. 3 ст. 1335.1 ГК РФ устанавливает запрет на неоднократное извлечение или использование материалов, составляющих несущественную часть базы данных, если такие действия противоречат нормальному использованию базы данных и ущемляют необоснованным образом законные интересы ее изготовителя.

Американские суды склоняются к тому, что содержание коммерческих сайтов подлежит защите и скрапинг нарушает исключительные права на базу данных . При рассмотренииими была сформулирована позиция: скрапинг сайтов (в том числе данных из социальных сетей) включает копирование веб-страницы в память компьютера для извлечения с нее основной информации. Даже если копирование кратковременное, этого достаточно, чтобы образовать воспроизведение объекта авторского права согласно § 106 Закона оби, следовательно, нарушить это право.

Так, в делесуд Техаса запретил ответчику продавать программное обеспечение, которое позволяло пользователям сравнивать онлайн-тарифы авиаперевозчиков, используя данные в том числе с сайта истца. Ответчик оспорил данное решение. На стадии апелляции стороны пришли к соглашению.