Лучшие бесплатные инструменты для сбора данных в режиме реального времени 2025

- Лучшие бесплатные инструменты для сбора данных в режиме реального времени 2025

- Связанные вопросы и ответы

- Какие лучшие бесплатные инструменты для сбора данных в режиме реального времени существуют в 2025 году

- Какие бесплатные инструменты для сбора данных рекомендуют в 2025 году

- Что делает инструмент для сбора данных лучшим в 2025 году

- Есть ли бесплатные онлайн-инструменты для сбора данных без установки

- Как эти инструменты справляются с различными источниками данных

- Какие основные функции у лучших инструментов для сбора данных

- Можут ли эти инструменты собирать данные с любого сайта

- Как эти инструменты обеспечивают точность сбора данных

Лучшие бесплатные инструменты для сбора данных в режиме реального времени 2025

Введение

В современном мире данные играют ключевую роль в принятии решений, оптимизации бизнес-процессов и анализе эффективности работы. Сбор данных в режиме реального времени позволяет компаниям оперативно реагировать на изменения, предвосхищать потребности клиентов и повышать конкурентоспособность. Однако, не все организации готовы инвестировать значительные средства в дорогое программное обеспечение. Именно поэтому мы рассмотрим лучшие бесплатные инструменты для сбора данных в режиме реального времени, которые доступны в 2025 году.

Таблица инструментов

| Инструмент | Особенности | Официальный сайт |

|---|---|---|

| Google Analytics | Анализ веб-трафика, поведение пользователей, интеграция с другими сервисами Google | analytics.google.com |

| Tableau Public | Визуализация данных, создание интерактивных дашбордов, обмен результатами | public.tableau.com |

| Microsoft Power BI | Создание дашбордов, бизнес-аналитика, интеграция с Excel | powerbi.microsoft.com |

| Grafana | Визуализация данных, интеграция с различными источниками данных, настройка дашбордов | grafana.com |

| OpenTSDB | Хранение и анализ временных рядов, масштабируемость, открытый исходный код | opentsdb.net |

| InfluxDB | Управление временными рядами, высокая производительность, открытый исходный код | influxdata.com |

| Prometheus | Мониторинг систем, сбор метрик, интеграция с Grafana | prometheus.io |

| Apache Kafka | Обработка потоков данных, распределенная система, высокая производительность | kafka.apache.org |

| TimescaleDB | Управление временными рядами, интеграция с PostgreSQL, открытый исходный код | timescale.com |

| ELK Stack (Elasticsearch, Logstash, Kibana) | Сбор, хранение и визуализация логов, поиск и анализ данных | elastic.co |

Подробное описание инструментов

Google Analytics

Google Analytics — один из самых популярных инструментов для анализа веб-трафика. Он позволяет собирать данные о посетителях сайта, их поведении, источниках трафика и многом другом. Основные преимущества включают:

- Простота интеграции с другими сервисами Google

- Широкие возможности анализа и визуализации данных

- Бесплатное использование для небольших и средних проектов

Tableau Public

Tableau Public предназначен для создания интерактивных дашбордов и публикации результатов анализа данных в интернете. Основные особенности:

- Легкость использования и интуитивно понятный интерфейс

- Возможность обмена результатами с общественностью

- Поддержка различных форматов данных

Microsoft Power BI

Power BI — мощный инструмент от Microsoft для бизнес-аналитики. Его основные преимущества включают:

- Создание интерактивных дашбордов

- Интеграция с Excel и другими продуктами Microsoft

- Бесплатная версия с ограниченным функционалом

Grafana

Grafana — популярная платформа для визуализации данных. Она поддерживает интеграцию с различными источниками данных и позволяет создавать настраиваемые дашборды. Основные особенности:

- Открытый исходный код

- Поддержка различных плагинов и интеграций

- Возможность создания интерактивных и динамических визуализаций

OpenTSDB

OpenTSDB — это база данных, предназначенная для хранения и анализа временных рядов. Основные преимущества:

- Открытый исходный код

- Масштабируемость и высокая производительность

- Поддержка распределенных систем

InfluxDB

InfluxDB — еще один популярный инструмент для работы с временными рядами. Его особенности включают:

- Открытый исходный код

- Высокая скорость записи и запросов

- Поддержка SQL-подобных запросов

Prometheus

Prometheus — система мониторинга и сбора метрик. Основные преимущества:

- Открытый исходный код

- Интеграция с Grafana для визуализации данных

- Подержка распределенных систем

Apache Kafka

Apache Kafka — это распределенная система для обработки потоков данных. Ее основные особенности:

- Высокая производительность и масштабируемость

- Поддержка обработки данных в режиме реального времени

- Интеграция с различными системами хранения данных

TimescaleDB

TimescaleDB — это база данных, специально разработанная для работы с временными рядами. Основные преимущества:

- Интеграция с PostgreSQL

- Открытый исходный код

- Поддержка сложных запросов и аналитики

ELK Stack (Elasticsearch, Logstash, Kibana)

ELK Stack — это набор инструментов для сбора, хранения и визуализации логов и данных. Основные особенности:

- Открытый исходный код

- Гибкость и настраиваемость

- Поддержка поиска и анализа данных

Как выбрать подходящий инструмент

Выбор инструмента зависит от конкретных потребностей вашей организации. Вот основные факторы, которые следует учитывать:

- Тип данных, которые вы собираете

- Необходимость визуализации данных

- Масштабируемость и производительность

- Возможность интеграции с другими системами

- Доступность технической поддержки и документации

Связанные вопросы и ответы:

Вопрос 1: Какие лучшие бесплатные инструменты для сбора данных в режиме реального времени существуют в 2025 году

В 2025 году среди лучших бесплатных инструментов для сбора данных в режиме реального времени можно выделить несколько ключевых платформ. Одним из самых популярных является Octoparse, который предлагает простой и интуитивно понятный интерфейс для сбора данных с веб-страниц. Еще одним эффективным инструментом является ParseHub, который поддерживает сложные запросы и может обрабатывать динамически загружаемый контент. Также стоит упомянуть DataMiner, который предоставляет расширенные функции для сбора данных из социальных сетей и форумов. Эти инструменты отличаются высокой точностью и способностью работать с большими объемами данных, что делает их незаменимыми для исследователей и аналитиков.

Вопрос 2: Какие бесплатные инструменты для сбора данных в 2025 году самые простые в использовании для начинающих

Для начинающих в 2025 году лучшими бесплатными инструментами для сбора данных являются те, которые имеют интуитивно понятный интерфейс и просты в настройке. Одним из таких инструментов является WebScrapingTool, который позволяет начать сбор данных всего за несколько кликов. Еще один простой в использовании инструмент — это Scrapy, который, несмотря на свою мощность, имеет понятную документацию и активное сообщество. Также можно выделить InstaParser, который специально разработан для сбора данных из Instagram и других социальных сетей. Эти инструменты идеально подходят для тех, кто только начинает осваивать сбор данных.

Вопрос 3: Какие бесплатные инструменты для сбора данных в 2025 году самые надежные и стабильные

В 2025 году самыми надежными и стабильными бесплатными инструментами для сбора данных являются те, которые проверены временем и имеют хорошую репутацию. Одним из таких инструментов является BeautifulSoup, который на протяжении многих лет остается стандартом для сбора данных из HTML и XML. Еще один надежный инструмент — это Selenium, который позволяет автоматизировать браузер и собирать данные даже с динамически загружаемых страниц. Также стоит упомянуть Scrapy, который известен своей высокой производительностью и способностью обрабатывать большие объемы данных. Эти инструменты доказали свою надежность и продолжают быть популярными среди специалистов.

Вопрос 4: Какие бесплатные инструменты для сбора данных в 2025 году предоставляют лучшую поддержку и обновления

В 2025 году лучшими бесплатными инструментами для сбора данных, которые предоставляют отличную поддержку и регулярные обновления, являются те, которые активно развиваются их создателями. Одним из таких инструментов является Octoparse, который регулярно обновляется и имеет активное сообщество пользователей. Еще один пример — это ParseHub, который поддерживается командой разработчиков, постоянно добавляющих новые функции и улучшающих. Также стоит упомянуть DataMiner, который известен своей оперативной поддержкой и частыми обновлениями. Эти инструменты обеспечивают пользователям стабильность и доступ к новым функциям.

Вопрос 5: Какие бесплатные инструменты для сбора данных в 2025 году лучше всего подходят для сбора данных из социальных сетей

Для сбора данных из социальных сетей в 2025 году лучшими бесплатными инструментами являются те, которые специально разработаны для этой цели. Одним из таких инструментов является SocialDataTool, который позволяет собирать данные из платформ like Facebook, Twitter и Instagram. Еще один эффективный инструмент — это InstaParser, которыйально designed для сбора данных из Instagram. Также можно выделить TwitterScraper, который позволяет собирать твиты и данные о пользователях. Эти инструменты предоставляют возможность анализировать данные из социальных сетей и использовать их для исследований или маркетинговых целей.

Вопрос 6: Какие бесплатные инструменты для сбора данных в 2025 году лучше всего подходят для крупномасштабных проектов

Для крупномасштабных проектов в 2025 году лучшими бесплатными инструментами для сбора данных являются те, которые способны обрабатывать большие объемы данных и обеспечивать высокую производительность. Одним из таких инструментов является Scrapy, который известен своей скоростью и способностью работать с большими объемами данных. Еще один мощный инструмент — это Apache Nutch, который предназначен для крупномасштабных проектов и может обрабатывать миллионы веб-страниц. Также стоит упомянуть DataMiner, который предоставляет расширенные функции для сбора данных и анализа. Эти инструменты идеально подходят для сложных и масштабных проектов.

Какие лучшие бесплатные инструменты для сбора данных в режиме реального времени существуют в 2025 году

Analytic Workspace (AW BI) — отечественная платформа, которая несколько лет подряд входит в число лучших BI-систем России в рейтингах и конкурсах CNews, IT-эксперт, OSP, “Битвы дашбордов и BI-систем для строительной отрасли ”, ФРИИ и других. Позиционируется как производительный инструмент анализа и BI-визуализации данных для компаний разных отраслей, масштабов. Имеет активное сообщество, предлагает бесплатное обучение с сертификацией BI-аналитиков.

Функции

Подключение к различным источникам

Платформа поддерживает одновременную работу с базами данных, облачными хранилищами, CRM, ERP-системами, файлами, архивами разных форматов. Пользователи могут подключать источники через встроенные коннекторы или добавлять собственные JDBC-коннекторы для нестандартных задач.

Внутреннее хранилище на базе Clickhouse

Основной процесс обработки данных в AW BI предусматривает создание плоской аналитической таблицы-витрины во внутреннем хранилище системы, основанном на СУБД ClickHouse. Эта функциональность, доступная "из коробки", позволяет заказчикам экономить на построении отдельной инфраструктуры для хранения данных. Кроме того, AW BI поддерживает live-режим прямого подключения к готовым витринам данных ClickHouse — в этом случае загрузка данных во внутреннее хранилище системы не требуется.

В планах развития платформы — внедрение ассоциативных моделей данных, таких как "звездочка" и "снежинка". Эти современные аналоги многомерных OLAP-кубов расширят спектр сценариев использования системы в корпоративном секторе со сложной инфраструктурой.

Полноценный ETL-модуль и self-service визуализация

Уникальная особенность AW BI — наличие self-service ETL-блоков, которые позволяют пользователям выполнять большое количество операций по трансформации данных самостоятельно. Создавайте модели данных, расчетные поля, иерархии, управляйте расписанием загрузки, объединяйте таблицы — настраивайте процессы обработки показателей для решения сложных аналитических задач.

Библиотека ETL-блоков доступна "из коробки" и расширяется с каждым релизом.

Используйте drag-n-drop BI-конструктор для создания интерактивных виджетов и дашбордов. Система предоставляет 30+ визуализаций “из коробки” и нативную интеграцию с ECharts (более 400 визуализаций). Кроме того, есть возможность создавать кастомные HTML-виджеты под любые запросы заказчика.

Гибкая модель доступа

Настройка прав разных категорий пользователей: разработчиков, аналитиков, руководителей. Доступ к данным, дашбордам, виджетам разграничивается по принципу ABAC (доступ к атрибутам) на уровне конкретных ролей и индивидуальных прав.

А также:

- Настройка инкрементального обновления.

- Адаптивная верстка под разные форматы экранов

- Гибкая фильтрация, сортировка.

- SQL-запросы в моделях данных.

- Совместная работа, публичные ссылки на виджеты, дашборды.

Условное форматирование, расширенные возможности работы с таблицами.

Какие бесплатные инструменты для сбора данных рекомендуют в 2025 году

В 2022-м году я на все лады расхваливал Crystal Explorer — младшую, но зато бесплатную версию одного из самых известных на тот момент инструментов для расследований в блокчейне Bitcoin-а. Осенью того же года компания Crystal сперва прикрыла сервис для россиян, а потом и закрыла вовсе. Причина проста: разработчики — украинцы. Хоть и обосновались в США.

Однако в 2025-м году произошло возвращение сервиса. Не триумфальное, но все же, и даже без VPN. Сервис, как и раньше, бесплатен. Он позволяет проводить несложные расследования по биткам и безвозмездно идентифицирует (привязывает к сущностям) некоторое количество кошельков в день. Crystal Explorer также имеет приятный в использовании обозреватель блокчейна и интуитивно понятную систему графовой визуализации данных.

В предыдущих обзорах я много писал о таких инструментах, как логгеры, позволяющих получить данные о соединении (IP-адресе, провайдере, регионе, использовании средств анонимизации трафика) и устройстве (модели, операционной системе, браузере) пользователя сети Интернет. И решения вроде Canary Tokens или IPLogger никуда не делись, только стали лучше.

Однако повысить собираемость данных логгером, как оказалось, можно при помощи простейшего сокращателя гиперссылок от ВКонтакте. Его уникальной особенностью является возможность «увидеть» авторизованный аккаунт ВК при переходе пользователя по логируемой гиперссылке.

Даже в общедоступном варианте использования это позволяет дополнить отчет логгера такими сведениями, как пол и возраст пользователя, а также город его проживания. Особенно приятно, что сокращатель от ВК не обнаруживают антивирусы и использовать его значительно проще, чем у СПО-шных аналогов.

Что делает инструмент для сбора данных лучшим в 2025 году

VirusTotal ― бесплатная служба для анализа подозрительных файлов и ссылок. В представлении не нуждается.

Intezer ― детектор зловредов, поддерживающий динамический и статический анализ.

Triage ― онлайн-сервис для анализа больших объемов вредоносного ПО с функцией статического анализа образцов.

FileScan.IO — служба анализа вредоносных программ, с динамическим анализом и функцией извлечения индикаторов компрометации (IOC).

Sandbox.pikker ― онлайн-версия известной системы анализа вредоносных программCuckoo Sandbox. Предоставляет подробный отчет с описанием поведения файла при выполнении в реалистичной, но изолированной среде далеко в облаке.

Manalyzer ― бесплатный сервис, для статического анализа PE-файлов и выявления маркеров нежелательного поведения. Имеет офлайн-версию .

Opswat ― сканирует файлы, домены, IP-адреса и хеши при помощи технологии Content Disarm & Reconstruction.

InQuest Labs ― сервис для сканирования текстовых документов файлов Microsoft и Open Office, электронных таблиц и презентаций. Работает на базе механизмов Deep File Inspection (DFI).

Any Run ― еще одна онлайн-песочница с красивым интерфейсом и дополнительными опциями.

Yoroi ― итальянская служба анализа подозрительных файлов на базе песочницы. Переваривает PE (например, .exe-файлы), документы (doc и PDF), файлы сценариев (типа wscript, Visual Basic) и APK, но мучительно медленно готовит отчеты.

Unpacme ― онлайн-сервис для автоматической распаковки вредоносных программ и извлечения артефактов.

Malwareconfig ― веб-приложение для извлечения, декодирования и отображения параметров конфигурации распространенных вредоносных программ.

Malsub ― фреймворк Python RESTful для работы с API онлайн-сервисов для анализа вредоносного ПО.

Есть ли бесплатные онлайн-инструменты для сбора данных без установки

В отличие от структурированных данных, которые соответствуют заранее определенным форматам или схемам, неструктурированные данные не имеют чёткой организации, что делает их сложными для извлечения информации вручную.

Отдельной проблемой является сбор неструктурированных данных. Вследствие большого объёма, разнообразия и сложности информации, это сложно делать. Для этого процесса необходимы извлечение данных из различных источников, например, при помощи API.

После сбора таких данных необходимо эффективно хранить и затем обработать эти данные. Для того, чтобы справиться со сложностью и объемами неструктурированных данных, компании должны вкладываться в современные решения.

Тем не менее, извлечение информации из неструктурированных данных представляет собой важнейшую вещь в сфере управления информацией: просеивая огромные объемы данных, можно обнаружить значимую для бизнеса информацию. Такими данными могут быть, например, электронные письма, новостные статьи, юридические документы и научные работы.

Газеты

Примером неструктурированных данных являются газетные статьи. Они часто содержат смесь текстового контента, изображений и метаданных, что затрудняет извлечение нужной информации вручную.

Используя ИИ-методы извлечения данных, можно автоматически анализировать газеты, извлекая такие важные сведения, как заголовки, даты публикаций, имена авторов и персонажей, содержание статей для цифрового архивирования и исследовательских целей.

Юридические документы

Юридические документы представляют собой еще один пример неструктурированных данных, которые можно эффективно анализировать, применяя технологии извлечения данных на основе ИИ. Юридические документы, такие как контракты, соглашения и судебные документы, часто содержат плотный, сложный язык и замысловатое форматирование.

Из судебных документов можно извлекать ключевые положения, пункты и даты, имена судей, подсудимых и ответчиков — доставать такие данные вручную может быть трудоемко и чревато ошибками. Лучше автоматизировать этот процесс, тем самым упрощая управление договорами и соблюдение требований.

Это лишь некоторые из примеров неструктурированных данных. С развитием цифрового мира могут возникать новые форматы, а уже имеющиеся форматы могут адаптироваться для включения в них новых неструктурированных типов данных.

Как эти инструменты справляются с различными источниками данных

От SQL до MATLAB

Дата-аналитики работают с терабайтами данных. Их нужно собрать, проанализировать и вывести в виде простых графиков и таблиц. В этом помогают специальные программы и сервисы — рассказываем про них в статье.

Чем занимается Data-аналитик

Дата-аналитик работает с большим количеством данных. Он отвечает за:

- Сбор данных: использует разные источники, например базы данных , результаты опросов, таблицы, сайты в интернете;

- Обработку: заполняет пропуски, исправляет ошибки, группирует и подготавливает данные к дальнейшей работе;

- Анализ: ищет закономерности и тренды, которые помогут решить какую-то проблему или улучшить метрики;

- Прогнозирование : строит статистическую модель, чтобы понять, как ситуация будет развиваться дальше;

- Визуализацию выводов: создает графики, таблицы и диаграммы, чтобы представить информацию в простом и понятном виде.

Для работы с данными дата-аналитик использует разные сервисы и программы.

Инструменты для сбора данных

SQL

Это язык для работы с базами данных. С его помощью можно извлекать информацию, добавлять новые данные, удалять устаревшую информацию, создавать новые таблицы на основе старых и т.д.

полезен при работы с большими объемами информации и является стандартом для большинства. Самые популярные их них:

- MySQL : позволяет хранить любые данные — контакты, даты, цены, имена, списки товаров и т.д.

MySQL client. Источник

- PostgreSQL : более сложная система, подходит для обработки запросов в сфере финансов и промышленности;

PostgreSQL. Источник

- Microsoft SQL Server : предназначена для управления большими объемами данных, поддерживает разные бизнес- приложения , например Oracle ERP или Tableau .

Microsoft SQL Server. Источник

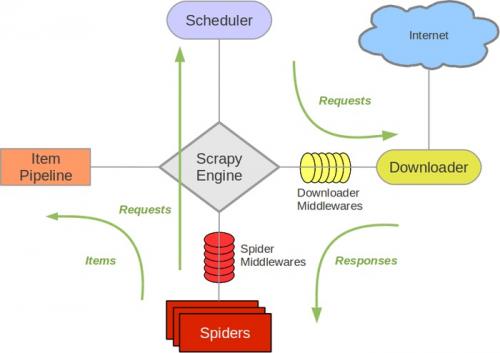

Web-скрейпинг

Часто данные собирают в интернете из открытых источников. Например, можно спарсить сайты конкурентов, чтобы составить список товаров и определить среднюю цену.

Для этого используют библиотеки:

- BeautifulSoup: подходит для простых задач по извлечению данных из статических HTML -страниц;

- Selenium : применяют для работы с динамическим контентом. Может обрабатывать страницы, которые загружаются с помощью JavaScript ;

- Scrapy: мощный фреймворк для веб-скрейпинга. Позволяет быстро собрать данные со множества страниц.

Схема работы Scrapy Spider. Источник

ETL-инструменты

Собирать данные можно не только с сайтов, но также баз данных, таблиц, облачных хранилищ. В этом случае используют-инструменты: они извлекают информацию из разных источников и преобразовывают ее в единый формат.

Какие основные функции у лучших инструментов для сбора данных

Чтобы настроить таргетинг. Парсинг пригодится для составления базы потенциальных клиентов для целевой рекламы и поиска подходящих площадок.

Чтобы исследовать конкурентов . Парсинг сайтов собирает данные о товарах, ценах и маркетинговых стратегиях ваших соперников. Вы отслеживаете изменения ассортимента или стоимости продукции и выявляете сильные и слабые стороны. Так вы выясните, какую цену установить на ваш товар. Если конкурент снизил стоимость, тоже снижайте.

Чтобы улучшить содержание. Парсинг собирает информацию, которую возможно использовать для улучшения наполнения сайта. Также с парсерами вы проводите контент анализ ресурсов конкурентов.

Чтобы работать над SEO . С помощью парсинга вы собираете ключевые слова для оптимизации вашей площадки, анализируете поисковую выдачу, а также находите ошибки на вашем сайте, мешающие продвижению. Парсеры проанализируют поисковые подсказки и помогут привлечь больше трафика. А ещё программы просмотрят весь сайт и найдут все нерабочие ссылки, ведущие на страницы, которых не существует. Так вы улучшите пользовательский опыт.

Чтобы провести комплексный анализ. Парсинг интегрируется с нужными вам сервисами, чтобы автоматически собирать данные о бюджетах и сделках. Так вы выясните, окупаются ли ваши кампании.

Чтобы понять или найти аудиторию. Парсинг проанализирует посты, комментарии и сообщения в социальных сетях. Благодаря этому вы поймёте, какие темы интересуют ваших пользователей, и оцените эффективность контент-маркетинга . Парсинг собирает подписчиков по нужным критериям, например, тех, кто много комментирует в группах ваших соперников. Используйте эту аудиторию для таргетированной рекламы.

Чтобы мониторить отзывы. Компании, отслеживающие свою репутацию в поисковиках, часто используют парсеры, чтобы найти новый фидбек о бренде. Так менеджеры оперативно реагируют на него.

Можут ли эти инструменты собирать данные с любого сайта

Процесс сбора данных включает ряд шагов, гарантирующих точность данных и их готовность к анализу. Вот как это работает.

- Определение источников данных: Процесс начинается с определения источника данных, например, физических документов, цифровых файлов или онлайн-форм. Каждый источник тщательно оценивается, чтобы понять тип данных и наилучший способ их сбора. Правильная категоризация этих источников гарантирует, что для эффективной обработки будут применяться правильные технологии и инструменты.

- Сбор данных: Следующий шаг — сбор информации. Это может включать сканирование бумажных документов, импорт цифровых файлов или захват ввода из веб-форм. Эффективный сбор данных гарантирует, что данные не будут потеряны во время передачи и будут быстро доступны для обработки.

- Извлечение информации : Этот шаг включает в себя извлечение релевантной информации из документов, гарантируя, что сохраняется только полезная информация. Для физических документов такие технологии, как OCR, преобразуют текст в машиночитаемые данные, в то время как структурированные цифровые файлы отображаются непосредственно в системе. Этот процесс преобразует необработанные данные в значимые идеи, фокусируясь на критических точках данных.

- Проверка данных : Система проверяет извлеченные данные, чтобы гарантировать их точность и согласованность с существующими записями. Этот шаг проверяет наличие несоответствий, отсутствующих полей и неверных записей, сравнивая данные с предопределенными правилами или внешними базами данных. Проверка данных уменьшает количество ошибок и гарантирует, что только высококачественные данные перейдут на следующий этап.

- Структурирование данных: После проверки данные организуются и форматируются в соответствии с конкретными системными требованиями. Это может включать стандартизацию единиц измерения, разбиение информации на дискретные поля и обеспечение совместимости с другими системами данных. Структурирование данных таким образом упрощает их хранение, извлечение и анализ по мере необходимости.

- Хранение данных: Последний шаг — безопасное хранение структурированных данных в центральном репозитории, например, в базе данных или хранилище данных. Теперь, когда данные организованы и проверены, они легко доступны для анализа, составления отчетов или дальнейшей интеграции с другими бизнес-системами. Этот шаг гарантирует, что ценные данные будут сохранены в безопасности и готовы к использованию в будущем.

Как эти инструменты обеспечивают точность сбора данных

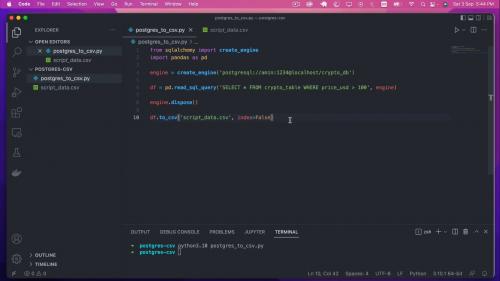

Здесь мы собираем данные с различных сайтов и создаём датасет, который потом используем для обучения алгоритма . Сбор данных с сайтов ещё называют веб-скрейпингом (ранее мы подробно рассказывали об инструментах для веб-скрейпинга ).

После того, как собрали данные, их нужно обработать , чтобы избавиться от ошибок, шума и несогласованностей, которые приведут к ситуации «мусор на входе — мусор на выходе». Это очень важно, так как от корректности данных будет зависеть точность результатов алгоритма.

Визуализация поможет определить линейность структуры данных, существенные признаки и аномалии. Для этих задач можно воспользоваться готовыми веб-сервисами, либо написать собственный код.

После того как мы почистили наш датасет, нужно поделить его на 80% — для обучения модели, — и 20% — для её проверки и тестирования.

pandas: библиотека для обработки и анализа данных

Она построена поверх NumPy, о котором поговорим чуть дальше. Это наши группировки, сортировки, извлечения и трансформации. Для работы с файлами CSV, JSON и TSV pandas превращает их в структуру данных DataFrame со строками и столбцами. Выглядит, как обычная таблица в Excel, и работать с ней легче, чем с for-циклами для прохода по элементам списков и словарей.

Tableau, Power BI, Google Data Studio: простая онлайн-визуализация без кода

Инструменты для бизнес-аналитики и людей без особых навыков программирования. Ключевое слово здесь — визуализация. Загружаем датасет и пользуемся встроенными функциями, фильтрами и аналитикой в реальном времени. Эти сервисы быстро собирают инсайты и представляют их в наглядной форме. И Tableau, и Power BI , и Google Data Studio имеют как платные подписки, так и бесплатные версии (само собой, с ограничениями).

Matplotlib: библиотека для построения 2D-графиков

Matplotlib в связке с библиотеками seaborn , ggplot и HoloViews позволяет строить разнообразные графики: гистограммы, диаграммы рассеяния, круговые и полярные диаграммы, и много других. Для большинства из них достаточно написать всего пару строк.