Топ-10 бесплатных веб-скрейперов 2025: выбор профессионалов

- Топ-10 бесплатных веб-скрейперов 2025: выбор профессионалов

- Связанные вопросы и ответы

- Какие лучшие бесплатные веб-скрейперы будут доступны в 2025 году

- Как выбрать подходящий веб-скрейпер для своих нужд

- Какие из бесплатных веб-скрейперов 2025 года легче всего использовать

- Можно ли использовать бесплатные веб-скрейперы для коммерческих целей

- Какие веб-скрейперы лучше всего справляются с анти-скрейпинговыми системами

- Поддерживают ли бесплатные веб-скрейперы 2025 года выполнение JavaScript

- Какие инструменты лучше подходят для сбора больших объемов данных

Топ-10 бесплатных веб-скрейперов 2025: выбор профессионалов

Веб-скрейпинг — это один из ключевых инструментов для сбора данных в интернете. В 2025 году выбор инструментов для веб-скрейпинга стал еще более разнообразным и функциональным. В этой статье мы рассмотрим топ-10 бесплатных веб-скрейперов, которые пользуются популярностью среди профессионалов. Эти инструменты помогут вам эффективно собирать данные, анализировать информацию и достигать своих целей.

Что такое веб-скрейперы и почему они важны?

Что такое веб-скрейперы?

Веб-скрейперы — это программные инструменты, предназначенные для сбора данных с веб-страниц. Они могут извлекать информацию из сайтов, обработанных в HTML-формате, и сохранять ее в удобном для анализа виде. Веб-скрейперы могут работать в автоматическом режиме, что значительно ускоряет процесс сбора данных.

Почему веб-скрейперы важны?

Веб-скрейперы используются в различных сферах деятельности: от маркетинга и анализа рынка до научных исследований и журналистики. Они позволяют собирать большие объемы данных, которые можно использовать для принятия обоснованных решений, анализа тенденций и выявления новых возможностей.

Топ-10 бесплатных веб-скрейперов 2025

Далее мы рассмотрим топ-10 бесплатных веб-скрейперов, которые рекомендуют профессионалы. Каждый из них имеет свои особенности, преимущества и недостатки, которые важно учитывать при выборе.

| № | Название | Особенности | Преимущества | Недостатки |

|---|---|---|---|---|

| 1 | Scrapy | Мощный фреймворк для веб-скрейпинга с поддержкой асинхронного режима. | Высокая скорость, гибкость, большое сообщество. | Сложность для начинающих. |

| 2 | BeautifulSoup | Библиотека для парсинга HTML и XML документов. | Легкость использования, простота интеграции с Python. | Ограниченная функциональность для сложных задач. |

| 3 | Selenium | Инструмент для автоматизации браузера с поддержкой JavaScript. | Поддержка динамического контента, имитация пользовательских действий. | Низкая скорость, требует дополнительных настроек. |

| 4 | Octoparse | Визуальный скрейпер с удобным интерфейсом. | Не требует программирования, поддержка динамических сайтов. | Ограниченная функциональность в бесплатной версии. |

| 5 | ParseHub | Продвинутый визуальный скрейпер с поддержкой JavaScript. | Простота использования, возможность обработки сложных сайтов. | Ограничения в бесплатной версии. |

| 6 | Import.io | Платформа для сбора данных с поддержкой машинного обучения. | Гибкость, возможность обучения моделей. | Сложность для начинающих. |

| 7 | WebHarvy | Визуальный скрейпер с поддержкой различных форматов данных. | Удобство использования, поддержка регулярных выражений. | Ограниченная функциональность в бесплатной версии. |

| 8 | DataMiner | Инструмент для сбора данных с поддержкой социальных сетей. | Широкий спектр функций, поддержка API. | Ограничения в бесплатной версии. |

| 9 | Content Grabber | Профессиональная платформа для веб-скрейпинга. | Гибкость, поддержка крупномасштабных проектов. | Сложность для начинающих. |

| 10 | Diffbot | Сервис для сбора данных с поддержкой машинного обучения. | Простота использования, высокая точность. | Ограничения в бесплатной версии. |

Как выбрать подходящий веб-скрейпер?

Выбор веб-скрейпера зависит от ваших потребностей и уровня сложности задач. Вот несколько советов, которые помогут вам сделать правильный выбор:

- Определите цели: для чего вам нужен скрейпер? Сбор данных с простых сайтов или обработка динамического контента?

- Учитывайте свои навыки: если вы новичок, выбирайте инструменты с визуальным интерфейсом.

- Проверьте ограничения: бесплатные версии могут иметь ограничения по объему данных или функциональности.

- Читайте отзывы: обратите внимание на отзывы других пользователей и рекомендации профессионалов.

Используя эти советы, вы сможете выбрать подходящий веб-скрейпер и начать собирать данные для своих проектов.

Связанные вопросы и ответы:

1. Какие основные функции предлагают лучшие бесплатные веб-скрейперы 2025 года

Лучшие бесплатные веб-скрейперы 2025 года предлагают широкий спектр функций, таких как автоматическая детекция структуры веб-страниц, поддержка различных форматов данных (CSV, JSON, Excel), возможность работы с динамическим содержимым (например, загружаемым через JavaScript) и интеграция с облачными хранилищами. Некоторые из них также предоставляют встроенные инструменты для анализа данных, такие как базовая визуализация и фильтрация. Кроме того, многие скрейперы поддерживают распределённое скраппинг, что позволяет обрабатывать большие объёмы данных быстрее. Некоторые сервисы предлагают возможность создания пользовательских скриптов для сложных задач, а также автоматическое обновление данных по расписанию.

2. Какие платформы поддерживают лучшие бесплатные веб-скрейперы 2025 года

Лучшие бесплатные веб-скрейперы 2025 года обычно поддерживают несколько платформ, включая веб-интерфейсы, настольные приложения и мобильные устройства. Некоторые из них работают исключительно в браузере, что делает их доступными на устройстве с поддержкой современных браузеров. Другие предлагают специализированные приложения для Windows, macOS и Linux, что удобно для пользователей, которые предпочитают работать на desktop. Кроме того, некоторые сервисы имеют мобильные приложения для iOS и Android, позволяя пользователям запускать и контролировать скраппинг-процессы в пути. Это делает их универсальными и удобными для использования в различных сценариях.

3. Какие из бесплатных веб-скрейперов 2025 года самые простые в использовании для начинающих

Среди бесплатных веб-скрейперов 2025 года есть несколько вариантов, которые особенно удобны для начинающих. Например, некоторые сервисы предлагаютdrag-and-drop интерфейсы, которые позволяют создавать скрапперы без написания кода. Эти инструменты часто имеют визуальные редакторы, где можно выбрать элементы на веб-странице и настроить параметры извлечения данных. Кроме того, некоторые скрейперы предоставляют пошаговые инструкции и обучающие курсы, которые помогают новичкам разобраться в функционале. Некоторые из них также имеют большое сообщество пользователей, где можно найти готовые решения и получить помощь при возникновении вопросов.

4. Могут ли бесплатные веб-скрейперы 2025 года обрабатывать веб-сайты с динамическим содержимым

Да, многие бесплатные веб-скрейперы 2025 года способны обрабатывать веб-сайты с динамическим содержимым, которое загружается через JavaScript. Для этого они используют встроенные или внешние инструменты, такие как Selenium или Puppeteer, которые имитируют работу браузера и ждут полной загрузки страницы. Некоторые скрейперы также поддерживают автоматическую детекцию динамических элементов и могут обновлять данные в режиме реального времени. Это особенно полезно для скраппинга социальных сетей, онлайн-магазинов и других ресурсов, которые активно используют динамическое содержимое.

5. Какие форматы данных поддерживают лучшие бесплатные веб-скрейперы 2025 года

Лучшие бесплатные веб-скрейперы 2025 года поддерживают множество форматов данных, включая CSV, JSON, Excel, XML и даже базы данных. Некоторые из них также позволяют экспортировать данные в облачные хранилища, такие как Google Drive, Dropbox или Amazon S3. Это делает их удобными для дальнейшей обработки и анализа данных. Кроме того, некоторые скрейперы предоставляют возможность создавать API, через которые можно получить доступ к извлечённым данным из других приложений. Это особенно полезно для интеграции с другими инструментами и системами.

6. Могут ли бесплатные веб-скрейперы 2025 года работать с веб-сайтами, защищёнными капчей

Некоторые бесплатные веб-скрейперы 2025 года могут работать с веб-сайтами, защищёнными капчей, но это зависит от уровня защиты и сложности капчи. Некоторые скрейперы используют встроенные алгоритмы для обхода капчи, такие как распознавание изображений или использование сторонних сервисов для решения капчи. Однако, многие веб-сайты используют сложные системы защиты, которые могут блокировать даже продвинутые скрейперы. В таких случаях пользователи могут использовать дополнительные инструменты или сервисы, которые специализируются на обходе капчи, но это может требовать дополнительной оплаты.

7. Какие из бесплатных веб-скрейперов 2025 года лучше всего подходят для коммерческого использования

Для коммерческого использования лучше всего подходят бесплатные веб-скрейперы 2025 года, которые предлагают достаточный уровень функционала и поддержки. Некоторые из них предоставляют бесплатные версии с ограниченными возможностями, но позволяют масштабироваться при необходимости. Например, некоторые скрейперы предлагают бесплатные тарифные планы с ограничением на количество запросов в месяц, что может быть достаточно для небольших проектов. Однако, для крупномасштабных проектов может потребоваться переход на платную версию или использование специализированных решений. Также важно учитывать вопросы лицензирования и соблюдение законов о защите данных при коммерческом использовании.

8. Могут ли бесплатные веб-скрейперы 2025 года обновляться автоматически для работы с новыми веб-сайтами

Да, некоторые бесплатные веб-скрейперы 2025 года поддерживают автоматическое обновление для работы с новыми веб-сайтами. Это достигается благодаря использованию алгоритмов машинного обучения, которые могут адаптироваться к изменениям в структуре веб-страниц. Некоторые скрейперы также предоставляют возможность подписки на обновления, которые добавляют поддержку новых сайтов и функций. Кроме того, некоторые сервисы имеют сообщества пользователей, которые делятся готовыми скриптами и настройками для популярных веб-сайтов. Это позволяет пользователям быстро адаптироваться к изменениям без необходимости вручную настраивать скрейпер.

9. Какие из бесплатных веб-скрейперов 2025 года предоставляют техническую поддержку

Среди бесплатных веб-скрейперов 2025 года техническая поддержка обычно ограничена, но некоторые сервисы предлагают базовую помощь через форумы, чаты или документацию. Некоторые из них имеют крупные сообщества пользователей, где можно найти ответы на большинство вопросов. Однако, для более сложных задач или индивидуальной помощи может потребоваться переход на платную версию или использование сторонних консультантов. Некоторые скрейперы также предоставляютные учебные материалы и руководства, которые помогают пользователям разобраться с функционалом без необходимости обращения в поддержку.

10. Могут ли бесплатные веб-скрейперы 2025 года быть использованы для скраппинга оциальных сетей

Да, некоторые бесплатные веб-скрейперы 2025 года могут быть использованы для скраппинга социальных сетей, но это зависит от конкретной платформы и её правил. Например, скраппинг данных из социальных сетей может быть ограничен их API или условиями использования. Некоторые скрейперы предоставляют готовые решения для извлечения данных из популярных социальных сетей, таких как Facebook, Instagram или Twitter. Однако, использование таких инструментов может нарушать правила платформы, что может привести к блокировке аккаунта или юридическим последствиям. Поэтому важно тщательно изучить условия использования перед началом скраппинга.

Какие лучшие бесплатные веб-скрейперы будут доступны в 2025 году

Прокси-серверы для парсинга веб-страниц наиболее эффективны, когда они настроены для работы на целевом веб-сайте.

Из-за уникальной природы каждого веб-сайта на каждом веб-сайте есть механизмы защиты от спама и соскабливания. То, что эффективно в Твиттере, может не быть эффективным на YouTube.

Мы все еще можем согласиться, поскольку прокси-компании предоставляют прокси, которые работают даже с самыми сложными веб-сайтами. Мы предоставим предложения по прокси-сервисам для частных лиц, а также по прокси-сервисам для центров обработки данных.

Хотя мобильные прокси часто являются лучшим вариантом, они не так рентабельны, как услуги резидентных прокси.

Имея доступ к более чем 175 миллионам IP-адресов по всему миру, Oxylabs предоставляет не только услуги прокси-сервера для центров обработки данных, но также поддержку резидентных серверов и искусственного интеллекта, чтобы помочь вам с легкостью анализировать сайты электронной коммерции.

Их искусственный интеллект призван помочь вам в синтаксическом анализе полученных данных, рендеринге JavaScript веб-страницы и обработке контрмер против ботов, таких как CAPTCHA.

Что касается геотаргетинга, Oxylabs предлагает карту, на которой показаны их прокси-сайты по всему миру, позволяя вам выбрать не только страну, но и город.

Это действительно полезная функция, поскольку они предоставляют IP-адреса практически из любой страны.

Организация управляет ротацией прокси, чтобы предоставить своим потребителям лучший опыт скрапинга. Если вам нужны еще более быстрые прокси, Oxylabs предлагает SOCKS5 прокси .

Если вы решите использовать прокси-серверы центров обработки данных, вы получите безграничную пропускную способность, и плата будет взиматься только за количество используемых вами прокси-серверов.

Однако, если вы решите использовать резидентные прокси, плата будет зависеть от используемой полосы пропускания.

Плюсы:

- Обширный пул прокси

- Глобальное покрытие сети

- Высокие эксплуатационные характеристики

- Интеллектуальные технологии парсинга веб-страниц

- Премиум поддержка клиентов

- Надежный и стабильный

Минусы:

- Ограниченный таргетинг по геолокации

- Ограниченное количество одновременных сессий

- Ограничения на использование данных

Это может показаться мечтой — парсить, не оставляя следов. Это возможно с Decodo Web Scraping API. Этот API может работать со многими различными веб-сайтами. Он даже может работать с веб-сайтами, которые используют много JavaScript, потому что у него есть headless scraper для этого.

Кроме того, Decodo предлагает несколько удобных функций, которые сделают ваш опыт сбора данных еще лучше. Во-первых, вы можете наслаждаться опытом сбора данных без CAPTCHA, поскольку этот инструмент поставляется с пулом прокси для жилых и дата-центров объемом 125 млн+.

Во-вторых, вы можете выбрать местоположение, из которого хотите сделать скрапинг — есть опция таргетинга на города по всему миру. Наконец, Decodo гарантирует 100%-ный успех. Чтобы сделать ваш опыт сбора данных отличным, вам понадобится всего 50 долларов в месяц + НДС.

Плюсы:

- Большой пул прокси

- Decodo предлагает конкурентоспособные цены по сравнению с другими провайдерами прокси-услуг, начиная с 12.5 долларов США за ГБ.

- Выбирайте прокси для домашнего использования, для центров обработки данных или мобильных устройств, которые наилучшим образом соответствуют вашим потребностям в парсинге.

- Доступ к данным из более чем 195 мест по всему миру, включая определенные города и штаты США.

- Удобная панель инструментов

Минусы:

- Ограниченная функциональность API

- Нет поддержки SOCKS5

- Более медленные скорости, чем у некоторых конкурентов

Webshare предлагает надежные и доступные прокси-серверы для веб-скрапинга, что делает его отличным выбором для предприятий и частных лиц, которым необходимо эффективно извлекать данные.

Благодаря большому пулу высокоскоростных прокси-серверов Webshare обеспечивает бесперебойный сбор данных без частых банов IP-адресов. Настраиваемые конфигурации прокси-серверов позволяют пользователям настраивать ротационные IP-адреса для бесперебойного сбора данных.

Удобная панель управления и API Webshare упрощают интеграцию как для новичков, так и для опытных пользователей.

Независимо от того, нужны ли вам прокси-серверы для мелкомасштабного сбора данных или крупных проектов по извлечению данных, Webshare предлагает экономически эффективное и стабильное решение.

Плюсы

- Доступные тарифные планы подходят

- Высокая продолжительность безотказной работы обеспечивает бесперебойную очистку

- Настраиваемые конфигурации прокси-сервера

- Ограниченные расширенные функции скрапинга

Минусы

4. .

Bright Data — поставщик услуг по извлечению данных и прокси-серверов с более чем 70 миллионами IP-адресов, который прост в использовании и не требует никакого кодирования или инфраструктуры.

Как выбрать подходящий веб-скрейпер для своих нужд

Apify — еще одно решение, облегчающее веб-парсинг. Оно не требует значительных навыков программирования и имеет простой в использовании интерфейс, что является одним из его значительных преимуществ. Как и ScraperAPI и Octoparse, Apify позволяет планировать работу парсеров:

Вот краткий обзор преимуществ и недостатков Apify Web Scraper:

Еще одним плюсом Apify является то, что он содержит около 2000 готовых. Они, по сути, представляют собой шаблоны кода, которые можно использовать для быстрой настройки задачи по парсингу. В настоящее время некоторые агенты позволяют легко выполнять парсинг результатов поиска Google, YouTube, продуктов Amazon, хэштегов Instagram, публикаций в Facebook и делать многое другое.

Одним из основных агентов является, который является основным инструментом Apify для веб-парсинга. С помощью инструмента Web Scraper вы можете выполнить парсинг любого веб-сатйа.

Кроме того, Apify дает вам возможность написать собственный код, используя любой удобный для вас фреймворк, и разместить его в облаке Apify. После завершения работы парсера собранные им данные становятся доступны в выбранном вами формате, например JSON или CSV.

Apify Web Scraper может стать для вас идеальным решением, если вы найдете в его библиотеке шаблон кода, подходящий для вашей конкретной задачи. Это, в сочетании с простотой использования, делает Apify интересным вариантом для конкретных случаев использования.

Какие из бесплатных веб-скрейперов 2025 года легче всего использовать

Существует множество разных веб-скрейперов, и каждый из них оснащен своим особым набором функций. Ниже в общих чертах описан принцип работы обычного веб-скрейпера:

- HTTP-запросы . Веб-скрейпер начинает с отправки HTTP-запроса на указанный URL-адрес с целью получить содержимое веб-страницы. Эта процедура идентична тому, как веб-браузер обращается к веб-страницам.

- Получение HTML . Сервер, на котором размещен веб-сайт, отвечает на запрос, отправляя HTML-содержимое веб-страницы. Этот HTML-код содержит все элементы (текст, изображения, ссылки и прочие элементы, составляющие веб-страницу).

- Синтаксический анализ HTML . Дальше веб-скрейпер приступает к синтаксическому анализу HTML. Он анализирует и интерпретирует HTML-содержимое, чтобы найти те разделы страницы, где содержатся нужные данные. Это предполагает использование таких инструментов, как библиотеки синтаксического анализа HTML, которые помогают перемещаться по структурным элементам HTML-кода.

- Извлечение данных . После того, как подходящие фрагменты HTML определены, скрейпер переходит к извлечению интересующих нас данных. Это может быть любая категория содержимого, в том числе текст, изображения, ссылки, таблицы и прочая информация, найденная на веб-странице.

- Очистка данных . В зависимости от качества HTML-кода и структуры страницы, может потребовать та или иная форма очистки и форматирования извлеченных данных. Сюда относится удаление лишних тегов и специальных символов. Этот этап гарантирует, что данные отформатированы и пригодны для дальнейшего использования.

- Запись данных . После того, как данные будут очищены, их необходимо организовать в структурированный формат. Для этого могут использоваться CSV-файлы, базы данных или какие-то другие решения для хранения данных, отвечающие намеченной цели.

- Обход страниц . В ситуациях, когда скрейперу необходимо собрать данные с нескольких страниц (например, при извлечении результатов поиска), он выполняет этот процесс итеративно, отправляя запросы на отдельные URL-адреса и извлекая, таким образом, данные с каждой страницы отдельно.

- Обработки динамического содержимого . Данные с веб-сайтов, которые используют JavaScript для загрузки динамического содержимого, требуют более сложных методов очистки после первоначального получения HTML. Это предполагает использование таких инструментов, как консольный браузер, или таких ресурсов, как Selenium, для того, чтобы скрейпер мог взаимодействовать со страницей как обычный пользователь, тем самым извлекая динамически загружаемое содержимое.

- Изучение robots.txt . Скрейпер должен придерживаться инструкциям, изложенным в файле сайта под названием robots.txt. В нем прописано, какие разделы можно извлекать, а какие нельзя. Соблюдение этих требований позволит вам избежать юридических и этических проблем.

- Ограничение скорости . Для того, чтобы не перегружать сервер веб-сайта огромным количеством запросов за короткий промежуток времени, скрейпер может внедрить специальные механизмы ограничения скорости. Эти механизмы предназначены для того, чтобы извлекать данные разумно и умеренно.

Можно ли использовать бесплатные веб-скрейперы для коммерческих целей

В: Что такое куки Cloudflare и почему они важны?

О: Куки Cloudflare, такие как CF clearance, используются для проверки того, что пользователь прошел проверки безопасности. Они необходимы для избежания блокировок IP и запретов со стороны веб-сайтов с низкой или средней защитой от ботов.

В: Как скрейперы получают блокировки со стороны веб-сайтов?

О: Скрейперы часто сталкиваются с блокировками из-за тестов JavaScript, выполняемых веб-сайтами, которые сравнивают поведение браузера с ожидаемыми результатами. Если скрейпер не имитирует браузер, его, вероятно, заблокируют.

В: Каковы преимущества использования модифицированных экземпляров браузеров для скрейпинга?

О: Использование модифицированных экземпляров браузеров позволяет скрейперам проходить тесты JavaScript и получать куки для последующих запросов, что повышает их способность скрейпить данные без блокировок.

В: Какую роль играют прокси в веб-скрейпинге?

О: Прокси обеспечивают высококачественные, безопасные и быстрые соединения, позволяя скрейперам поддерживать «липкие» сессии и снижать риск быть помеченными или заблокированными веб-сайтами.

В: Что такое Flare Solver и как он помогает в получении куки?

О: Flare Solver — это инструмент, который интегрируется с Chrome и использует недетектируемый драйвер для работы в качестве HTTP-сервиса. Он выполняет тесты JavaScript и возвращает HTML-страницу вместе с необходимыми куками.

В: Как я могу эффективно управлять куками в своем коде для скрейпинга?

О: Вы можете создать функцию для получения куков из Flare Solver и загрузки их в сессию с использованием «банки» куков, что помогает представить скрейпер как законного пользователя.

В: Почему куки CF важны для веб-скрейпинга?

О: Куки CF служат механизмом проверки от Cloudflare, указывая на успешное прохождение теста JavaScript, что критически важно для доступа к защищенному контенту без повторных запросов браузера.

В: Как я могу оставаться в курсе последних техник скрейпинга?

О: Важно оставаться в курсе последних методов и лучших практик в веб-скрейпинге, так как эта область постоянно развивается. Непрерывное обучение и адаптация являются ключевыми для преодоления современных мер против ботов.

Какие веб-скрейперы лучше всего справляются с анти-скрейпинговыми системами

От SQL до MATLAB

Дата-аналитики работают с терабайтами данных. Их нужно собрать, проанализировать и вывести в виде простых графиков и таблиц. В этом помогают специальные программы и сервисы — рассказываем про них в статье.

Чем занимается Data-аналитик

Дата-аналитик работает с большим количеством данных. Он отвечает за:

- Сбор данных: использует разные источники, например базы данных , результаты опросов, таблицы, сайты в интернете;

- Обработку: заполняет пропуски, исправляет ошибки, группирует и подготавливает данные к дальнейшей работе;

- Анализ: ищет закономерности и тренды, которые помогут решить какую-то проблему или улучшить метрики;

- Прогнозирование : строит статистическую модель, чтобы понять, как ситуация будет развиваться дальше;

- Визуализацию выводов: создает графики, таблицы и диаграммы, чтобы представить информацию в простом и понятном виде.

Для работы с данными дата-аналитик использует разные сервисы и программы.

Инструменты для сбора данных

SQL

Это язык для работы с базами данных. С его помощью можно извлекать информацию, добавлять новые данные, удалять устаревшую информацию, создавать новые таблицы на основе старых и т.д.

полезен при работы с большими объемами информации и является стандартом для большинства. Самые популярные их них:

- MySQL : позволяет хранить любые данные — контакты, даты, цены, имена, списки товаров и т.д.

MySQL client. Источник

- PostgreSQL : более сложная система, подходит для обработки запросов в сфере финансов и промышленности;

PostgreSQL. Источник

- Microsoft SQL Server : предназначена для управления большими объемами данных, поддерживает разные бизнес- приложения , например Oracle ERP или Tableau .

Microsoft SQL Server. Источник

Web-скрейпинг

Часто данные собирают в интернете из открытых источников. Например, можно спарсить сайты конкурентов, чтобы составить список товаров и определить среднюю цену.

Для этого используют библиотеки:

- BeautifulSoup: подходит для простых задач по извлечению данных из статических HTML -страниц;

- Selenium : применяют для работы с динамическим контентом. Может обрабатывать страницы, которые загружаются с помощью JavaScript ;

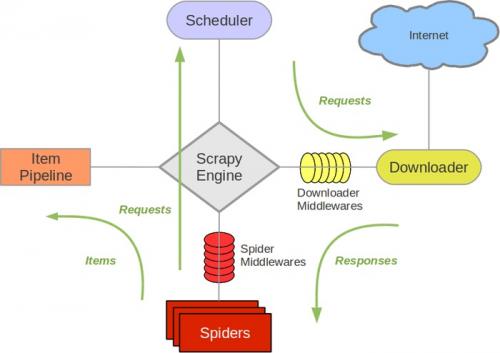

- Scrapy: мощный фреймворк для веб-скрейпинга. Позволяет быстро собрать данные со множества страниц.

Схема работы Scrapy Spider. Источник

ETL-инструменты

Собирать данные можно не только с сайтов, но также баз данных, таблиц, облачных хранилищ. В этом случае используют-инструменты: они извлекают информацию из разных источников и преобразовывают ее в единый формат.

Поддерживают ли бесплатные веб-скрейперы 2025 года выполнение JavaScript

Ucraft Next — это универсальный конструктор сайтов, предназначенный для создания уникальных сайтов и интернет-магазинов без какого-либо кодирования. Предлагая инструменты на базе искусственного интеллекта, пользователи могут разрабатывать потрясающие, адаптивные сайты с такими функциями, как настраиваемые шаблоны, функциональность перетаскивания и динамические виджеты. Платформа поддерживает бесшовную интеграцию с популярными инструментами, такими как Zoom, MailChimp и Hubspot, что повышает эффективность.

Для электронной коммерции Ucraft предоставляет обширные возможности, включая поддержку физических и цифровых продуктов, подписок, бронирований и мероприятий. Он обеспечивает продажи по всему миру с интеграциями для платежных шлюзов и перевозчиков, а встроенные инструменты SEO, аналитика и управление запасами оптимизируют операции.

Ucraft уделяет первостепенное внимание доступности с многоязычной поддержкой, обучающими материалами и экспертной помощью, что делает его идеальным для предприятий любого размера. Начните с 14-дневной бесплатной пробной версии, чтобы изучить его возможности и упростить создание веб-сайта и магазина.

- Создание веб-сайта: Создавайте адаптивные веб-сайты или магазины без особых усилий с помощью функции перетаскивания и инструментов искусственного интеллекта.

- Возможности электронной коммерции: Продавайте товары, управляйте бронированиями и интегрируйте варианты оплаты и доставки.

- Интеграция инструментов: Улучшите свой рабочий процесс, подключившись к таким популярным приложениям, как Zoom, MailChimp и Hubspot.

- SEO и аналитика: Оптимизируйте свой сайт для поисковых систем и получайте ценную информацию с помощью мощных инструментов аналитики.

- Клиентская поддержка: Получите доступ к многоязычной поддержке, подробным учебным пособиям и помощи экспертов для обеспечения успеха.

Какие инструменты лучше подходят для сбора больших объемов данных

Веб-скрейпинг возник для совершенно другой цели, и потребовалось почти 2 десятилетия, прежде он стал технологией, которая нам знакома сейчас.

Истоки самого простого веб-скрапинга можно проследить до 1989 года, когда британский ученый Тим Бернерс-Ли задумал Всемирную паутину.

Первоначально концепция была направлена на создание платформы для автоматического информационного обмена между учеными в университетах и институтах по всему миру.

Основной целью веб-сайтов было представление статической информации в формате HTML, что позволяло разработчикам относительно легко писать скрипты, которые могли бы извлекать данные программным путем.

Вскоре после этого, в 1993 году, появилась инаугурационная концепция веб-краулинга. Пионером в этой области был The Wanderer, а именно World Wide Web Wanderer, разработанный Мэтью Греем в Массачусетском технологическом институте.

Это был новаторский веб-краулер на основе Perl, задачей которого было измерить масштабы сети.

В тот же период времени в 1993 году материализовалась основополагающая технология, которая проложила путь для основных поисковых систем, таких как Google, Bing, Yahoo и других.

Со временем некоторые сайты начали использовать динамический контент: благодаря таким технологиям, как JavaScript, AJAX и Flash, они могли отслеживать поведение пользователя и формировать страницы специально для него. Это создало значительные проблемы для традиционных методов веб-скрейпинга, потребовав более продвинутых методов.

Разработчики начали изучать headless-браузеры, которые могли имитировать взаимодействие с пользователем, позволяя им получать доступ и извлекать данные из динамически генерируемых страниц.

RB.RU рекомендует лучших поставщиков цифровых решений для вашего бизнеса — по ссылке

Такие инструменты, как Selenium, PhantomJS и Puppeteer, стали играть важную роль в навигации по сложным современным веб-сайтам. Вскоре после этого родился веб-скрапинг в том виде, в котором мы его знаем.