10 Best Web Scraping Tools in 2023. 2023 Top 10 Best Web Scraping Tools for Data Extraction | Web Scraping Tool | ScrapeStorm

- 10 Best Web Scraping Tools in 2023. 2023 Top 10 Best Web Scraping Tools for Data Extraction | Web Scraping Tool | ScrapeStorm

- Web Scraping online. Лучшие сервисы для веб скрапинга данных: топ-7

- Excel extract Data from website. Проблема с нетабличными данными

- Web crawler Python. Build a Python Web crawler from scratch

10 Best Web Scraping Tools in 2023. 2023 Top 10 Best Web Scraping Tools for Data Extraction | Web Scraping Tool | ScrapeStorm

333 views

Abstract: This article will introduce the top10 best web scraping tools in 2023. ScrapeStorm Free Download

Web scraping tools are designed to grab the information needed on the website. Such tools can save a lot of time for data extraction.

Here is a list of 10 recommended tools with better functionality and effectiveness.

1. ScrapeStorm

ScrapeStorm is an AI-Powered visual web scraping tool,which can be used to extract data from almost any websites without writing any code.

It is powerful and very easy to use. You only need to enter the URLs, it can intelligently identify the content and next page button, no complicated configuration, one-click scraping.

ScrapeStorm is a desktop app available for Windows, Mac, and Linux users. You can download the results in various formats including Excel, HTML, Txt and CSV. Moreover, you can export data to databases and websites.

Features:

1) Intelligent identification

2) IP Rotation and Verification Code Identification

3) Data Processing and Deduplication

4) File Download

5) Scheduled task

6) Automatic Export

8) Automatic Identification of E-commerce SKU and big images

Pros:

1) Easy to use

2) Fair price

3) Visual point and click operation

4) All systems supported

Cons:

No cloud services

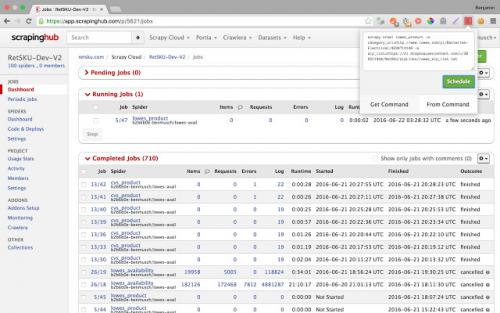

2.ScrapingHub

Scrapinghub is the developer-focused web scraping platform to offer several useful services to extract structured information from the Internet.

Scrapinghub has four major tools – Scrapy Cloud, Portia, Crawlera, and Splash.

Features:

1) Allows you to converts the entire web page into organized content

2) JS on-page support toggle

3) Handling Captchas

Pros:

1) Offer a collection of IP addresses covered more than 50 countries which is a solution for IP ban problems

2) The temporal charts were very useful

3) Handling login forms

4) The free plan retains extracted data in cloud for 7 days

Cons:

1) No Refunds

2) Not easy to use and needs to add many extensive add-ons

3) Can not process heavy sets of data

3.Dexi.io

Web Scraping & intelligent automation tool for professionals. Dexi.io is the most developed web scraping tool which enables businesses to extract and transform data from any web source through with leading automation and intelligent mining technology.

Dexi.io allows you to scrape or interact with data from any website with human precision. Advanced feature and APIs helps you transform and combine data into powerfull datasets or solutions.

Features:

1) Provide several integrations out of the box

2) Automatically de-duplicate data before sending it to your own systems.

3) Provide the tools when robots fail

Pros:

1) No coding required

2) Agents creation services available

Cons:

1) Difficult for non-developers

2) Trouble in Robot Debugging

4.Diffbot

https://www.youtube.com/embed/qH9VYKxU1NI

Diffbot allows you to get various type of useful data from the web without the hassle. You don’t need to pay the expense of costly web scraping or doing manual research. The tool will enable you to exact structured data from any URL with AI extractors.

Web Scraping online. Лучшие сервисы для веб скрапинга данных: топ-7

Рассказываем, что такое веб скрапинг, как применяют данные полученные этим способом, и какие сервисы для веб скрапинга существуют на рынке.

В октябре 2020 года Facebook подал жалобу в федеральный суд США против двух компаний, обвиняемых в использовании двух вредоносных расширений для браузера Chrome. Эти расширения позволяют выполнять скрапинг данных без авторизации в Facebook, Instagram, Twitter, LinkedIn, YouTube и Amazon.

Оба расширения собирали публичные и непубличные данные пользователей. Компании продавали эти данные, которые затем использовались для маркетинговой разведки.

В этой статье мы разберемся, как выполнять скрапинг данных легально, и расскажем про семь сервисов для веб скрапинга, которые не требуют написания кода. Если вы хотите выполнять скрапинг самостоятельно, прочитайтеинструментов и библиотек для скрапинга.

Что такое скрапинг данных?

Скрапинг данных или веб скрапинг – это способ извлечения информации с сайта или приложения (в понятном человеку виде) и сохранение её в таблицу или файл.

Это не нелегальная техника, однако способы использования этих данных могут быть незаконными. В следующем

Как используют эти данные

Веб скрапинг имеет широкий спектр применений. Например, маркетологи пользуются им для оптимизации процессов.

1. Отслеживание цен

Собирая информацию о товарах и их ценах на Amazon и других платформах, вы можете следить за вашими конкурентами и адаптировать свою ценовую политику.

2. Рыночная и конкурентная разведка

Если вы хотите проникнуть на новый рынок и хотите оценить возможности, анализ данных поможет вам сделать взвешенное и адекватное решение.

3. Мониторинг соцсетей

YouScan, Brand Analytics и другие платформы для мониторинга соцсетей используют скрапинг.

4. Машинное обучение

С одной стороны, машинное обучение и AI используются для увеличения производительности скрапинга. С другой стороны, данные, полученные с его помощью, используют в машинном обучении.

Интернет — это важный источник данных для алгоритмов машинного обучения.

5. Модернизация сайтов

Компании переносят устаревшие сайты на современные платформы. Для того чтобы быстро и легко экспортировать данные, они могут использовать скрапинг.

6. Мониторинг новостей

Скрапинг данных из новостных сайтов и блогов позволяет отслеживать интересующие вас темы и экономит время.

7. Анализ эффективности контента

Блоггеры или создатели контента могут использовать скрапинг для извлечения данных о постах, видео, твитах и т. д. в таблицу, например, как на видео выше.

Данные в таком формате:

- легко сортируются и редактируются;

- просто добавить в БД;

- доступны для повторного использования;

- можно преобразовать в графики.

Сервисы для веб скрапинга

Скрапинг требует правильного парсинга исходного кода страницы, рендеринга JavaScript, преобразования данных в читаемый вид и, по необходимости, фильтрации. Поэтому существует множество готовых сервисов для выполнения скрапинга.

Вот топ-7 инструментов для скрапинга, которые хорошо справляются с этой задачей.

1. Octoparse

Octoparse — это простой в использовании скрапер для программистов и не только. У него есть бесплатный тарифный план и платная подписка.

Особенности:

- работает на всех сайтах: с бесконечным скроллом, пагинацией, авторизацией, выпадающими меню, AJAX и т.д.

- сохраняет данные в Excel, CSV, JSON, API или БД.

- данные хранятся в облаке.

- скрапинг по расписанию или в реальном времени.

- автоматическая смена IP для обхода блокировок.

- блокировка рекламы для ускорения загрузки и уменьшения количества HTTP запросов.

- можно использовать XPath и регулярные выражения.

- поддержка Windows и macOS.

- бесплатен для простых проектов, 75$/месяц — стандартный, 209$/месяц — профессиональный и т. д.

2. ScrapingBee

ScrapingBee Api использует «безголовый браузер» и смену прокси. Также имеет API для скрапинга результатов поиска Google.

Особенности:

- рендеринг JS;

- ротация прокси;

- можно использовать с Google Sheets и браузером Chrome;

- бесплатен до 1000 вызовов API, 29$/месяц — для фрилансеров, 99$/месяц — для бизнеса и т.д.

3. ScrapingBot

ScrapingBot предоставляет несколько API: API для сырого HTML, API для сайтов розничной торговли, API для скрапинга сайтов недвижимости.

Excel extract Data from website. Проблема с нетабличными данными

С загрузкой в Excel табличных данных из интернета проблем нет. Надстройка Power Query в Excel легко позволяет реализовать эту задачу буквально за секунды. Достаточно выбрать на вкладке Данные команду Из интернета (Data - From internet) , вставить адрес нужной веб-страницы (например, ключевых показателей ЦБ ) и нажать ОК :

Power Query автоматически распознает все имеющиеся на веб-странице таблицы и выведет их список в окне Навигатора :

Дальше останется выбрать нужную таблицу методом тыка и загрузить её в Power Query для дальнейшей обработки (кнопка Преобразовать данные ) или сразу на лист Excel (кнопка Загрузить ).

Если с нужного вам сайта данные грузятся по вышеописанному сценарию - считайте, что вам повезло.

К сожалению, сплошь и рядом встречаются сайты, где при попытке такой загрузки Power Query "не видит" таблиц с нужными данными, т.е. в окне Навигатора попросту нет этих Table 0,1,2… или же среди них нет таблицы с нужной нам информацией. Причин для этого может быть несколько, но чаще всего это происходит потому, что веб-дизайнер при создании таблицы использовал в HTML-коде страницы не стандартную конструкцию с тегом

Web crawler Python. Build a Python Web crawler from scratch

Why would anyone want to collect more data when there is so much already? Even though the magnitude of information is alarmingly large, you often find yourself looking for data that is unique to your needs.

For example, what would you do if you wanted to collect info on the history of your favorite basketball team or your favorite ice cream flavor?

Enterprise data collection is essential in the day-to-day life of a data scientist because the ability to collect actionable data on trends of the modern-day means possible business opportunities.

In this tutorial, you’ll learn about web crawling via a simple online store.

HTML anatomy refresher

Let’s review basic HTML anatomy. Nearly all websites on the Internet are built using the combination of HTML and CSS code (including JavaScript, but we won’t talk about it here).

Below is a sample HTML code with some critical parts annotated.

The HTML code on the web will be a bit more complicated than this, however. It will be nearly impossible to just look at the code and figure out what it’s doing. For this reason, we will learn about more sophisticated tools to make sense of massive HTML pages, starting with XPath syntax.

XPath with lxml

The whole idea behind web scraping is to use automation to extract information from the massive sea of HTML tags and their attributes. One of the tools, among many, to use in this process is using XPath.

XPath stands for XML path language. XPath syntax contains intuitive rules to locate HTML tags and extract information from their attributes and texts. For this section, we will practice using XPath on the HTML code you saw in the above picture:

sample_html = """

To start using XPath to query this HTML code, we will need a small library:

pip install lxml

LXML allows you to read HTML code as a string and query it using XPath. First, we will convert the above string to an HTML element using thefromstringfunction:

from lxml import html

source = html.fromstring(sample_html)

>>> source

Now, let’s write our first XPath code. We will select the bookstore tag first:

>>> source.xpath("//bookstore") >

As you can see, we get a list of two book tags. Now, let’s see how to choose an immediate child of a tag. For example, let’s select the title tag that comes right inside the book tag:

>>> source.xpath("//book/title") >

We only have a single element, which is the first title tag. We didn’t choose the second tag because it is not an immediate child of the second book tag. But we can replace the single forward slash with a double one to choose both title tags:

>>> source.xpath("//book//title")

,

Now, let’s see how to choose the text inside a tag:

>>> source.xpath("//book/title/text()")

Here, we are selecting the text inside the first title tag. As you can see, we can also specify which of the title tags we want using brackets notation. To choose the text inside that tag, just follow it with a forward slash and atext()function.

Finally, we look at how to locate tags based on their attributes likeid,class,href,or any other attribute inside. Below, we will choose the title tag with the name class:

>>> source.xpath("//title") >

As expected, we get a single element. Here are a few examples of choosing other tags using attributes:

>>> source.xpath("//*") # choose any element with id 'main'

>

>>> source.xpath("//title") # choose a title tag with 'lang' attribute of 'en'.

,

I suggest you look at this page to learn more about XPath.

In today's digital age, data is everywhere. With the vast amount of information available, it's easy to get lost in the noise. But, what if you need specific data that's unique to your needs? That's where web crawling comes in.

Collecting Data for a Purpose

Imagine you're a sports enthusiast and you want to collect information about your favorite basketball team. Or, maybe you're a foodie and you want to know more about your favorite ice cream flavor. Web crawling allows you to collect data that's relevant to your interests.

Enterprise Data Collection

In the world of business, data collection is crucial. With the ability to collect actionable data on trends, you can identify potential business opportunities. This is where web crawling comes in.

Getting Started with Web Crawling

In this tutorial, we'll be using a simple online store as an example. We'll start by reviewing the basics of HTML anatomy. HTML is the standard markup language used to create web pages. It's made up of a series of elements, which are represented by tags.

HTML Anatomy

Let's take a look at a sample HTML code with some critical parts annotated:

<html> <head> <title>Online Store</title> </head> <body> <h1>Welcome to our online store</h1> <p>This is our online store, where you can find the latest products and deals.</p> </body> </html>

As you can see, HTML code is made up of a series of elements, which are represented by tags. These tags are used to define the structure and content of a web page. In this example, we have the following elements:

- <html> - The root element of the document

- <head> - The head element, which contains metadata about the document

- <title> - The title element, which sets the title of the page

- <body> - The body element, which contains the content of the page

- <h1> - The h1 element, which represents a heading

- <p> - The p element, which represents a paragraph of text

Using XPath to Extract Data

Now that we've reviewed the basics of HTML, let's talk about XPath. XPath is a query language that allows us to extract data from an XML document. In the context of web crawling, XPath is used to extract data from HTML documents.

Let's take a look at an example of how we can use XPath to extract data from the HTML code above:

//title

This XPath expression extracts the value of the <title> element. We can also use XPath to extract other elements, such as the <h1> or <p> elements.

Conclusion

In this tutorial, we've covered the basics of web crawling and how to use XPath to extract data from HTML documents. We've also reviewed the importance of data collection in the world of business and how web crawling can be used to collect data that's relevant to your needs.