Top Website Data Scraper Tools for Efficient Web Data Extraction

- Top Website Data Scraper Tools for Efficient Web Data Extraction

- Связанные вопросы и ответы

- Что такое веб-сканер данных

- Какие преимущества использования веб-сканеров данных

- Какие типы веб-сканеров данных существуют

- Какие факторы следует учитывать при выборе веб-сканера данных

- Какие популярные веб-сканеры данных существуют на рынке

- Как веб-сканеры данных работают

- Какие ограничения могут быть связаны с использованием веб-сканеров данных

Top Website Data Scraper Tools for Efficient Web Data Extraction

H1

Introduction

H2

Data scraping is a process of extracting data from websites. It is a crucial task for businesses, researchers, and individuals who need to gather information from the web. However, manually scraping data from websites can be time-consuming and inefficient. Fortunately, there are several website data scraper tools available that can help you extract data efficiently. In this article, we will discuss the top website data scraper tools for efficient web data extraction.

H2

Top Website Data Scraper Tools

H3

1. Octoparse

Octoparse is a powerful web scraping tool that allows you to extract data from websites without any coding skills. It has a user-friendly interface and provides various features such as scheduling, cloud extraction, and API integration. Octoparse also offers a free version with limited features.

H3

2. ParseHub

ParseHub is another popular web scraping tool that allows you to extract data from websites without any coding skills. It has a user-friendly interface and provides various features such as scheduling, cloud extraction, and API integration. ParseHub also offers a free version with limited features.

H3

3. Scrapy

Scrapy is an open-source web scraping framework written in Python. It allows you to extract data from websites efficiently and can be customized to suit your needs. Scrapy also provides various features such as scheduling, cloud extraction, and API integration.

H3

4. Beautiful Soup

Beautiful Soup is a Python library for web scraping. It allows you to extract data from websites efficiently and can be customized to suit your needs. Beautiful Soup also provides various features such as HTML parsing and CSS selectors.

H3

5. WebHarvy

WebHarvy is a visual web scraping tool that allows you to extract data from websites without any coding skills. It has a user-friendly interface and provides various features such as scheduling, cloud extraction, and API integration. WebHarvy also offers a free version with limited features.

H2

Conclusion

H2

In conclusion, website data scraper tools are essential for efficient web data extraction. The top website data scraper tools discussed in this article are Octoparse, ParseHub, Scrapy, Beautiful Soup, and WebHarvy. These tools provide various features such as scheduling, cloud extraction, and API integration, making them ideal for businesses, researchers, and individuals who need to gather information from the web.

Связанные вопросы и ответы:

1. Что такое веб-скрапер

Веб-скрапер - это программное обеспечение или скрипт, который используется для извлечения данных с веб-сайтов. Оно может автоматически сканировать веб-страницы, находить нужные данные и собирать их в удобном для анализа формате. Веб-скраперы могут использоваться для различных целей, таких как создание баз данных, анализ рынка, сбор информации о конкурентах и т.д.

2. Какие типы данных можно извлечь с помощью веб-скрапера

С помощью веб-скрапера можно извлекать различные типы данных, такие как текст, изображения, видео, таблицы, формы и т.д. Они могут быть использованы для создания баз данных, анализа рынка, сбор информации о конкурентах и т.д.

3. Какие функции должен иметь хороший веб-скрапер

Хороший веб-скрапер должен быть простым в использовании, быстро и надежно работать, иметь возможность извлечения различных типов данных, поддерживать различные языки программирования, иметь возможность сохранения данных в различных форматах, иметь возможность работы с защищенными сайтами и т.д.

4. Какие сайты можно извлекать данные с помощью веб-скрапера

С помощью веб-скрапера можно извлекать данные с любых веб-сайтов, но важно помнить о том, что некоторые сайты могут иметь ограничения на использование их контента. Также некоторые сайты могут иметь защиту от автоматического извлечения данных, что может сделать их не доступными для веб-скраперов.

5. Какие ограничения могут быть на извлечение данных с веб-сайтов

Некоторые сайты могут иметь ограничения на использование их контента, что может сделать их не доступными для веб-скраперов. Также некоторые сайты могут иметь защиту от автоматического извлечения данных, что может сделать их не доступными для веб-скраперов.

6. Как выбрать лучший веб-скрапер для извлечения данных с веб-сайтов

Чтобы выбрать лучший веб-скрапер для извлечения данных с веб-сайтов, важно подумать о своих потребностях и выбрать программное обеспечение, которое наилучшим образом соответствует этим потребностям. Важно также учитывать функциональность программного обеспечения, его скорость и надежность работы, а также наличие технической поддержки и документации.

7. Какие программные продукты можно использовать для извлечения данных с веб-сайтов

Существует множество программных продуктов, которые можно использовать для извлечения данных с веб-сайтов. Некоторые из самых популярных программных продуктов для веб-скрапинга включают BeautifulSoup, Scrapy, Selenium, Puppeteer и т.д.

8. Как избежать проблем с извлечением данных с веб-сайтов

Чтобы избежать проблем с извлечением данных с веб-сайтов, важно помнить о том, что некоторые сайты могут иметь ограничения на использование их контента. Также важно использовать программное обеспечение, которое наилучшим образом соответствует потребностям и имеет возможность работы с защищенными сайтами. Важно также учитывать скорость и надежность работы программного обеспечения, а также наличие технической поддержки и документации.

Что такое веб-сканер данных

– это фреймворк с открытым исходным кодом для платформы Linux, основанный на, поддерживаемый Национальным институтом стандартов и технологий США ( NIST ). Проект OpenSCAP создает инструменты с открытым исходным кодом для реализации и внедрения этого открытого стандарта, используемого для перечисления недостатков и неправильной конфигурации.

Сканер предоставляет обширный набор инструментов, поддерживающихвеб-приложений, сетевой инфраструктуры, баз данных и хостов. В отличие от большинства сканеров, проверяющих общие уязвимости и уязвимости ( CVE ), OpenSCAP тестирует устройство на соответствие стандарту SCAP . Разработчики создали OpenVAS как многоцелевой сканер, используя последний доступный открытый код Nessus, который сейчас является ведущим на рынке коммерческим продуктом, выпускаемым компанией Tenable. OpenVAS поддерживает высокие возможности для проведения крупномасштабных оценок и тестов на уязвимость сети на традиционных конечных точках и сетях. Инструмент собирает сведения из огромного количества источников и обширной базы данных уязвимостей. Nmap Security Scanner поддерживает бинарные пакеты для Windows, macOS и Linux и включен во многие сборки Linux. Nmap использует IP-пакеты для сканирования портов устройств и определения того, какие хосты, службы и операционные системы доступны с проверяемого ресурса. Специалисты по тестированию на проникновение и ИТ-команды ценят nmap как быстрый, эффективный и легкий инструмент для составления списка открытых портов системы.Ключевые особенности

Плюсы

Минусы

OpenVAS – лучший для сканирования сетевых узлов и сетей в целом

Ключевые особенности

Плюсы

Минусы

Nmap – лучший для сканирования сетей и портов

Основные возможности

Плюсы

Минусы

Зарубин Иван Эксперт по Linux и Windows

Парашютист со стажем. Много читаю и слушаю подкасты. Люблю посиделки у костра, песни под гитару и приближающиеся дедлайны. Люблю путешествовать.

Какие преимущества использования веб-сканеров данных

Для современных компаний и различных предприятий сканирование страниц сайта имеет много положительных качеств. К ним можно отнести:

- получение доступа к огромному количеству информации – сканирование позволяет компаниям получать сведения из разных интернет-источников, что позволяет анализировать и использовать данные в своих бизнес-задачах;

- глубокое погружение – углубленное сканирование отдельных веб-страниц, чтобы отыскать сведения в самых глубоких «закоулках» глобальной сети;

- автоматизация – сканирование дает возможность автоматизировать получение информации, что, в свою очередь, позволяет сэкономить временные затраты компании, по сравнению с ручным поиском необходимой информации;

- обеспечение высокого качества – поисковые роботы лучше оценивают качество содержимого сайтов, поэтому этот инструмент очень подходит для выполнения задач по контролю качества;

- конкурентные преимущества – анализ данных, полученных путем веб-собирания, может помочь компаниям выявить новые тренды, отслеживать действия конкурентов и принимать более обоснованные бизнес-решения;

- более адекватное понимание рынка и клиентов – с помощью веб-сканирования компаниям удается получать более глубокое понимание потребностей своих клиентов, рыночной динамики, что помогает в разработке более эффективных маркетинговых стратегий;

- работа в настоящем режиме времени – интернет-мониторинг подойдет предприятиям и организациям, которые нуждаются в срочном получении информации;

- мониторинг изменений – метод позволяет отслеживать перемены на сайтах, включая расценки, акционные предложения, комментарии клиентов и прочее;

- продуктивность – автоматизированное получение сведений дает возможность сотрудникам компании сконцентрировать свое время на проработку и эксплуатацию сведений, вместо траты времени на ручной сбор сведений.

Какие типы веб-сканеров данных существуют

Посредством WASS-сканера может осуществляться проверка на наличие системных ошибок, тестирование на проникновение, а также контроль соответствия различным стандартам безопасности.

Типовая работа WASS-сканера заключается в сканировании веб-приложения на наличие уязвимостей и выглядит следующим образом:

- выбор объекта сканирования;

- проведение сканирования (оценки безопасности) веб-приложения (может проводиться анализ на наличие системных ошибок и уязвимостей, а также на предмет соответствия различным стандартам безопасности);

- формирование отчетности (о найденных системных ошибках и уязвимостях, о соответствии стандартам безопасности) и рекомендаций по устранению ошибок, уязвимостей и несоответствий стандартам безопасности.

WASS-сканеры могут использоваться на постоянной основе (при этом продукт разворачивается на выделенном аппаратном обеспечении и постоянно функционирует в автоматизированном режиме), а также разово, когда WASS-сканер запускается только администратором при необходимости проведения проверки. При использовании автоматизированного функционала WASS-сканера (сканирование проводится автоматически по заданному расписанию) доступна функция оперативного оповещения ответственных лиц о найденных уязвимостях.

Также на рынке присутствуют продукты класса Open Source, предназначенные для тестирования безопасности веб-приложений. К подобным продуктам, например, можно отнести такие решения, как проект w3af (фреймворк, позволяющий использовать более сотни различных плагинов для исследования сайта, поиска уязвимостей и их последующей эксплуатации) и Gryffin (открытый сканер безопасности, предназначенный для проведения всесторонних проверок безопасности в веб, охватывающих различные аспекты работы веб-приложений).

Какие факторы следует учитывать при выборе веб-сканера данных

Сканирование, как и анализ защищённости, можно выполнять как чёрным ящиком, так и белым ящиком.

Black Box

При blackbox-сканировании инструмент должен уметь работать с сервисом через те же интерфейсы, через которые с ним работают пользователи.Сканеры инфраструктуры (Tenable Nessus, Qualys, MaxPatrol, Rapid7 Nexpose и т.д.) ищут открытые сетевые порты, собирают «баннеры», определяют версии установленного ПО и ищут в своей базе знаний информацию об уязвимостях в этих версиях. Также пытаются обнаружить ошибки конфигурации, такие как пароли по умолчанию или открытый доступ к данным, слабые шифры SSL и т.д.Сканеры веб-приложений (Acunetix WVS, Netsparker, Burp Suite, OWASP ZAP, и т.д.) тоже умеют определять известные компоненты и их версии (например, CMS, фреймворки, JS-библиотеки). Основные шаги сканера — это краулинг и фаззинг.В ходе краулинга сканер собирает информацию о существующих интерфейсах приложения, HTTP-параметрах. В ходе фаззинга во все обнаруженные параметры подставляются мутированные или сгенерированные данные с целью спровоцировать ошибку и обнаружить уязвимость.Такие сканеры приложений относятся к классам DAST и IAST — соответственно Dynamic и Interactive Application Security Testing.White Box

При whitebox-сканировании различий больше.В рамках процесса VM сканерам (Vulners, Incsecurity Couch, Vuls, Tenable Nessus и т.д.) зачастую дают доступ к системам, проводя аутентифицированный скан. Таким образом, сканер может выгрузить установленные версии пакетов и конфигурационные параметры прямо из системы, не угадывая их по баннерам сетевых сервисов.Скан получается точнее и полнее.Если же говорить о whitebox-сканировании (CheckMarx, HP Fortify, Coverity, RIPS, FindSecBugs и т.д.) приложений, то речь обычно идёт о статическом анализе кода и использовании соответствуюбщих инструментов класса SAST — Static Application Security Testing.Какие популярные веб-сканеры данных существуют на рынке

Данный способ в первую очередь предусматривает использование сканеров безопасности, а также дополнительных инструментов, автоматизирующих некоторые сценарии эксплуатации и выявления уязвимостей. Из наиболее популярных сканеров безопасности можно выделить Acunetix Web Security Scanner, HP Web Inspect и Positive Technologies MaxPatrol (ранее XSpider). Дополнительно может применяться утилита sqlmap, исследующая наличие SQL-инъекций, а также различные утилиты класса fuzzing, суть которых состоит в подаче намеренно некорректных данных на вход приложения и анализе возвращаемых им данных.

Инструментальное обследование является наиболее простым и как следствие наиболее распространенным способом анализа защищенности Web-приложений. За простоту приходится расплачиваться ошибками «второго рода» (false negative) — пропуском части уязвимостей, которым подвержено исследуемое приложение. Например, сегодня сканеры не могут самостоятельно (то есть без использования сигнатур) выявить такие уязвимости, как небезопасное восстановление паролей (Weak Password Recovery Validation), отсутствие тайм-аута сессии (Insufficient Session Expiration) или логические атаки.

Если объектом атаки будет приложение, использующее рабочий процесс, в свою очередь реализующий некую бизнес-задачу, то это приложение может оказаться уязвимым, если не осуществляются проверки выполнения всех предыдущих этапов процесса. Предположим, что существует Web-приложение, которое использует некий процесс для активации денежной суммы с пластиковой карты. На первом этапе этого процесса приложение удостоверяется в корректности данных, вводимых пользователем, затем идет проверка, числится ли эта пластиковая карта в базе клиентов банка и соответствует ли запрашиваемая сумма номиналу счета. При отрицательном результате пользователь получает сообщение об ошибке. На последнем этапе этого процесса происходит изменение баланса счета пользователя в соответствии с введенными данными на первом этапе. Успешная атака на такое приложение может быть реализована в том случае, если существует возможность обратиться к последнему этапу процесса (пополнение счета) с передачей произвольной суммы для изменения баланса. Сканер безопасности пропустит подобную уязвимость — ему не известно, что была выполнена операция пополнения счета с произвольной суммой. Все, чем будет располагать сканер безопасности, это то, что при обращении к «такой-то» странице, на ней меняется «такое-то» значение и с его точки зрения — это не является уязвимостью. По такому же принципу может работать вполне безопасное приложение, например новостная лента или доска объявлений.

Как веб-сканеры данных работают

Кибербезопасность – это защита критически важных систем и конфиденциальной информации от цифровых атак со стороны злоумышленников. Данные меры, также известные, как безопасность информационных технологий, предназначены для борьбы с угрозами, которым подвергаются сетевые системы и приложения, независимо от того, исходят ли они изнутри компании или находятся за ее пределами .

В последнее десятилетие киберпреступность особенно сильно ударила по передовым государствам. Исследователи полагают, что каждый житель таких стран должен ожидать, что все его личные данные могут быть украдены без его ведома в любое время .

Компании, которые не смогли защитить персональные данные сотрудников и пользователей, рискуют сильно испортить свою репутацию на рынке. Согласно исследованиям, 59% российских компаний в 2019 году столкнулись с утечками информации. Однако 63% из пострадавших от кибератак организаций скрыли данный инцидент от своих сотрудников и клиентов .

По статистике, более половины всех киберпреступлений совершаются против предприятий малого и среднего бизнеса, а 60% из них прекращают свою деятельность в течение шести месяцев после того, как стали жертвами утечки данных или взлома . Это может быть связано с тем, что данным предприятиям не хватает финансовых ресурсов и навыков для борьбы с возникающей киберугрозой.

Исследователи полагают, что глобальные затраты на киберпреступность будут расти на 15% в год в течение следующих пяти лет, достигнув 10,5 триллионов долларов в год к 2025 году по сравнению с 3 триллионами в 2015 году . Последствия от кибератак значительно превышают ущерб, нанесенный стихийными бедствиями за год, и могут быть более прибыльными для преступников, чем глобальная торговля всеми основными незаконными наркотиками вместе взятыми.

Оценка стоимости ущерба основана на исторических данных о киберпреступности, включая рост по сравнению с предыдущим периодом, резкое увеличение хакерских атак со стороны враждебных национальных государств и организованных преступных группировок.

«Мы считаем, что данные – это явление нашего времени», – сказала Джинни Рометти, исполнительный председатель IBM Corporation. «Это новая основа конкурентного преимущества, которая меняет каждую профессию и отрасль. Киберпреступность по определению представляет собой величайшую угрозу для каждой профессии, каждой отрасли, каждой компании в мире» .

Последствия от киберпреступности включают в себя:

- повреждение и уничтожение важной информации;

- кражу денег, интеллектуальной собственности, личных данных;

- снижение эффективности предприятия;

- нарушение нормального ведения бизнеса после атаки;

- расследования и судебные разбирательства;

- восстановление утерянных данных;

- налаживание системы безопасности;

- возмещение репутационного ущерба всем пострадавшим.

Затраты на восстановление обычно составляют наибольшую часть от общей суммы. Важно отметить, что их можно снизить с помощью внутренних политик, регламентов, процедур, технологий и обучения правилам кибербезопасности .

Какие ограничения могут быть связаны с использованием веб-сканеров данных

Теперь, когда важность сканирования и индексирования вопросов не вызывает, давайте рассмотрим некоторые элементы вашего сайта, которые влияют на эти процессы, и обсудим способы оптимизации под них.

1. Улучшение скорости загрузки страниц

Учитывая миллиарды страниц, которые нужно каталогизировать, у веб-пауков нет целого дня, чтобы ждать, пока ваш сайт соизволит загрузиться. Здесь обычно принято делать отсылку к краулинговому бюджету.

Если страницы вашего сайта не загружаются в течение установленного времени, пауки покинут его. И это приведёт к недостаточному уровню сканирования и индексации. А это, как вы понимаете, не очень хорошо для SEO.

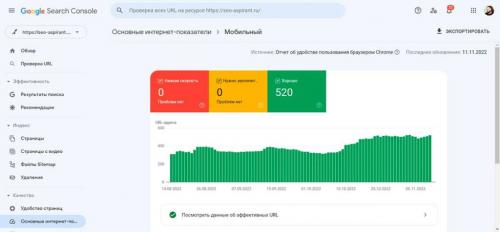

Поэтому хорошей практикой будет следить за скоростью загрузки страниц вашего сайта и улучшать её там, где это возможно. Обязательно используйте для этого Google Search Console и любой доступный SEO-софт .

Если ваш сайт работает медленно, примите меры по устранению проблем. Это может включать модернизацию сервера или хостинга , включение сжатия, минификацию CSS, JavaScript и HTML , а также устранение или уменьшение количества редиректов.

Выяснить, что замедляет время загрузки сайта, можно с помощью отчёта Core Web Vitals . Если вам нужна дополнительная информация, особенно с точки зрения пользователя, Google Lighthouse – инструмент с открытым исходным кодом, который точно поможет.

2. Укрепление структуры внутренней перелинковки

Хорошая структура сайта и внутренняя перелинковка являются основополагающими элементами успешной SEO-стратегии . Неорганизованный сайт трудно просмотреть поисковым системам, поэтому внутренняя перелинковка является одной из самых важных вещей, которые может сделать SEO-специалист.

Но не верьте мне на слово. Вот что сказал по этому поводу Джон Мюллер из Google:

Внутренняя перелинковка очень важна для SEO. Я думаю, что это одна из самых важных вещей, которые вы можете сделать на сайте, чтобы направлять Google и посетителей на страницы, которые считаете важными.

Если у вас плохая внутренняя перелинковка, вы также рискуете получить страницы-сироты или страницы, не имеющие ссылок на другие части вашего сайта. Поскольку на эти страницы нет путей, единственный способ для поисковых систем найти их – карта сайта.

Чтобы устранить эту и другие проблемы, вызванные плохой архитектурой сайта, создайте логичную внутреннюю структуру для вашего проекта.

Главная страница вашего сайта должна ссылаться на внутренние разделы, поддерживаемые страницами, расположенными ниже по пирамиде. Эти подстраницы должны иметь контекстные ссылки там, где это кажется естественным.

Ещё одна вещь, за которой следует следить, – неработающие ссылки, в том числе с опечатками в URL. Это влечёт за собой критичную ошибку 404 ( страница не найдена ). А неработающие ссылки вредят краулингу.

Дважды проверьте свои URL-адреса, особенно если вы недавно провели миграцию сайта , массовое удаление страниц или изменение структуры. Убедитесь, что вы не ссылаетесь на старые или удалённые URL.

Другие хорошие практики для внутренней перелинковки :

- достаточный объём контента (контент – всегда король);

- использование анкорных текстовых ссылок вместо ссылок-картинок;

- разумное количество ссылок на страницах.

Да, и убедитесь, что вы используете атрибут «follow» для своих внутренних ссылок.

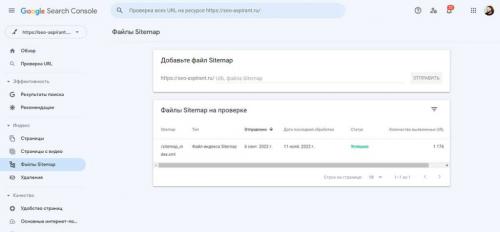

3. Скормите файл Sitemap поисковым системам

Расскажу на примере Google.

Если у вас достаточно времени и вы не запрещали ему это делать, Google, когда-нибудь, пройдётся по вашему сайту. И это замечательно, но это не поможет вам ранжироваться в органическом поиске , пока вы ждёте.

Если вы недавно внесли изменения в контент своего сайта и хотите, чтобы Google сразу же узнал об этом, стоит отправить карту сайта в Google Search Console.

Карта сайта – это ещё один файл, который находится в корневом каталоге вашего проекта. Он выступает дорожной картой для поисковых систем, включая прямые ссылки на каждую страницу вашего сайта.

Это полезно для индексации, поскольку позволяет Google узнавать о нескольких страницах одновременно. Если для обнаружения страницы в глубине сайта поисковой машине может потребоваться пройти по пяти внутренним ссылкам, то, при отправке XML sitemap, она сможет найти все ваши страницы за одно посещение.

Отправка карты сайта в Google особенно полезна, если у вас «глубокий» сайт, вы часто добавляете новые страницы или контент, или на вашем сайте нет хорошей внутренней перелинковки.