Запуск нескольких парсеров по очереди. Запуск парсера по расписанию

- Запуск нескольких парсеров по очереди. Запуск парсера по расписанию

- Бесплатный парсер сайтов. Удаленные решения

- Парсер сайтов в excel. Как парсить сайты при помощи экселя VBA

- Парсинг сайтов. «Юриста вызывали? Цитировать нельзя парсить»

- Парсинг сайтов Python. Учимся парсить веб-сайты на Python + BeautifulSoup

Запуск нескольких парсеров по очереди. Запуск парсера по расписанию

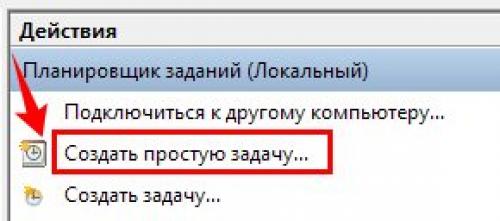

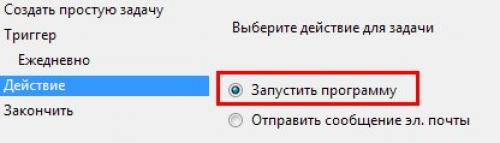

Есть возможность настроить автоматический запуск парсера в заданное время.Для запуска парсера по расписанию используется Планировщик заданий Windows

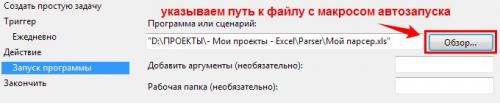

Порядок действий для настройки запуска парсера по расписанию:

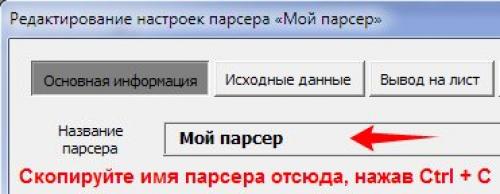

- настраиваем парсер (предположим, он называется Мой парсер )

- убеждаемся, что парсер запускается в «пустом» Excel (когда не открыт ни один файл)Для этого, закрываем Excel, открываем Excel снова, убеждаемся, что ни один файл в Excel не открыт.После этого, запускаем программу-парсер (если она автоматически не запустилась), и запускаем наш парсер, — парсер должен начать выводить данные (подразумевается, что при запуске парсера автоматически создаётся новая книга Excel, куда выводятся данные, или же в парсере настроено открытие существующего файла Excel с диска)

- скачиваем прикреплённый к статье файл В этом файле присутствует макрос для запуска парсераПосле скачивания, файл нужно разблокировать, для этого нужно:

- найти скачанный файл в папке (обычно это папка «Загрузки»)

- щелкнуть правой кнопкой мыши на файле — Свойства — Разблокировать (Unblock) — ОК

- переименовываем скачанный файл , назвав его в точности так, как называется парсер, который нужно запускать в нашем случае, файл будет называться Мой парсер.xls

Файл можно поместить в любую папку

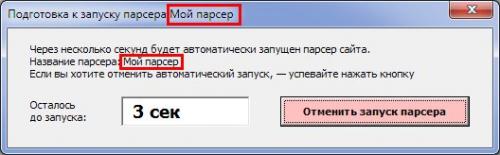

- пробуем запустить этот файл Excel Листы файла скрыты (как у надстройки .xla), а при запуске появляется окно с обратным отсчётом времени:

Внимание: никаких предупреждений Excel не должно появляться при запуске этого файла

Должно появляться только окно, показанное на скриншоте выше

Этот файл автоматически закрывает сам себя после запуска парсера или отмены запуска (красная кнопка) - Убеждаемся, что при ручном запуске этого файла Excel парсер стартует, и всё работает как надо. Дожидаться окончания работы парсера не обязательно.

Бесплатный парсер сайтов. Удаленные решения

Сюда отнесем облачные программы (SaaS-решения), главное преимущество таких решений в том, что они установлены на удаленном сервере и не используют ресурсы вашего компьютера. Вы подключаетесь к серверу через браузер (в этом случае возможна работа с любой ОС) или приложение и берете нужные вам данные.

Облачные сервисы, как и все готовые решения в этой статье, не гарантируют, что вы сможете парсить любой сайт. Вы можете столкнуться со сложной структурой, технологией сайта, которую “не понимает” сервис, защитой, которая окажется “не по зубам” или невозможностью интерпретировать данные (например, вывод текстовых данных не текстом, а картинками).

Плюсы:

- Не требуют установки на компьютер;

- Данные хранятся удаленно и не расходуют место, вы скачиваете только нужные результаты;

- Могут работать с большими объемами данных;

- Возможность работы по API и последующей автоматизации визуализации данных;

Минусы:

- Как правило, дороже десктоп решений;

- Требуют настройки и обслуживания;

- Невозможность парсить сайты со сложной защитой и/или интерпретировать данные.

Рассмотрим популярные сервисы и условия работы.

Octoparse – один из популярных облачных сервисов.

Особенности сервиса:

- Визуальный интерфейс для захвата данных;

- Не требующий знания программирования;

- Работает с динамическими элементами сайтов, такими как бесконечная прокрутка, окна авторизации, раскрывающиеся списки;

- Язык сервиса – английский;

Стоимость, в месяц:

- Бесплатный план позволяет собрать до 10 000 значений и запустить параллельно 2 потока;

- Платные тарифы $89 и $249 с разным лимитом на парсинг данных;

- Настраиваемый план для компаний с индивидуальными требованиями.

Scraper API – сервис, работающий через API, с подробной документацией.

Особенности сервиса:

- Автоматическое подставление прокси адресов и повторение неудачных запросов;

- Ввод капчи;

- Работает через API и требует знания кода;

- Язык сервиса – английский;

Пример GET запроса:

Стоимость, в месяц:

- Бесплатно – 1000 вызовов API (до 5 одновременных запросов);

- Начальный и средний платный план 29$ и 99$ без геотаргетинга прокси и без поддержки JavaScript;

- Бизнес план с поддержкой JavaScript и расширенными лимитами сбора данных;

- Кастомный план для компаний с индивидуальными требованиями.

ScrapingHub – функциональный облачный инструмент, включающий инструмент для ротации прокси серверов, headless браузер для парсинга (требующий написания кода) и инструмент для хранения данных.

Особенности сервиса:

- Сервис представляет набор инструментов, можно выбрать необходимые, в противовес удобству каждый инструмент нужно оплатить отдельно;

- Наличие API;

- Наличие

- Язык сервиса – английский.

Стоимость прокси, в месяц:

- Демо доступ с 10 000 запросами;

- $99 в месяц за 200 000 запросов и $349 за 2,5м запросов;

- Безлимитный сервис стартует от $999.

Стоимость облачного хранилища для данных, в месяц:

- Бесплатный тариф ограничивает хранение данных 7 днями и время сканированием 1 часом;

- Платный тариф $9.

Парсер сайтов в excel. Как парсить сайты при помощи экселя VBA

- |

- anatolyutkin

Это для себя заметка, тем, кто в курсе, ничего тут нового нет.

В трейдинге часто необходимо скачивать данные с различных сайтов. Порой для этого необходимо повторить много однотипных действий. Естественно, это удобно автоматизировать. Поскольку данные обычно--числа, то их удобно обрабатывать экселем (это если чисел не очень много. Много--это, например, тиковые данные чего-нибудь типа RI). Известно, что VBA в связке с экселем является очень удобным инструментом для работы с цифрами. Поэтому логично и парсить сайты тоже при помощи экселя.

Есть в экселе очень удобный объект InternetExplorer.Application Он позволяет вполне гибко программным образом управляться с сайтами путем программной работы с Internet Explorer. Можно гулять по сайтам, заполнять и отправлять формы, жать на кнопки, выкачивать любую инфу и вообще неплохо работать с DOMoм.

Какова технология?

1) Надо немного знать VBA (ниже есть примеры, вот в них надо приблизительно понимать что к чему).

Парсинг сайтов. «Юриста вызывали? Цитировать нельзя парсить»

Вне зависимости от того, чью сторону вы выбираете в вопросе определения источника силы: деньги или правда — ясно одно, что, там где начинают водиться деньги, найти правду становится всё сложнее. Вынося дискуссию о возможности приобретения за «ден.знаки» всего и вся, включая сам закон и его представителей, за рамки этой статьи, рассмотрим некоторые правовые аспекты, поднятые в комментариях:

- «От подглядывания до воровства — один шаг». Даже если разрешено всё, что не запрещено, то, считают наши читатели, «подглядывать в замочную скважину как минимум некрасиво, а если клиент потом ещё и выдаёт спарсенное за свое — то это уже прямое воровство. Конечно, понятно, что в бизнесе все так делают. Но в приличном обществе всё же принято об этом молчать.» Однако, парсить для кого-то и выдавать спарсенное за своё, как говорится, две большие разницы: «Вы путаете мягкое и холодное. Мы действительно оказываем услугу по парсингу. Но ровно так же можно обвинять производителей, например, оружия в том, что с его помощью убивают. Мы делаем бизнес, а в бизнесе есть одно правило — законно это или нет. Моя точка зрения… Если к нам приходят клиенты и готовы платить много, чтобы получить данные — это разве плохо…»

- «Сделал приложение для сайта СМИ — прибили за жалобу». Сайт Forbes, парсинг, приложение на Google Play — что могло пойти не так? «В свое время решил сделать приложение для сайта Forbes. Чтобы получать статьи с сайта — сделал парсинг страниц. Настроил всё в автоматическом режиме и сделал приложение для Андроид. Выложил приложение в маркет. Через год со мной связался юрист и потребовал удалить приложение, потому что я нарушаю авторские права. Спорить не стал. Обидно, что у самого Forbes нет приложения по их же статьям с сайта. Есть только сайт. А сайт у них тормозной, долго грузится и увешан рекламой…»

- «Моя база данных — мое произведение под защитой!». Авторское право — ещё одно понятие, которому можно посвятить с десяток страниц обсуждений (помимо сотен тысяч уже существующих), однако не упомянуть его никак тоже неправильно. Наш читатель выдал концепцию: «Некто создал базу товаров. Потратил кучу ресурсов на поиск информации, систематизацию этой информации, вынесение данных в базу. Вы по просьбе конкурента эту базу спарсиваете и за деньги отдаете тому самому конкуренту. Вы считаете, что здесь нет этических проблем? Касательно законности — не знаю, как в РФ, но в Украине БД может быть объектом авторского права.»

Однако, ответственность за пользование услугой или товаром всё ещё лежит на том, кто её/его приобретает и с какой целью использует: «… и в России тоже. Мы оказываем услугу по сбору данных. И за эту услугу просим деньги. Мы не продаем сами данные. Я, к слову, всех клиентов предупреждаю, что они могут нарушить закон если будут использовать, например, описания.» - «Формально вы правы, но статью на вас нашел!» В УК РФ (статья 146) описываются только масштабы нарушений, которые позволяют классифицировать нарушение авторских прав как «уголовку». Сами по себе права описаны в ГК — а на масштабы, позволяющие классифицировать деяние как «уголовку», регулярный парсинг, такой, что возникает вопрос «а не ляжет ли сайт», без проблем вытягиваются. Но важны аспекты:

- Там «крупный размер» — это не в количестве спарсенных страниц, а в деньгах. Как вы вообще оцените парсинг (и его регулярность), как нарушение авторских прав (!), в деньгах? А как обычно в таких случаях делают и откуда может штраф в сотни тысяч долларов за одну копию фильма взяться? Высчитывается «упущенная прибыль» с соответствующим коэффициентом. Можно с каких-нибудь договоров просчитать — сколько будет стоит купить у вас ту же информацию легально и отсюда «плясать». Но, для начала, вы должны её изначально продавать (а не выкладывать в публичный доступ), выдумывать цифру задним числом не «прокатит». Хотя и тут риски есть: знаете, сколько стоит коммерческая лицензия на условный Консультант-Плюс? Как только Вы полезете дальше десятка основных законов, вы быстро наткнетесь на предложение купить ту самую коммерческую версию.

- Наша история точно не из уголовного дела (и Вы не путайте штраф и ущерб. Вот вы по хулиганке разбили бутылку пива: ущерб — 30 рублей, штраф — до 1000р, а по гражданскому иску потом хоть триллион отсуживайте за «упущенную выгоду», но это уже не штраф). Вы же прайс не продаете вообще, что эксперт то сочинять будет? Конкретно, а не «хороший юрист натянет без проблем».

Парсинг сайтов Python. Учимся парсить веб-сайты на Python + BeautifulSoup

Интернет, пожалуй, самый большой источник информации (и дезинформации) на планете. Самостоятельно обработать множество ресурсов крайне сложно и затратно по времени, но есть способы автоматизации этого процесса. Речь идут о процессе скрейпинга страницы и последующего анализа данных. При помощи этих инструментов можно автоматизировать сбор огромного количества данных. А сообщество Python создало несколько мощных инструментов для этого. Интересно? Тогда погнали!

И да. Хотя многие сайты ничего против парсеров не имеют, но есть и те, кто не одобряет сбор данных с их сайта подобным образом. Стоит это учитывать, особенно если вы планируете какой-то крупный проект на базе собираемых данных.

С сегодня я предлагаю попробовать себя в этой интересной сфере при помощи классного инструмента под названием(Красивый суп?). Название начинает иметь смысл если вы хоть раз видели HTML кашу загруженной странички.

В этом примере мы попробуем стянуть данные сначала из специального сайта для обучения парсингу. А в следующий раз я покажу как я собираю некоторые блоки данных с сайта Minecraft Wiki, где структура сайта куда менее дружелюбная.

Этот гайд я написал под вдохновением и впечатлением от подобного на сайте, так что многие моменты и примеры совпадают, но содержимое и определённые части были изменены или написаны иначе, т.к. это не перевод. Оригинал:.

Этот сайт прост и понятен. Там есть список данных, которые нам и нужно будет вытащить из загруженной странички.

Понятное дело, что обработать так можно любой сайт. Буквально все из тех, которые вы можете открыть в своём браузере. Но для разных сайтов нужен будет свой скрипт, сложность которого будет напрямую зависеть от сложности самого сайта.

Главным инструментом в браузере для вас станет Инспектор страниц. В браузерах на базе хромиума его можно запустить вот так:

Он отображает полный код загруженной странички. Из него же мы будем извлекать интересующие нас данные. Если вы выделите блоки html кода, то при помощи подсветки легко сможете понять, что за что отвечает.

Ладно, на сайт посмотрели. Теперь перейдём в редактор.

Пишем код парсера для Fake Python

Для работы нам нужно будет несколько библиотек: requests и beautifulsoup4 . Их устанавливаем через терминал при помощи команд:

и

После чего пишем следующий код:

Тут мы импортируем новые библиотеки. URL это строка, она содержит ссылку на сайт. При помощи requests.get мы совершаем запрос к веб страничке. Сама функция возвращает ответ от сервера (200, 404 и т.д.), а page.content предоставляет нам полный код загруженной страницы. Тот же код, который мы видели в инспекторе.