Топ-7 AI-инструментов для веб-скрапинга в 2025 году

- Топ-7 AI-инструментов для веб-скрапинга в 2025 году

- Связанные вопросы и ответы

- Что такое AI-инструменты для веб-скрапинга

- Почему AI-инструменты для веб-скрапинга важны в 2025 году

- Какие лучшие решения для веб-скрапинга на основе AI в 2025

- Чем AI-инструменты отличаются от традиционных методов скрапинга

- Какие отрасли получат наибольшую выгоду от использования AI-инструментов для скрапинга

- Как выбрать подходящий AI-инструмент для скрапинга

- Какие основные проблемы при использовании AI-инструментов для скрапинга

- Как AI-инструменты для скрапинга обходят анти-скрапинг меры

Топ-7 AI-инструментов для веб-скрапинга в 2025 году

За последние несколько лет искусственный интеллект значительно упростил многие задачи, и веб-скраппинг – одна из них. В этом списке представлены лучшие инструменты искусственного интеллекта для веб-скреппинга, с помощью которых можно быстро и легко собрать полезные данные практически с любого публичного сайта.

1. Kadoa

Цена : Бесплатно с премиум-опциями

Как человек, потративший немало часов на создание собственных скреперов, я сразу же был впечатлен способностьюпонимать и извлекать данные из неструктурированных веб-сайтов с минимальными настройками. Уже одно это делает веб-скраппинг с искусственным интеллектом таким замечательным улучшением по сравнению с традиционным подходом.

Интуитивно понятный интерфейс позволил мне настраивать сложные задачи скрапинга, не написав ни строчки кода, что делает его отличным выбором как для новичков, так и для опытных разработчиков, которые хотят сэкономить время. Существует также расширение для, позволяющее выбирать данные простым щелчком мыши.

Во время тестирования я намеренно внес изменения в некоторые целевые веб-сайты, иKadoa автоматически обнаружил и адаптировался к этим изменениям. Одна только эта функция может сэкономить часы работы по обслуживанию, особенно для масштабных проектов по скраппингу.

2. Bardeen

Цена : Бесплатно с премиум-опциями

Bardeen занял свое место в этом списке лучших ИИ-инструментов для веб-скреппинга благодаря своей функции AI Browser Agents. Эта функция позволяет извлекать информацию с веб-сайтов с помощью команд на естественном языке, как это делал бы человек.

Связанные вопросы и ответы:

1. Как AI-движки для веб-скраппинга меняют отрасль в 2025 году

AI-движки для веб-скраппинга в 2025 году значительно меняют отрасль, повышая эффективность и скорость сбора данных. Благодаря искусственному интеллекту, эти инструменты могут обрабатыватьы данных, анализировать их и предоставлять более точные результаты. Это позволяет компаниям принимать более обоснованные решения, снижать затраты и улучшать качество аналитики. Кроме того, AI помогает обойти анти-скраппинговые меры, автоматизируя процесс и делая его менее уязвимым для блокировок. В целом, AI-инструменты для скраппинга открывают новые возможности для бизнеса, делая его более гибким и адаптивным к изменениям на рынке.

2. Какие AI-движки для веб-скраппинга являются самыми популярными в 2025 году

Среди самых популярных AI-движков для веб-скраппинга в 2025 году можно выделить несколько ключевых инструментов. Первый — это Octoparse, который известен своей простотой использования и мощными функциями для обработки данных. Второй — ParseHub, который отличается способностью работать с динамическими веб-страницами и предоставлять точные результаты. Третий — WebHarvy, который предлагает продвинутые возможности для настройки и интеграции с другими системами. Также стоит упомянуть Scrapy, который остается популярным благодаря своей гибкости и открытому исходному коду. Наконец, такие инструменты, как Beautiful Soup и Selenium, продолжают использоваться благодаря их универсальности и возможностям автоматизации.

3. Как AI-движки для веб-скраппинга обходят анти-скраппинговые технологии

AI-движки для веб-скраппинга в 2025 году используют продвинутые алгоритмы для обхода анти-скраппинговых технологий. Эти алгоритмы анализируют поведение веб-сайтов и адаптируются к изменениям в их структуре, что позволяет избежать блокировок. Кроме того, AI-инструменты могут имитировать поведение реальных пользователей, что делает их менее заметными для систем безопасности. Некоторые движки используют машинное обучение для прогнозирования и адаптации к новым анти-скраппинговым мерам, что делает их более эффективными. Также они могут распределять запросы через несколько прокси-серверов, чтобы избежать обнаружения. Таким образом, AI-движки становятся все более сложными для блокировки, что делает их популярными среди специалистов.

4. Какие отрасли получают наибольшую выгоду от AI-движков для веб-скраппинга

Наибольшую выгоду от AI-движков для веб-скраппинга получают такие отрасли, как электронная коммерция, маркетинг и аналитика. Электронные магазины используют эти инструменты для сбора данных о ценах и продуктах конкурентов, что позволяет им оставаться конкурентоспособными. Маркетологи собирают информацию о поведении пользователей и предпочтениях, чтобы создавать более целевые кампании. Аналитические компании используют скраппинг для сбора данных из открытых источников, что помогает им предоставлять более точные прогнозы и рекомендации. Также эти инструменты находят применение в финансовом секторе для анализа рыночных данных и принятия инвестиционных решений. Таким образом, AI-движки для скраппинга становятся незаменимыми инструментами для многих отраслей.

5. Как AI-движки для веб-скраппинга обеспечивают точность и качество данных

AI-движки для веб-скраппинга обеспечивают точность и качество данных благодаря использованию продвинутых алгоритмов и машинного обучения. Эти алгоритмы анализируют структуру веб-страниц и определяют наиболее релевантные данные, что снижает вероятность ошибок. Кроме того, AI-инструменты могут проверять данные на корректность и соответствие заданным критериям, что повышает их качество. Некоторые движки используют методы очистки данных, чтобы удалить дубликаты и ненужную информацию. Также они могут адаптироваться к изменениям в структуре веб-сайтов, что позволяет им поддерживать высокую точность сбора данных. Таким образом, AI-движки обеспечивают надежность и точность сбора данных, что делает их незаменимыми для бизнеса.

6. Какие этические и юридические аспекты следует учитывать при использовании AI-движков для веб-скраппинга

При использовании AI-движков для веб-скраппинга важно учитывать несколько этических и юридических аспектов. Во-первых, необходимо убедиться, что сбор данных осуществляется в соответствии с законами о защите данных, такими как GDPR или CCPA. Во-вторых, следует уважать условия использования веб-сайтов и не нарушать их политику. В-третьих, важно учитывать этические аспекты сбора данных, такие как защита конфиденциальной информации и прав пользователей. Также стоит быть осторожным с автоматизацией запросов, чтобы не перегружать серверы и не нарушать работу веб-сайтов. Наконец, важно прозрачно информировать пользователей о сборе их данных и получать их согласие, если это требуется законом. Таким образом, использование AI-движков для скраппинга требует ответственного подхода к юридическим и этическим вопросам.

7. Как AI-движки для веб-скраппинга интегрируются с другими технологиями, такими как машинное обучение

AI-движки для веб-скраппинга интегрируются с другими технологиями, такими как машинное обучение, для повышения их эффективности и функциональности. Например, данные, собранные с помощью скраппинга, могут использоваться для обучения моделей машинного обучения, что позволяет анализировать и прогнозировать тенденции. Это особенно полезно для таких задач, как анализ настроений, прогнозирование цен и выявление паттернов в данных. Кроме того, машинное обучение может использоваться для улучшения алгоритмов скраппинга, делая их более точными и адаптивными. Интеграция с другими технологиями, такими как обработка естественного языка или компьютерное зрение, позволяет решать более сложные задачи, такие как анализ визуальных данных или понимание контекста. Таким образом, сочетание AI-движков для скраппинга и машинного обучения открывает новые возможности для анализа и обработки данных.

Что такое AI-инструменты для веб-скрапинга

Что такое AI Веб-скрапинг и как он работает?

AI Веб-скрейпинг объединяет искусственный интеллект с автоматизированными инструментами извлечения данных для сбора информации с веб-сайтов. Он использует алгоритмы машинного обучения для адаптации к изменениям веб-сайта и извлечения соответствующих данных без ручного вмешательства.

AI Чем веб-скрапинг отличается от традиционного веб-скрапинга?

Скраперы на базе искусственного интеллекта могут собирать и классифицировать данные за считанные часы, на что вручную ушли бы недели, что обеспечивает значительную экономию времени и повышает точность извлечения данных.

Какие отрасли выигрывают от этого больше всего AI веб-скрапинг?

Электронная коммерция, финансы, путешествия и маркетинговые исследования получают значительную выгоду от AI веб-скрапинг для мониторинга цен, анализа рынка и сбора информации о клиентах.

Может AI Инструменты для парсинга веб-страниц обходят меры по борьбе со парсингом?

AI Алгоритмы могут решать CAPTCHA и имитировать поведение человека, чтобы обойти меры по борьбе с взломом.

AI Вносить изменения в структуру веб-сайта?

Скраперы на базе искусственного интеллекта могут адаптироваться к изменениям в макетах и структурах веб-сайтов, используя алгоритмы машинного обучения.

Какие инструменты доступны для AI Веб-скрапинг?

Популярное AI Инструменты для веб-скрапинга включают Octoparse, Import.io, ParseHub, Scraping Robot и PromptCloud.

Is AI Является ли веб-скрапинг экономически эффективным по сравнению с традиционными методами?

Хотя первоначальные затраты на установку могут быть выше, AI Веб-скрапинг обеспечивает долгосрочную экономию средств за счет автоматизации, сокращения ручного труда и более надежного сбора данных.

Почему AI-инструменты для веб-скрапинга важны в 2025 году

В этом руководстве вы узнаете, как создать веб-скрепер на основе искусственного интеллекта с помощью Crawl4AI. В качестве движка LLM мы будем использовать DeepSeek.

В частности, вы увидите, как создать AI-скребок для извлечения данных со страницы G2 для Bright Data :

Выполните следующие шаги и узнайте, как выполнять веб-скраппинг с помощью Crawl4AI и DeepSeek!

Пререквизиты

Чтобы следовать этому руководству, выполните следующие предварительные условия:

- На вашем компьютере установлен Python 3+

- Учетная запись GroqCloud

- Учетная запись Bright Data

Не волнуйтесь, если у вас еще нет учетной записи GroqCloud или Bright Data. Вы получите инструкции по их настройке во время следующих шагов.

Шаг №1: Настройка проекта

Выполните следующую команду, чтобы создать папку для вашего проекта скраппинга Crawl4AI DeepSeek:

mkdir crawl4ai-deepseek-scraper

Перейдите в папку проекта и создайте виртуальную среду :

cd crawl4ai-deepseek-scraper

python -m venv venv

Теперь загрузите папкуcrawl4ai-deepseek-scraperв вашу любимую Python IDE. Visual Studio Code с расширением Python или– два отличных варианта.

Внутри папки проекта создайте:

scraper.py: Файл, в котором будет содержаться логика скрапинга, основанная на искусственном интеллекте. models/: Каталог для хранения моделей данных Crawl4AI LLM на основе Pydantic. .env: Файл для безопасного хранения переменных окружения.После создания этих файлов и папок структура вашего проекта должна выглядеть следующим образом:

Затем активируйте виртуальную среду в терминале вашей IDE.

В Linux или macOS запустите эту команду:

./env/bin/activate

Аналогично, в Windows выполните команду:

env/Scripts/activate

Отлично! Теперь у вас есть среда Python для веб-скрапинга Crawl4AI с помощью DeepSeek.

Шаг №2: Установите Craw4AI

Активировав виртуальную среду, установите Crawl4AI с помощью пакета crawl4ai pip:

pip install crawl4ai

Обратите внимание, что библиотека имеет несколько зависимостей, поэтому установка может занять некоторое время.

Какие лучшие решения для веб-скрапинга на основе AI в 2025

За последние несколько лет искусственный интеллект значительно упростил многие задачи, и веб-скраппинг – одна из них. В этом списке представлены лучшие инструменты искусственного интеллекта для веб-скреппинга, с помощью которых можно быстро и легко собрать полезные данные практически с любого публичного сайта.

1. Kadoa

Цена : Бесплатно с премиум-опциями

Как человек, потративший немало часов на создание собственных скреперов, я сразу же был впечатлен способностьюпонимать и извлекать данные из неструктурированных веб-сайтов с минимальными настройками. Уже одно это делает веб-скраппинг с искусственным интеллектом таким замечательным улучшением по сравнению с традиционным подходом.

Интуитивно понятный интерфейс позволил мне настраивать сложные задачи скрапинга, не написав ни строчки кода, что делает его отличным выбором как для новичков, так и для опытных разработчиков, которые хотят сэкономить время. Существует также расширение для, позволяющее выбирать данные простым щелчком мыши.

Во время тестирования я намеренно внес изменения в некоторые целевые веб-сайты, иKadoa автоматически обнаружил и адаптировался к этим изменениям. Одна только эта функция может сэкономить часы работы по обслуживанию, особенно для масштабных проектов по скраппингу.

2. Bardeen

Цена : Бесплатно с премиум-опциями

Bardeen занял свое место в этом списке лучших ИИ-инструментов для веб-скреппинга благодаря своей функции AI Browser Agents. Эта функция позволяет извлекать информацию с веб-сайтов с помощью команд на естественном языке, как это делал бы человек.

Чем AI-инструменты отличаются от традиционных методов скрапинга

У вебмастера, маркетолога, SEO-специалиста, специалиста по ценообразованию регулярно возникает потребность в извлечении данных со страниц сайтов в удобном для дальнейшей обработки виде. В этой статье мы разберемся, какая технология применяется для сбора данных, что это за процесс, и почему у него несколько названий.

Чаще всего в русскоязычном пространстве сбор данных со страниц веб-ресурсов принято называть парсингом ( parsing ). В англоязычном пространстве этот процесс принято называть скрейпингом (s craping).

Давайте разбираться, что это за процессы, и есть ли разница между ними.

Изначально приложение, выполняющее две операции: выкачивания нужной информации с сайта и анализа контента сайта, называлось парсингом.

В переводе с английского «parsing» — это проведение грамматического разбора слова или текста. Это производное слово от латинского «pars orationis» — часть речи.

Парсинг — это метод, при котором информация анализируется и разбивается на компоненты. Затем полученные данные преобразуются в пригодный формат для дальнейшей обработки, в процессе чего один формат данных превращается в другой, более читаемый.

Допустим, данные извлекаются в необработанном коде HTML, а парсер принимает его и преобразует в формат, который можно легко проанализировать и понять.

Парсинг использует инструментарий, который извлекает нужные значения из любых форматов данных. Извлеченные данные сохраняются в отдельном файле на компьютере/в облаке или напрямую в базе данных. Это процесс, который запускается автоматически.

Дальнейший анализ собранной информации осуществляет специальное программное обеспечение.

Что значит парсить ?

Парсер — программное решение, а парсинг — процесс. Типичный процесс парсинга сайтов состоит из следующих последовательных шагов:

‣ Идентификация целевых URL-адресов.

‣ Если веб-сайт, сканируемый для сбора данных, использует инструменты противодействия парсингу, то парсер, подбирает подходящий прокси-сервер, чтобы получить новый IP-адрес, через который отправляет свой запрос. Если необходимо, задействуется сервис разгадывания капчи.

‣ Отправка GET/POST запросов на эти URL-адреса.

‣ Поиск и обнаружение местонахождения необходимых данных в HTML-коде.

‣ Преобразование этих данных в нужный формат.

‣ Передача собранной информации в выбранное хранилище данных.

‣ Экспорт данных в нужном формате для дальнейшей работы с ними.

Со временем процесс выкачивания нужной информации с сайта и анализа контента сайта стали разделять на две самостоятельные операции. Был придуман термин краулер . Краулер занимается обходом сайта и сбором данных, а парсер анализом содержимого.

Позднее придумали термин скрейпинг. Веб-скрейпинг объединяет в себе функции краулера и парсера.

Вот какое определение веб-скрейпинга дает Википедия:

Веб-скрейпинг (или скрепинг, или скрапинг← англ. web scraping ) — это технология получения веб-данных путем извлечения их со страниц веб-ресурсов. Веб-скрейпинг может быть сделан вручную пользователем компьютера, однако термин обычно относится к автоматизированным процессам, реализованным с помощью кода, который выполняет GET-запросы на целевой сайт.

Веб-скрейпинг используется для синтаксического преобразования веб-страниц в более удобные для работы формы. Веб-страницы создаются с использованием текстовых языков разметки ( HTML и XHTML ) и содержат множество полезных данных в коде. Однако большинство веб-ресурсов предназначено для конечных пользователей, а не для удобства автоматического использования, поэтому была разработана технология, которая «очищает» веб-контент.

Но у русскоязычной аудитории термин скрейпинг/скрапинг не прижился. У нас гораздо чаще для обозначения всего процесса сбора и анализа информации используют слово парсер.

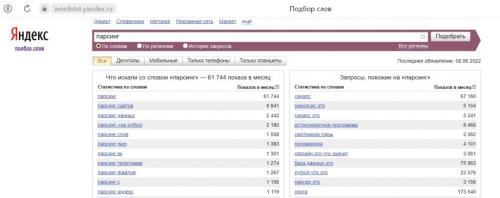

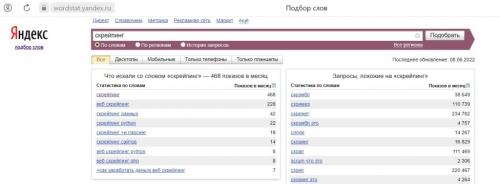

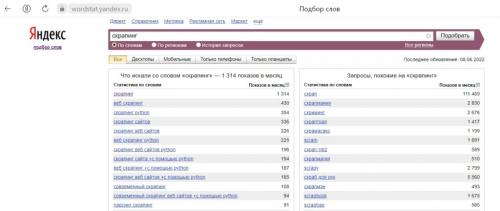

И это наглядно доказывает Яндекс Wordstat. Так по слову “парсинг” ежемесячно создается в среднем 62 тысячи запросов.

В то время как слово “скрапинг” ищут около 1300 раз в месяц, а “скрейпинг” менее 500 раз.

Задачи веб-скрейпинга/парсинга

Основная задача скрейпинга, это быстрое получение нужных данных из интернета с помощью специальных программ/ботов.

Большинство веб-ресурсов предназначено для конечных пользователей, а не для удобства автоматического использования, поэтому была разработана технология, которая «очищает» веб-контент и производит синтаксическое преобразование веб-страниц для последующего извлечения и анализа.

В основном веб-скрейперы решают следующие задачи:

• поиск необходимой информации;

• копирование данных из интернета;

• мониторинг обновлений на сайтах.

К категории данных, которые можно парсить, относятся:

• изображения;

•

• текстовый контент.

То есть любые открытые данные — каталоги товаров, адреса электронной почты, телефоны и другая информация.

Веб-скрейпинг может быть как самостоятельным инструментом и служить для целевого поиска информации, так и может стать компонентом веб-разработки для веб-индексации, веб-майнинга и интеллектуального анализа данных, онлайн-мониторинга изменения цен и их сравнения, для наблюдения за конкуренцией, и другого сбора данных.

Какие отрасли получат наибольшую выгоду от использования AI-инструментов для скрапинга

Большинство сервисов для скрапинга данных – это платное решение для сложных задач, но есть и условно-бесплатные, которые подойдут для простых проектов. В этом разделе мы рассмотрим и те, и другие варианты.

ScraperAPI

ScraperAPI позволяет получить HTML-содержимое с любой страницы через API. С его помощью можно работать с браузерами и прокси-серверами, обходя проверочный код CAPTCHA .

Его легко интегрировать – нужно только отправить GET-запрос к API с API-ключом и URL. Кроме того, ScraperAPI практически невозможно заблокировать, так как при каждом запросе он меняет IP-адреса, автоматически повторяет неудачные попытки и решает капчу.

Особенности:

- рендеринг JS;

- геотеги;

- пул мобильных прокси для скрапинга цен, результатов поиска, мониторинга соцсетей и прочего.

Стоимость: есть пробная версия, платные тарифы начинаются от $29 в месяц

Официальная страница: ScraperAPI

ScrapingBee

ScrapingBee использует API для скрапинга веб-страниц, который обрабатывает headless-браузеры и управляет прокси-серверами, обходя все типы блокировки. У сервиса также есть специальный API для парсинга поиска Google.

Особенности:

- рендеринг JS;

- ротация прокси;

- отлично взаимодействует с Google Sheets и Google Chrome.

Стоимость: от $49 в месяц

Официальная страница: ScrapingBee

ScrapingBot

ScrapingBot – это мощный API для извлечения HTML-содержимого. Компания предлагает API-интерфейсы для сбора данных в области розничной торговли и недвижимости, включая описание продукта, цену, валюту, отзывы, цену покупки или аренды, площадь, местоположение. Вполне доступные тарифные планы, JS-рендеринг, парсинг с веб-сайтов на Angular JS, Ajax, JS, React JS, а также возможность геотаргетинга делают этот продукт незаменимым помощником для сбора данных.

Особенности:

- рендеринг JS;

- качественный прокси;

- до 20 одновременных запросов;

- геотеги;

- есть расширение Prestashop, которое синхронизируется с сайтом для мониторинга цен конкурентов.

Стоимость: бесплатно или от €39 в месяц

Официальная страница: ScrapingBot

Scrapestack

Scrapestack – это REST API для скрапинга веб-сайтов в режиме реального времени. С его помощью можно молниеносно собирать данные с сайтов, используя миллионы прокси и обходя капчу.

Особенности:

- одновременные API запросы;

- рендеринг JS;

- шифрование HTTPS.

Стоимость: бесплатно или от $19.99 в месяц

Официальная страница: Scrapestack

ParseHub

ParseHub – это облачный онлайн-парсер, который является универсальным сборщиком любых данных и не требует специальных знаний. С помощью таких функций, как drag-and-drop, пользователи могут формировать элементы скрапинга. Это один из лучших инструментов для сбора данных, позволяющий загружать полученные данные в любом формате для последующего анализа.

Как выбрать подходящий AI-инструмент для скрапинга

Веб-скрапинг с использованием ИИ имеет ряд существенных преимуществ – о главных из них мы расскажем далее.

1. Эффективность и скорость

скраперы на базе ИИ обрабатывают большие объемы данных намного быстрее, чем люди. Они могут собирать информацию с нескольких страниц одновременно с высокой скоростью и без ошибок. Такая скорость – важнейшее преимущество для компаний, которым требуются данные в режиме реального времени.

2. Адаптивное обучение

ИИ-скраперы отличаются от традиционных тем, что им не нужны частые обновления, чтобы адаптироваться к изменениям в макетах веб-сайтов или типах контента. Вместо этого они сами учатся на прошлом опыте. Эта особенность позволяет им автоматически адаптироваться к новым структурам и форматам и уменьшает необходимость в постоянном обслуживании.

3. Сбор данных в режиме реального времени

Веб-скраперы на базе ИИ могут непрерывно собирать данные и, тем самым, предоставлять самую актуальную информацию. Эта функция особенно актуальна в таких отраслях, как e-commerce или финансы, где рыночные условия быстро меняются.

4. Качество и точность данных

Скраперы, управляемые ИИ, значительно повышают качество и точность собранных данных. Отфильтровывая ненужную информацию, ИИ снижает уровень информационного “шума” и позволяет получать только корректные и релевантные данные. Эта точность уменьшает вероятность ошибки на всех этапах сбора данных – от их извлечения до анализа.

Какие основные проблемы при использовании AI-инструментов для скрапинга

Скрапинг — это способ автоматизировать сбор информации. Например, вы составили X-ray-запрос и получили выдачу в гугле на 40 страниц. Что делать дальше? Можно вручную заходить на каждую страницу, выбирать и сохранять подходящие профили. На это уйдет вечность.

А можно воспользоваться скрапером — специальной программой, которая за минуту сама пробежится по страницам и сохранит все профили в таблице, разложив данные о кандидатах по ячейкам.

Основная задача скрапинга — ускорение сорсинга. Но скрапинг используется и в других случаях, когда нужно вытащить и структурировать информацию с какого-то ресурса.

Скрапинг нужен не всегда, это инструмент для продвинутого сорсинга. Вот когда он пригодится:

- Для работы с большой поисковой выдачей. Например, при поиске кандидатов по популярному стеку технологий среди всех людей, которые есть в выбранной стране. А если вы составили запрос и получили всего 10 профилей, то скрапить здесь нечего.

- Чтобы оценить рынок и сформировать лонглист. Для рекрутера, особенно внешнего, важно, чтобы заказчик осознавал объем рынка. Можно рассказать ему на словах, сколько всего есть кандидатов. Но лучше показать полный список людей, которым можно предложить вакансию: так убедительнее.

- Чтобы освободить время. Скрапинг экономит часы работы на сбор и систематизацию информации, составление таблиц, отчетов и пайплайнов. Освободившееся время можно потратить на персонализацию общения и копирайтинг. Ведь наша задача — не только найти кандидата, но и сделать все, чтобы заинтересовать его.

Как AI-инструменты для скрапинга обходят анти-скрапинг меры

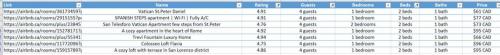

«Бот» — это всего лишь технический термин, обозначающий программу, которая способна что-то делать. Такую программу можно создать и продать тому, кому нужно автоматизировать то, что умеет программа.Для того чтобы продемонстрировать вам технологию разработки и продажи ботов, я создал бота для Airbnb. Этот бот позволяет пользователям вводить данные о некоем городе и возвращает сведения обо всех жилищах, которые в этом городе предлагает. Сюда входят данные о цене, рейтинге, о количестве постояльцев, которое может принять дом, о количестве спален, кроватей, ванных комнат. И всё это делается благодаря применению технологий веб-скрапинга при сборе данных из постов, размещаемых на сайте Airbnb.Для того чтобы показать этого бота в действии, я собираюсь узнать с его помощью о том, что можно снять в Риме, в Италии. Я передаю боту соответствующие данные, а он, за секунды, находит 272 уникальных предложения и оформляет их в виде удобного Excel-листа.Теперь с такими данными работать гораздо легче, чем на сайте. Можно, например, сравнить разные жилища и их особенности. Кроме того, эти данные удобно фильтровать. В моей семье 4 человека. Если мы соберёмся в Рим, то нам понадобится Airbnb-жильё с как минимум 2 кроватями, отличающееся адекватной ценой. Благодаря тому, что все данные собраны в удобном формате, в Excel, с ними можно весьма продуктивно работать. Как оказалось, моим нуждам удовлетворяют 7 результатов из 272.