Top 8 No-Code Web Scraper Tools: A Comprehensive Review

- Top 8 No-Code Web Scraper Tools: A Comprehensive Review

- Связанные вопросы и ответы

- Что такое No-Code web scraper tools

- Какие преимущества имеют No-Code web scraper tools перед традиционными инструментами веб-скрапинга

- Какие платформы No-Code web scraper tools можно найти на рынке

- Какие задачи можно решать с помощью No-Code web scraper tools

- Какие платформы No-Code web scraper tools можно использовать для сбора данных с динамических веб-сайтов

- Какие платформы No-Code web scraper tools имеют наибольшую функциональность

- Какие платформы No-Code web scraper tools имеют наибольшую удобную и интуитивную пользовательскую среду

- Какие платформы No-Code web scraper tools имеют наибольшую стоимость

Top 8 No-Code Web Scraper Tools: A Comprehensive Review

Введение

Веб-скрейпинг – это процесс автоматического извлечения данных из веб-сайтов. Он используется для сбора информации из интернета и может быть очень полезен для многих целей, таких как маркетинговые исследования, аналитика данных и мониторинг конкурентов. Но если вы не программист, то создание собственного скрипта для веб-скрейпинга может быть сложным и затратным. В этой статье мы рассмотрим 8 инструментов для веб-скрейпинга без кода, которые помогут вам извлекать данные из веб-сайтов без необходимости писать код.

Список инструментов для веб-скрейпинга без кода

1. ParseHub

2. Octoparse

3. WebHarvy

4. Mozenda

5. Import.io

6. Outwit Hub

7. Diffbot

8. Apify

ParseHub

ParseHub – это мощный инструмент для веб-скрейпинга без кода, который позволяет извлекать данные из веб-сайтов с помощью навигации по сайту и выбора элементов на странице. Он поддерживает многоуровневые навигацию и может извлекать данные из динамических веб-сайтов. ParseHub также имеет встроенный модуль для обработки данных, который позволяет фильтровать и преобразовывать данные перед их сохранением.

Octoparse

Octoparse – это еще один инструмент для веб-скрейпинга без кода, который позволяет извлекать данные из веб-сайтов с помощью навигации по сайту и выбора элементов на странице. Он поддерживает многоуровневый веб-скрейпинг и может извлекать данные из динамических веб-сайтов. Octoparse также имеет встроенный модуль для обработки данных, который позволяет фильтровать и преобразовывать данные перед их сохранением.

WebHarvy

WebHarvy – это инструмент для веб-скрейпинга без кода, который позволяет извлекать данные из веб-сайтов с помощью выбора элементов на странице. Он поддерживает многоуровневый веб-скрейпинг и может извлекать данные из динамических веб-сайтов. WebHarvy также имеет встроенный модуль для обработки данных, который позволяет фильтровать и преобразовывать данные перед их сохранением.

Mozenda

Mozenda – это инструмент для веб-скрейпинга без кода, который позволяет извлекать данные из веб-сайтов с помощью навигации по сайту и выбора элементов на странице. Он поддерживает многоуровневый веб-скрейпинг и может извлекать данные из динамических веб-сайтов. Mozenda также имеет встроенный модуль для обработки данных, который позволяет фильтровать и преобразовывать данные перед их сохранением.

Import.io

Import.io – это инструмент для веб-скрейпинга без кода, который позволяет извлекать данные из веб-сайтов с помощью навигации по сайту и выбора элементов на странице. Он поддерживает многоуровневый веб-скрейпинг и может извлекать данные из динамических веб-сайтов. Import.io также имеет встроенный модуль для обработки данных, который позволяет фильтровать и преобразовывать данные перед их сохранением.

Outwit Hub

Outwit Hub – это инструмент для веб-скрейпинга без кода, который позволяет извлекать данные из веб-сайтов с помощью навигации по сайту и выбора элементов на странице. Он поддерживает многоуровневый веб-скрейпинг и может извлекать данные из динамических веб-сайтов. Outwit Hub также имеет встроенный модуль для обработки данных, который позволяет фильтровать и преобразовывать данные перед их сохранением.

Diffbot

Diffbot – это инструмент для веб-скрейпинга без кода, который позволяет извлекать данные из веб-сайтов с помощью навигации по сайту и выбора элементов на странице. Он поддерживает многоуровневый веб-скрейпинг и может извлекать данные из динамических веб-сайтов. Diffbot также имеет встроенный модуль для обработки данных, который позволяет фильтровать и преобразовывать данные перед их сохранением.

Apify

Apify – это инструмент для веб-скрейпинга без кода, который позволяет извлекать данные из веб-сайтов с помощью навигации по сайту и выбора элементов на странице. Он поддерживает многоуровневый веб-скрейпинг и может извлекать данные из динамических веб-сайтов. Apify также имеет встроенный модуль для обработки данных, который позволяет фильтровать и преобразовывать данные перед их сохранением.

Заключение

Веб-скрейпинг без кода – это мощный инструмент, который может помочь вам извлекать данные из веб-сайтов без необходимости писать код. В этой статье мы рассмотрели 8 инструментов для веб-скрейпинга без кода, которые могут быть полезны для ваших целей. Используйте их для извлечения данных из веб-сайтов и получения доступа к информации, которую вы не можете получить в других местах.

Связанные вопросы и ответы:

1. Что такое No-Code web Scraper Tools

No-Code web Scraper Tools - это программные решения, которые позволяют пользователям собирать данные с веб-сайтов без необходимости писать код. Эти инструменты облегчают процесс веб-сканирования, позволяя пользователям создавать и запускать скрипты для извлечения данных из веб-страниц с помощью графического интерфейса.

2. Какие преимущества использования No-Code web Scraper Tools

Использование No-Code web Scraper Tools имеет несколько преимуществ. Во-первых, они позволяют людям без технических навыков собирать данные с веб-сайтов, что делает процесс доступным для широкой аудитории. Во-вторых, эти инструменты облегчают процесс веб-сканирования, ускоряя сбор данных и уменьшая вероятность ошибок. В-третьих, No-Code web Scraper Tools обычно имеют встроенные функции обработки данных, что позволяет пользователям анализировать и представлять данные в более удобном виде.

3. Какие платформы можно использовать для создания No-Code web Scraper Tools

Существует несколько платформ, которые можно использовать для создания No-Code web Scraper Tools. Некоторые из наиболее популярных платформ включают ParseHub, Octoparse, WebHarvy, Import.io и Scrapy.

4. Какие функции должна иметь No-Code web Scraper Tools

No-Code web Scraper Tools должны иметь ряд функций, чтобы быть полезными для пользователей. К ним относятся возможность извлечения данных из различных типов веб-страниц, поддержка различных форматов данных, возможность обработки больших объемов данных, возможность автоматического обновления данных и возможность интеграции с другими инструментами и сервисами.

5. Как использовать No-Code web Scraper Tools

Использование No-Code web Scraper Tools обычно состоит из нескольких этапов. Во-первых, пользователь должен выбрать платформу и создать аккаунт. Во-вторых, он должен выбрать веб-страницу, с которой нужно извлечь данные, и настроить инструмент для извлечения нужных данных. В-третьих, он должен запустить инструмент и дождаться, пока он извлечет данные. В-четвертых, он должен обработать данные, если это необходимо, и сохранить их в нужном формате.

6. Какие ограничения могут быть при использовании No-Code web Scraper Tools

Использование No-Code web Scraper Tools может быть ограничено несколькими факторами. Во-первых, некоторые веб-сайты могут блокировать скрипты, что может затруднить процесс извлечения данных. Во-вторых, некоторые инструменты могут быть ограничены в скорости извлечения данных, что может замедлить процесс. В-третьих, некоторые инструменты могут быть ограничены в функциональности, что может ограничить возможности пользователя.

7. Как избежать проблем с законом при использовании No-Code web Scraper Tools

Чтобы избежать проблем с законом при использовании No-Code web Scraper Tools, следует соблюдать несколько правил. Во-первых, пользователь должен убедиться, что он имеет право на извлечение данных с определенного веб-сайта. Во-вторых, он должен убедиться, что он не нарушает правила веб-сайта, касающиеся веб-сканирования. В-третьих, он должен убедиться, что он не использует данные для незаконных целей.

8. Какие альтернативы No-Code web Scraper Tools существуют

Если No-Code web Scraper Tools не подходят для определенной задачи, существует несколько альтернатив. Одна из них - использование программного кода для извлечения данных с веб-сайтов. Еще одна альтернатива - использование профессиональных услуг веб-сканирования, которые могут быть более сложными, но более эффективными.

Что такое No-Code web scraper tools

No-Code Scraper – это революционный инструмент, разработанный для упрощения процесса веб-скрапинга, делая его доступным для всех, независимо от их навыков программирования. Эта инновационная платформа использует большие языковые модели для извлечения данных с любого веб-сайта без усилий. Благодаря удобному интерфейсу и мощным функциям, No-Code Scraper обеспечивает простой и удобный процесс извлечения данных, адаптируясь к изменениям на веб-сайте и предоставляя гибкие варианты экспорта данных.

Ключевые функции:

Бесшовное извлечение данных: Извлекайте данные с любого веб-сайта, указав только URL и спецификацию полей.

Программирование не требуется: Погружайтесь в веб-скрапинг без опыта программирования.

️ Непревзойденная устойчивость: Мощный скрапер адаптируется к изменениям в HTML, обеспечивая непрерывную работу.

Универсальная совместимость: Работает без проблем с любым новым веб-сайтом, исключая необходимость постоянных настроек.

Простой экспорт данных: Экспортируйте данные в предпочитаемом формате: CSV, JSON или Excel.

Сферы применения:

Маркетинговые исследования: Извлекайте информацию о продуктах, цены и отзывы с сайтов электронной коммерции.

Агрегация контента: Собирайте новости или посты из блога из различных источников для персонализированной ленты.

Анализ конкурентов: Отслеживайте цены и предложения конкурентов с помощью автоматизированных обновлений данных.

Как это работает?

No-Code Scraper использует передовые большие языковые модели для интерпретации и извлечения данных с веб-страниц. Он перемещается по структуре HTML веб-сайта, идентифицирует указанные поля данных и извлекает информацию в структурированном формате. Адаптивная природа инструмента гарантирует его эффективность даже при изменениях на веб-сайтах.

Какие преимущества имеют No-Code web scraper tools перед традиционными инструментами веб-скрапинга

Это инструмент для создания различных IT-продуктов (приложений, сайтов, баз данных и так далее) без использования ручного программирования. Такие сервисы работают по принципу drag-and-drop и позволяют собирать полноценные сайты с помощью комбинирования готовых блоков или графических элементов.

Преимущества использования no-code платформ:

Небольшие расходы. No-code сервисы помогают бизнесу получить быстрый результат при минимальных затратах бюджета и рабочей силы. К примеру, если эксперту понадобится запустить онлайн-курс, ему хватит одного лендинга с формой для заявок, на который пойдёт трафик.

Экономия времени. С no-code подходом можно собирать красивые и функциональные сайты, комбинируя уже заготовленные компоненты страницы. При этом практически каждая no-code платформа содержит готовые шаблоны под конкретный формат или бизнес.

Низкий порог входа. Для работы с no-code сервисом не нужны знания кода — достаточно понимать, каким вы хотите видеть ваш сайт и базовые этапы сайтостроения. К тому же многие платформы имеют собственные обучающие программы.

Вместе с этим no-code метод имеет свои недостатки:

Ограниченная функциональность. Прежде чем использовать конкретный сервис, важно понимать, в каком направлении будет масштабироваться ваш бизнес. Например, если вы сделали PWA-приложение, но со временем хотите создать нативное — нужно выбирать платформу, которая сможет реализовать оба этих варианта.

Низкая кастомизация. No-code решения ограничены имеющимися модулями и шаблонами, что заметно снижает творческий потенциал проекта. Если вы не готовы менять изначально задуманный дизайн — возможно, лучшим решением будет традиционная разработка.

Проблемы с безопасностью. Используя no-code, у вас не будет полного контроля над сайтом. Помимо риска серверных сбоёв или кибератак конструктор просто может прекратить свою деятельность и лишить вас всех имеющихся данных.

Какие платформы No-Code web scraper tools можно найти на рынке

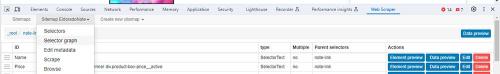

РАСШИРЕНИЕ CHROME И FIREFOX — WEB SCRAPER

Набрел на отличное расширение для браузеров Chrome и Firefox — Web Scraper. Без всякого знания кода можно отлично парсить сайты. И инфо и магазины. Указал что нужно и вперед. Расширение бесплатное (Нет, можно и заплатить конечно, но цены от 50 вечно зеленых в месяц.). Очень удобное. Принцип его работы – «наведи и кликни». Вывод данных в форматы .csv и .xlsx.

Сайт Web Scraper с документацией на английском

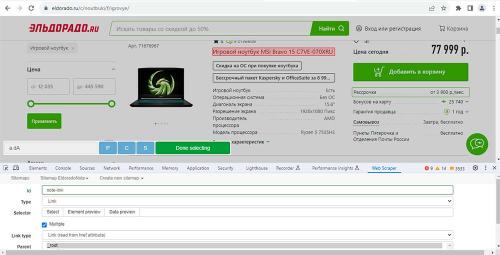

НАСТРОЙКА WEB SCRAPER

При установке Web Scraper интегрируется в браузере с «Инструментами разработчика» ( Windows — Ctrl+Shift+I, Linux — F12, Mac — Cmd+Opt+I).

Sitemap name — название вашего проекта (только буквы, без пробелов и спецсимволов).

Start URL 1 — адрес страницы с которой начинает парсить Scraper. Можно добавить несколько страниц (например нужные разделы (подразделы) каталога интернет магазина), просто в конце строки нажать + и откроется еще одна строка и т.д.

Далее нажать кнопку « Create Sitemap «.

Итак карта сайта готова, переходим к селекторам по которым и будем парсить. Открываем нужный сайт, нужный раздел (я открыл на сайте Эльдорадо раздел игровых ноутбуков). В карте сайта жмем кнопку « Add new selector » и в Type (типе поля) выбираем Link . Данный селектор используется для выбора ссылок и навигации по сайту. В поле id пишем название селектора (оно потом будет названием столбца в экселе или сиэсви). Так как парсим мы не один товар, то ставим галочку в чекбокс « Multiple «. Теперь нам нужно указать парсеру сами товары. В поле Selector выбираем Select , подводим мышку к названию товара (чтобы оно выделилось) и кликаем ей. Название товара выделяется красным. Далее подводим мышку к названию следующего товара, зажимаем Shift, и кликаем по названию этого товара. Название опять должно выделиться красным. Смотрим на страницу — выделились все названия или нет. Если не выделились то подводим мышку к следующему товару, зажимаем Shift, и опять кликаем по названию. Как только названия всех товаров выделились нажимаем зеленую кнопку « Done selecting «.

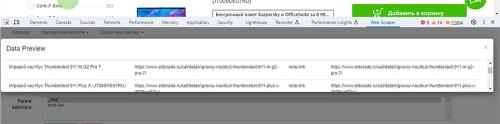

Теперь в поле Selector нажмите « Data preview «. Если открылось окошко в котором есть список ссылок — вы все делаете правильно. Жмем кнопку « Save selector «.

Так как парсить мы будем товар, то и на сайте нам нужно погрузиться в товар, то есть опуститься на уровень ниже. Кликаем по id link и переходим внутрь селектора.

Тут немного отвлечемся на типы полей:

Type Text — тип поля Текст извлечет простой текст из выбранного элемента и из всех его дочерних элементов. Все HTML теги будут удалены, и будет возвращен только текст (так называемый Plain Text). Теги

(в HTML перенос строки) будут заменены символами новой строки.

Type Table — табличный тип данных, например для характеристик товара. Настройки этого селектора включают три настраиваемые селектора. Selector ( тег table) — открывающий тег таблицы. Header row selector ее обертка (тег thead) — предназначен для группировки содержимого верхнего колонтитула (так сказать ряд заголовков для столбцов), а Data rows selector (тег tr) — это строка таблицы. В поле Selector нажимаете Select и указываете мышкой таблицу. Все три поля должны заполниться. Если заполнилось неправильно, нажмите « Data preview » и посмотрите. Далее нажав нужный Select можно подправить какие данные должен захватывать селектор.

Type Image — селектор изображений извлекает URL из атрибута src картинок. Если нужно выбрать все картинки с одинаковым селектором, то нажмите чекбокс multiple . Выберите главное изображение товара кнопкой « Select «, а с помощью кнопки « Data preview » убедитесь, что вы получаете ссылку на нужное изображение.

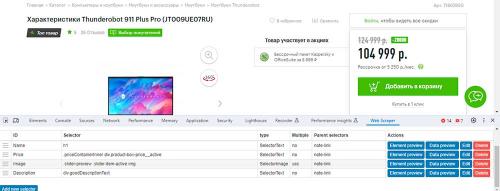

Например нам нужно название товара, его цена, описание и изображения. Жмем « Add new selector » и добавляем нужные селекторы выделяя мышкой нужные элементы товара. У меня получилось вот так:

Перед парсингом карту можно проверить в окне « Selector graph «

Чтобы начать парсинг нажмите « Scrape «

После нажатия Scrape вам парсер покажет вам вот тако окно:

Request intervals (ms) — это промежуток между запросами в миллисекундах. 2000 миллисекунд = 2 секунды. Этот промежуток нужен для того чтобы не перегружать сервер запросами и чтобы вас не забанили (например по ip).

Page load delay (ms) — это время отведенное для загрузки страницы (страницы бывают тяжелые и они долго загружаются, или сервер переполнен запросами и также не может быстро обслужить ваш запрос). Выставляем нужные значения (пока можно оставить и эти, а далее разберетесь), и жмем « Start scraping «. Появится еще одно окно в котором начнут загружаться товары.

После того как парсер окончит работу нажмите « Refresh Data » и убедитесь в правильности данных.

Если вас все устраивает выберите « Export Data »

и формат вывода данных (.csv или .xlsx).

И плюс

Всем успехов!

Какие задачи можно решать с помощью No-Code web scraper tools

В ходе моего анализапоследовательно демонстрировал свою эффективность, поскольку Платформа №1 для очистки веб-данных . Сбор общедоступных веб-данных в большом масштабе был простым, а возможности структурирования данных платформы были превосходными.

Bright DataРешения компании помогают компаниям, академическим учреждениям и малым предприятиям из списка Fortune 500 получать общедоступные веб-данные наиболее эффективным, надежным и гибким способом. Имея предоставленные данные, они теперь могут отслеживать и анализировать их для принятия более эффективных решений.

Bright Data это надежный инструмент, который легко интегрируется с различными платформами, такими как AdsPower, PhantomBuster и Selenium. Я столкнулся с его мощными функциями, такими как ротация IP и CA.PTCРешение ХА. Bright Data также поддерживает множество языков программирования, таких как Python, Javaи Руби.

№1 Лучший выбор

Преимущества:

- Доступность: Облачное решение доступно через Bright Dataвеб-сайт, гарантирующий простоту использования и удобство в любое время.

- Надежность: Он предоставил мне данные высочайшего качества, лучшее время безотказной работы, более быструю обработку и превосходную поддержку при необходимости.

- Гибкость: Bright DataГотовые решения компании масштабируются и настраиваются, обеспечивая большую гибкость для эффективного удовлетворения разнообразных бизнес-потребностей.

- Юридические вопросы: Полностью соответствующий отраслевым стандартам, он обеспечивает прозрачность и снижает риски, связанные с извлечением данных.

- Поддержка клиентов: Я мог легко связаться со службой поддержки клиентов через чат, телефон и электронную почту, что делало ее очень отзывчивой и полезной.

- Поддержка платформы: Он позволяет вам использовать сервис в Интернете, обслуживая широкий круг пользователей и отраслей по всему миру.

Плюсы

- Он обеспечивает бесперебойную работу сети 99.99%.

- Мне понравилось его безграничное вращение и пропускная способность.

- Проводя оценку, я заметил, что доступна очень большая серверная инфраструктура, обеспечивающая надежную масштабируемость для различных нужд.

Минусы

- Меня разочаровал процесс настройки, который может быть сложным и отнимать много времени.

Как получить Bright Data бесплатно?

Какие платформы No-Code web scraper tools можно использовать для сбора данных с динамических веб-сайтов

Бизнес-пользователи и программисты, порой, как кошка с собакой. Одни строго недовольны другими. Пользователи все время придумывают новые и новые сценарии применения того или иного программного решения, а программисты стремятся максимально оптимизировать ресурсы, систематизировав входящие запросы.

Учитывая, что читать мысли могут единицы, предугадать все особенности будущей системы на старте практически невозможно. Отсюда возникает потребность ее перманентной оптимизации уже после старта проекта. Местами это напоминает сизифов труд, когда мы что-то делали-делали, сломали и снова делаем и так много раз подряд.

Есть и еще одно обстоятельство. Пользователь «по ходу пьесы» может применять десятки различных инструментов: email (в веб-версии или через клиент), табличный редактор, несколько мессенджеров, CRM, систему управления проектами, задачник, адресную книгу (смело включайте в этот список любые приложения по вкусу — и он все равно он останется далеко неполным).

Оркестрация этих приложений — рутина, способная окончательно превратиться в мигрень для подручных разработчиков (если они есть, конечно). При этом, помним, что разработчики просто не могут предусмотреть всех возможных вариантов использования имеющихся приложений.

Какие платформы No-Code web scraper tools имеют наибольшую функциональность

Xano — это универсальная серверная платформа no-code , которая позволяет разработчикам и нетехническим пользователям создавать, управлять и развертывать серверные приложения и API без написания кода. Он оптимизирует процесс разработки приложений, предоставляя полный набор инструментов и услуг, включая хранение данных, аутентификацию пользователей, создание API, бессерверные вычисления и обновления в реальном времени.

Одной из выдающихся особенностей Xano является мощный конструктор API, который позволяет пользователям проектировать и создавать API-интерфейсы RESTful и GraphQL, используя визуальный интерфейс без каких-либо знаний в области кодирования. Интуитивно понятный интерфейс платформы позволяет пользователям определять структуры данных, создавать связи и легко манипулировать данными. Кроме того, Xano предлагает серверную логику посредством пользовательских функций, что позволяет разработчикам при необходимости расширять возможности платформы с помощью своего кода.

Встроенная система управления пользователями Xano упрощает процесс аутентификации пользователей, авторизации и управления доступом на основе ролей, обеспечивая безопасность и конфиденциальность данных приложений. Кроме того, платформа поддерживает бесшовную интеграцию со сторонними сервисами, позволяя пользователям легко подключать свои приложения к внешним API и инструментам, повышая адаптивность платформы.

Xano предлагает комплексное серверное решение no-code , которое подходит как разработчикам, так и нетехническим пользователям, позволяя им быстро и эффективно создавать, развертывать и масштабировать приложения. Предоставляя набор серверных услуг и удобную для пользователя среду визуальной разработки, Xano способствует межфункциональному сотрудничеству и ускоряет процесс разработки программного обеспечения.

Какие платформы No-Code web scraper tools имеют наибольшую удобную и интуитивную пользовательскую среду

Компания Bright Data занимает лидирующие позиции в индустрии сбора веб-данных, управляя обширной и разнообразной сетью прокси-серверов по всему миру. Сеть компании насчитывает миллионы резидентных прокси-серверов , которые идеально подходят для реализации стратегий ротации IP-адресов, необходимых для эффективного веб-парсинга.

На базе этой инфраструктуры Bright Data предлагает множество инструментов и служб веб-парсинга, включая API для Web Scraper. Этот облачный инструмент позволяет получить доступ к настраиваемым конечным точкам API, предназначенным для извлечения веб-данных из популярных доменов и отвечающим сложным потребностям проектов по сбору данных.

API для Web Scraper разработаны для обеспечения масштабируемости и надежности и устранения распространенных технических препятствий, возникающих при веб-парсинге, таких как преодоление антибот-механизмов.

Поэтому такие API становятся предпочтительным решением для сбора данных для организаций, которые стремятся усовершенствовать свои инициативы, основанные на данных. При этом они снижают эксплуатационные расходы и повышают эффективность сбора данных в Интернете.

- Ротация IP-адресов через прокси-серверы

- Автоматическое решение капчей

- Ротация пользовательских агентов

- Возможности рендеринга JavaScript

- Экспорт данных в удобочитаемые форматы

Другими словами, Scraper API предлагает наибольшее количество возможностей из числа других лучших инструментов веб-парсинга в рамках одной службы. Это делает его идеальным решением для обхода проблем парсинга, снижения общих затрат и экономии времени.

Плюсы :

- Время безотказной работы: 99,9%

- Неограниченное масштабирование

- На 100% соответствует требованиям и этике

- Поддержка людьми 24/7

Минусы :

- Не бесплатный

Стоимость :

Цены зависят от количества записей и типа домена. От 0,001 $.

Доступна бесплатная пробная версия.

Какие платформы No-Code web scraper tools имеют наибольшую стоимость

В современном мире информационных технологий веб-скрапинг стал неотъемлемым инструментом для извлечения данных из интернет-ресурсов. Чтобы максимально эффективно использовать этот метод, следует придерживаться ряда лучших практик:

- Уважение к robots.txt: перед началом скрапинга сайта всегда проверяйте файл robots.txt. Это позволит узнать, какие страницы администрация сайта предпочитает исключить из индексации поисковыми системами и скрапинг-ботами.

- Имитация поведения человека: для предотвращения блокировки вашего скрапера, старайтесь имитировать натуральное поведение пользователя, используя задержки между запросами и варьируя заголовки HTTP-запросов.

- Эффективное использование селекторов: для точного и быстрого извлечения данных используйте CSS-селекторы или XPath. Это позволит сократить время на обработку страниц и уменьшить нагрузку на сервер.

Помимо соблюдения общих рекомендаций, важно также учитывать юридические аспекты и этические нормы. Ниже представлена таблица с примерами правильного и неправильного использования веб-скрапинга:

| Правильное использование | Неправильное использование |

|---|---|

| Сбор данных с открытых источников для анализа рынка | Извлечение контента с защищенных авторским правом ресурсов |

| Мониторинг цен конкурентов для стратегического планирования | Скрапинг личной информации без согласия пользователей |

| Агрегация данных для создания общедоступных исследований | Нагрузка на сервера сайта с целью его дестабилизации |

Соблюдение этих принципов позволит не только эффективно собирать необходимые данные, но и поддерживать положительные отношения с владельцами веб-ресурсов, а также избежать юридических проблем.