Парсер для SEO специалистов. Кому и зачем нужны парсеры сайтов

Парсер для SEO специалистов. Кому и зачем нужны парсеры сайтов

Парсеры экономят время на сбор большого объема данных и группировку их в нужный вид. Такими сервисами пользуются интернет-маркетологи, вебмастера, SEO-специалисты, сотрудники отделов продаж.

Парсеры могут выполнять следующие задачи:

- Сбор цен и ассортимента. Это полезно для интернет-магазинов. При помощи парсера можно мониторить цены конкурентов и наполнять каталог на своем ресурсе в автоматическом режиме.

- Парсинг метаданных сайта (title, description, заголовков H1) пригодится SEO-специалистам.

- Анализ технической оптимизации ресурса (битые ссылки, ошибки 404 , неработающие редиректы и др.) потребуется сеошникам и вебмастерам.

- Программы для скачивания сайтов целиком или парсеры контента (текстов, картинок, ссылок) находятся в «серой» зоне. С их помощью недобросовестные вебмастера клонируют сайты для последующей продажи с них ссылок. Сюда же отнесем парсинг данных с агрегаторов и картографических сервисов: Авито, Яндекс Карт, 2gis и других. Собранные базы используются для спамных обзвонов и рассылок.

Кому и для каких целей требуются парсеры, разобрались. Если вам нужен этот инструмент, есть несколько способов его заполучить.

- При наличии программистов в штате проще всего поставить им задачу сделать парсер под нужные цели. Так вы получите гибкие настройки и оперативную техподдержку. Самые популярные языки для создания парсеров — PHP и Python.

- Воспользоваться бесплатным или платным облачным сервисом.

- Установить подходящую по функционалу программу.

- Обратиться в компанию, которая разработает инструмент под ваши нужды (ожидаемо самый дорогой вариант).

С первым и последним вариантом все понятно. Но выбор из готовых решений может занять немало времени. Мы упростили эту задачу и сделали обзор инструментов.

Парсер для арбитража. Парсинг Telegram каналов и чатов

Чтобы за пару минут находить конкретных пользователей в чатах/каналах, а также отдельные сообщения, посты или группы заданной тематики — сегодня используют парсер Telegram. Эта программа автоматизирует рутинный процесс сбора данных, что крайне полезно для бизнеса, SMM и арбитража трафика.

Деловой фестиваль по арбитражу трафика и партнерскому маркетингу пройдет в Алматы 23-24 августа. Стань частью самого грандиозного события этого лета!

Участвуй в акции, оформляй 4 билета и получи 2 в подарок!

Подробнее

Что такое парсинг Телеграм-чатов и каналов

Основное предназначение парсера Telegram — быстро находить участников чатов или каналов по различным критериям (активные, боты, юзернейм, ID). Это позволит администратору получить базу и организовывать рассылки, информировать подписчиков о новых акциях/товарах, приглашать участников по логинам (инвайтинг). Кроме того, можно легко отсортировать список: отсеивать ботов, собирать активных или новых пользователей и т. д. Здесь о том, как раскрутить Телеграм-канал с нуля.

Плюсы:

- быстрая обработка данных и получение готового списка — его можно сохранить в txt, csv, xlsx;

- сортировка по нескольким параметрам;

- отсутствие ошибок и дублей.

Что касается недостатков. Инвайтинг, спам, рассылки — не приветствуются системой мессенджера. Это может также не понравиться пользователю, которому достаточно поставить на такие сообщения отметку СПАМ, чтобы модераторы приняли соответствующие меры. В результате спамные аккаунты блокируют на время или навсегда, если нарушения продолжаются.

Однако если организовать сеть аккаунтов, то удастся продолжить вести рекламную деятельность и лить трафик с комментариев TG , чатов и т. д. Когда блокируется один из акков, запрещенные мессенджером действия проводятся уже с другого профиля.

Парсеры для Telegram бывают простыми и многофункциональными. Первые умеют собирать пользователей, вторые еще и парсить контент и осуществлять другие полезные действия. .

5 парсеров Телеграм каналов и чатов

Ниже мы собрали 5 популярных парсеров. Они реализуются посредством специальных сервисов и ботов.

A-Parser

Это агрегатор нескольких парсеров, умеющий работать не только в самом мессенджере, но и в Facebook, интернет-магазинах, поисковых системах. A-Parser предлагает для Telegram отдельную программу, которая может собирать данные только из публичных чатов.

Что конкретно делает A-Parser в Телеграме:

- собирает участников, которые что-то писали в группе или присоединялись к ней;

- парсит контент — тексты, изображения, ссылки на

- обрабатывает результаты непосредственно во время парсинга;

- выводить данные в нескольких форматах — JSON, SQL, CSV;

- поддерживает JavaScript, TypeScript и т. д.

Цена на вечное пользование A-Parser начинается со $119. А еще этот сервис позволяет заказать индивидуальный парсер под конкретную задачу. Для этого нужно заполнить бриф на сайте.

Удобный софт для продвижения, который поможет привлекать клиентов и зарабатывать на своих проектах.

- делать накрутку;

- делать рассылку по ЛС, телефонам и группам за считанные минуты — есть возможность также отправлять аудиофайлы и посты из каналов;

- наполнять группы и чаты живыми пользователями;

- собирать аудиторию с любых Телеграм-групп, с одновременным отсеиванием ботов;

- запускать автопостинг для Телеграма ;

- проверять номера телефонов на факт их регистрации в Telegram.

Софт имеет 3 тарифа: демо, ежемесячная лицензия и безлимит.

@ParserFree2Bot

Бесплатный бот, умеющий только собирать участников из открытых чатов. Просто вставляете в программу ссылку на конкретную Телеграм-группу, и через несколько секунд получаете:

- всех участников группы;

- список активных пользователей;

- список неактивных пользователей.

Как и говорилось, прога целиком бесплатная. Техническая поддержка осуществляется через чат @promfree.

Telecobra

Этот парсер регистрирует акки, приглашает аудиторию в группы и чаты, рассылает sms и т. д.

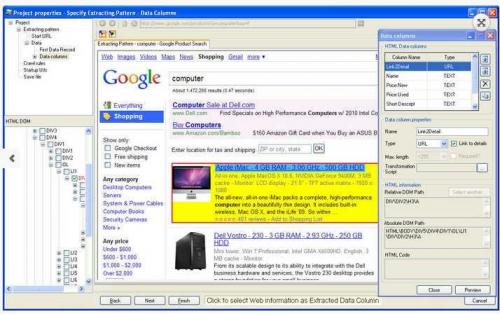

Универсальный парсер. Datacol — универсальный парсер

Уже несколько лет парсера являются незаменимыми инструментами для вебмастеров. Они дают возможность собирать и обрабатывать информацию в больших объемах. Парсера можно использовать в разных целях. Среди них: наполнение интернет магазинов, создание сателлитов, наполнение сайта контентом, изучение конкурентов и т. д. Большинство парсеров разработчики делают узкоспециализированными (выполняющими одну конкретную задачу). Исключением являются универсальные парсера, позволяющие автоматизировать сбор любой информации, которая представлена в интернете. Если вам необходим универсальный парсер, который вы сможете самостоятельно настраивать для парсинга любых сайтов, значит вам нужен Datacol. На базе функционала Datacol можно настроить универсальный парсер контента, универсальный парсер сайтов недвижимости, парсер интернет магазинов и т. д. Вот краткий список основных применений:

- Наполнение интернет магазинов ;

- Парсинг объявлений ;

- Наполнение сайтов контентом ;

- Парсинг социальных сетей ;

- Парсинг контактных данных ;

- Парсинг данных для SEO специалистов ;

- И другие решения!

Универсальный парсер сайтов

Одним из самых распространенных применений универсального парсера сайтов является парсинг товаров для интернет магазинов. Эту задачу можно легко реализовать на базе Datacol. Благодаря универсальному парсеру сайтов вы сможете обеспечить автоматическое наполнение своего магазина товарами, потратив при этом минимум времени. Представим список основных настроек интернет магазинов, реализованных на базе Datacol:

- Парсер интернет магазинов поможет вам в решении задачи автоматического сбора товаров с любого интересующего онлайн магазина, сайта вашего поставщика либо торговой площадки.

- Парсер Hotline собирает нужную информацию с интересующих категорий сайта hotline.ua и экспортирует ее в CSV файл (для дальнейшей выгрузки данных на ваш сайт).

- Парсер Яндекс Маркета автоматически производит сбор информации о товарах с Яндекс.Маркета из заданной категории или по заданному списку наименований.

- Парсер Таобао получает информацию о товарах из заданных категорий китайского интернет магазина taobao.com и экспортирует собранные данные в CSV файл для импорта в ваш магазин.

- Парсер Aliexpress решает задачу автоматического получения информации о товарах из заданных категорий торговой площадки aliexpress.com.

- Парсер Ebay получает данные о товарах интернет аукциона ebay.com. Собранная информация о всех товарах сохраняется в CSV файл, который импортируется в ваш интернет магазин.

- Парсер Focalprice получает информацию о интересующих товарах торговой площадки focalprice.com.

- Парсер Tinydeal получает информацию из заданных категорий китайского сайта tinydeal.com.

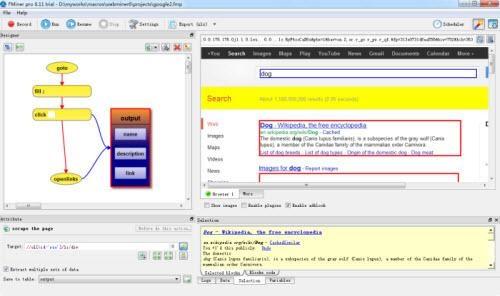

Парсинг сайтов python. Инструменты

Для отправки http-запросов есть немало python-библиотек, наиболее известные urllib/urllib2 и Requests. На мой вкусудобнее и лаконичнее, так что, буду использовать ее.Также необходимо выбрать библиотеку для парсинга html, небольшой research дает следующие варианты:

- re

Регулярные выражения, конечно, нам пригодятся, но использовать только их, на мой взгляд, слишком хардкорный путь, и они немного не для этого . Были придуманы более удобные инструменты для разбора html, так что перейдем к ним. - BeatifulSoup , lxml

Это две наиболее популярные библиотеки для парсинга html и выбор одной из них, скорее, обусловлен личными предпочтениями. Более того, эти библиотеки тесно переплелись: BeautifulSoup стал использовать lxml в качестве внутреннего парсера для ускорения, а в lxml был добавлен модуль soupparser. Подробнее про плюсы и минусы этих библиотек можно почитать в обсуждении . Для сравнения подходов я буду парсить данные с помощью BeautifulSoup и используя XPath селекторы в модуле lxml.html. - scrapy

Это уже не просто библиотека, а целый open-source framework для получения данных с веб-страниц. В нем есть множество полезных функций: асинхронные запросы, возможность использовать XPath и CSS селекторы для обработки данных, удобная работа с кодировками и многое другое (подробнее можно почитать тут ). Если бы моя задача была не разовой выгрузкой, а production процессом, то я бы выбрала его. В текущей постановке это overkill.

Источник: https://lajfhak.ru-land.com/stati/pishem-parser-na-python-scrapy-vs-beautiful-soup

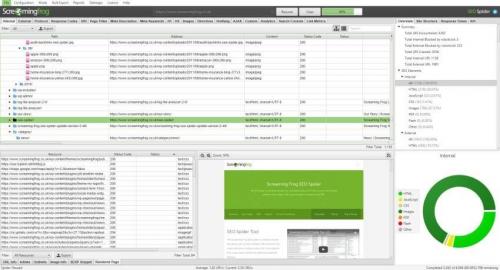

Парсинг базы данных. Screaming Frog SEO Spider

— известная программа, специализирующаяся на работе с SEO данными, имеет широчайший функционал для аудита сайтов и парсинга данных, перечисление всех возможностей программы займет много времени, в нашем обзоре рассмотрим основные возможности программы. При первом взгляде интерфейс программы кажется, но через некоторое время понимаешь, что интерфейс структурирован, вкладки организованны для быстрого доступа к важной информации и в целом работа удобна.

— известная программа, специализирующаяся на работе с SEO данными, имеет широчайший функционал для аудита сайтов и парсинга данных, перечисление всех возможностей программы займет много времени, в нашем обзоре рассмотрим основные возможности программы.

Интерфейс программы

При первом взгляде интерфейс программы кажется, но через некоторое время понимаешь, что интерфейс структурирован, вкладки организованны для быстрого доступа к важной информации и в целом работа удобна.

Основные возможности программы:

- Парсинг сайта: программа может парсить сайт, собирать информацию о страницах, включая текст, метки, ссылки и другие

- Анализ сайта: программа может анализировать сайт, обнаруживать ошибки, проблемы и предложения по улучшению

- Отчеты: программа может генерировать отчеты о результатах парсинга и анализа

- Мониторинг сайта: программа может мониторить сайт, обнаруживать изменения и изменения веб-страниц

Ограничения в бесплатной версии:

Ограничения в бесплатной версии:  Ограничения в бесплатной версии:

Ограничения в бесплатной версии: Парсинг поисковой выдачи. Зачем нужны парсеры

Парсер — это программа, сервис или скрипт, который собирает данные с указанных веб-ресурсов, анализирует их и выдает в нужном формате.

С помощью парсеров можно делать много полезных задач:

- Цены . Актуальная задача для интернет-магазинов. Например, с помощью парсинга вы можете регулярно отслеживать цены конкурентов по тем товарам, которые продаются у вас. Или актуализировать цены на своем сайте в соответствии с ценами поставщика (если у него есть свой сайт).

- Товарные позиции : названия, артикулы, описания, характеристики и фото. Например, если у вашего поставщика есть сайт с каталогом, но нет выгрузки для вашего магазина, вы можете спарсить все нужные позиции, а не добавлять их вручную. Это экономит время.

- Метаданные : SEO-специалисты могут парсить содержимое тегов title, description и другие метаданные.

- Анализ сайта . Так можно быстро находить страницы с ошибкой 404, редиректы, неработающие ссылки и т. д.

Для справки . Есть еще серый парсинг. Сюда относится скачивание контента конкурентов или сайтов целиком. Или сбор контактных данных с агрегаторов и сервисов по типу Яндекс.Карт или 2Гис (для спам-рассылок и звонков). Но мы будем говорить только о белом парсинге, из-за которого у вас не будет проблем.

Где взять парсер под свои задачи

Есть несколько вариантов:

- Оптимальный — если в штате есть программист (а еще лучше — несколько программистов). Поставьте задачу, опишите требования и получите готовый инструмент, заточенный конкретно под ваши задачи. Инструмент можно будет донастраивать и улучшать при необходимости.

- Воспользоваться готовыми облачными парсерами (есть как бесплатные, так и платные сервисы).

- Десктопные парсеры — как правило, программы с мощным функционалом и возможностью гибкой настройки. Но почти все — платные.

- Заказать разработку парсера «под себя» у компаний, специализирующихся на разработке (этот вариант явно не для желающих сэкономить).

Первый вариант подойдет далеко не всем, а последний вариант может оказаться слишком дорогим.

Что касается готовых решений, их достаточно много, и если вы раньше не сталкивались с парсингом, может быть сложно выбрать. Чтобы упростить выбор, мы сделали подборку самых популярных и удобных парсеров.

Законно ли парсить данные?

В законодательстве РФ нет запрета на сбор открытой информации в интернете. Право свободно искать и распространять информацию любым законным способом закреплено в четвертом пункте 29 статьи Конституции.

Допустим, вам нужно спарсить цены с сайта конкурента. Эта информация есть в открытом доступе, вы можете сами зайти на сайт, посмотреть и вручную записать цену каждого товара. А с помощью парсинга вы делаете фактически то же самое, только автоматизированно.

Но если вы хотите собрать персональные данные пользователей и использовать их для email-рассылок или таргетированной рекламы, это уже будет незаконно (эти данные защищены законом о персональных данных ).