ТОП-7 парсеров для сбора поисковых подсказок. Парсер поисковых подсказок, сервис Раш Аналитикс (Rush Analytics)

- ТОП-7 парсеров для сбора поисковых подсказок. Парсер поисковых подсказок, сервис Раш Аналитикс (Rush Analytics)

- Арсенкин Евгений Юрьевич: в каких юридических лицах значится

- Семантическое ядро автоматически. Сервисы для автоматического сбора семантического ядра

- Парсер поисковых запросов. Решение

- Key Collector: полное практическое руководство

- Key collector аналоги. Топ-10 сервисов и программ для парсинга

ТОП-7 парсеров для сбора поисковых подсказок. Парсер поисковых подсказок, сервис Раш Аналитикс (Rush Analytics)

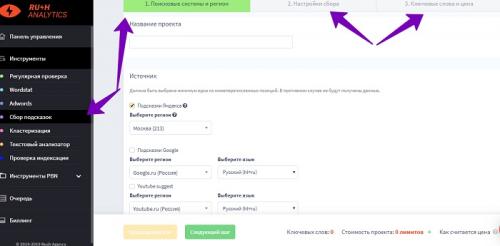

Сервис Раш Аналитикс осуществляет быстрый парсер поисковых подсказок в Яндексе и Гугле. На нём также нужно зарегистрироваться и подтвердить свою учётную запись. Далее, заходим в левую часть панели управления сервиса – «Сбор подсказок» и создаём там «Новый проект». (Скрин 4).

Затем, кликаем по кнопке «Следующий шаг» и заполняем настройки другого раздела – «Настройка сбора». В нём лишь нужно оставить две галочки перед параметрами – «Ключевое слово» или установить по желанию другие параметры. После всех изменений нажимаем на «Следующий шаг» и попадаем в другой раздел – «Ключевые слова и цена».

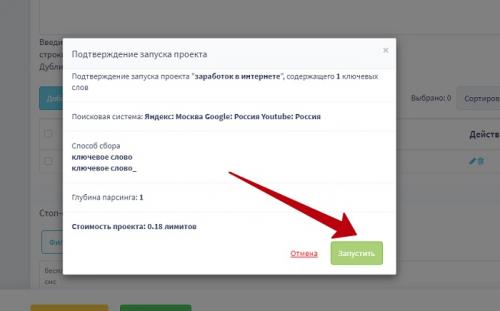

Там где раздел «Списком» прописываем ключевые слова. И нажимаем кнопку «Добавить ключевые слова». Затем, очень важно нажать на «Создать проект», чтобы запустить процесс сбора ключевых слов (Скрин 5).

Когда парсер ключевых слов будет закончен, Вы сможете скачать готовые ключи, или посмотреть их на сервисе. Обычно формат таких файлов скачивается на компьютер в виде Эксель таблицы, что очень удобно.

Преимущество сбора подсказок в Раш Аналитикс

Стоит рассказать о самых главных преимуществах сбора подсказок на сервисе Rush-analytics. Они действительно помогут Вам продвинуть блог, сайт и раскрутить статьи:

- Ненужные поисковые запросы удаляются. Алгоритм данного сервиса отслеживает и удаляет те подсказки во время сбора, которые не приносят трафика. И оставляют в базе подсказок самый топ поисковых ключей.

- Можно установить любой регион и язык. Раш Аналитикс поддерживает любые иностранные языки для поиска, и настраивает все регионы. Например, Москва, Ульяновская область и другие.

- Глубокое исследовании ниши. Сервис очень глубоко исследует нишу Вашего бизнеса, и поэтому после сбора подсказок можно получить в результате популярные ключевые слова.

Эти преимущества, дают понять что этот сервис стоит использовать для продвижения статей, несмотря на то, что он платный.

Арсенкин Евгений Юрьевич: в каких юридических лицах значится

Согласно данным Единого государственного реестра юридических лиц (ЕРГЮЛ) от 09.11.2022, публикуемым налоговой службой РФ, Арсенкин Евгений Юрьевич (ИНН 633004708684 ) упоминается в следующих юридических лицах.

- ООО "КОРОВКИНО"

Данный ИНН был выдан налоговой инспекцией региона Самарская область .

Организации, в отношении которых упоминается данное лицо, зарегистрированы в регионе Самарская область (аренда и лизинг грузовых транспортных средств; выращивание однолетних культур).

Ранее Арсенкин Е. Ю. значился в сведениях об организации, зарегистрированной в регионе Самарская область: оптовая торговля прочим жидким и газообразным топливом.

Руководитель, директор

До 25 декабря 2013 г.Арсенкин Е. Ю. был руководителем (лицом, имеющим право без доверенности действовать от имени юридического лица).

Учредитель Арсенкин Е. Ю.

Арсенкин Е. Ю. является учредителем в организациях:

Арсенкин Евгений Юрьевич и опосредованно связанные лица

По данным, содержащимся в ЕГРЮЛ, прослеживаются следующие косвенные связи лица с российскими организациями, их руководителями, учредителями. Обращаем внимание, что связи могут носить формальный характер и не обязательно свидетельствуют о реальных контактах указанных лиц. При установлении связи учитывалось совпадение не только фамилии, имени и отчества, но и ИНН физического лица.

Семантическое ядро автоматически. Сервисы для автоматического сбора семантического ядра

Статья

48430

Парсить ключи вручную – звучит очень долго и муторно. Автоматический парсинг занимает считанные минуты, тогда как на ручной может уйти несколько дней или недель.

Конечно, если у вас не больше 20-30 исходных ключевиков, быстрее всё сделать руками и не заморачиваться с сервисом. Многие из них к тому же платные. Но когда ключей сотни и тысячи, автоматизация сделает значительную часть работы за вас.

В этой статье – краткий обзор самых популярных сервисов сбора семантического ядра, которые пригодятся всем PPC- и SEO-специалистам.

Key Collector

Самая известная программа по работе с семантикой в целом. Её функционал позволяет парсить не просто список ключей, а ключей:

- Из самых разных популярных источников (среди них – рекламные сервисы Yandex Wordstat, Google Ads, Rambler Adstat) и поисковых подсказок систем;

- Вместе со статистикой из Liveinternet, Google Analytics, Яндекс.Метрики, Яндекс.Вебмастер, Serpstat и других сервисов;

- С учетом конкретного региона и сезонности;

- По нужной глубине поиска;

- С оценками стоимости продвижения, популярности, конкуренции, трафика и других параметров;

- Со значениями частотности;

- С возможностью последующей группировки (кластеризации);

- С возможностью составления минус-списков.

Чтобы воспользоваться всеми возможностями Key Collector, нужно установить программу на компьютер.

Стоит такое удовольствие 2 200 рублей при покупке одной лицензии. Если нужно устанавливать программу на 2 и более рабочих местах, стоимость отдельной лицензии снижается. Например, каждая вторая и десятая стоит 1 700 рублей, а каждая одиннадцатая – 1 500 рублей.

За эту стоимость вы получаете постоянно обновляемый инструмент со множеством функций, который довольно легко освоить самостоятельно с нуля и в котором можно работать с большими объемами семантики.

Подробно все функции и фишки Key Collector мы разобрали в этой статье .

Недостатки: большая нагрузка на компьютер, из-за чего он может глючить. И второе – программу не получится запустить на MacOS.

Перейти на сайт программы

Словоеб

Бесплатный аналог Key Collector – тот же принцип работы и в целом тот же интерфейс.

Функционал по сравнению с KK ограниченный, но его вполне достаточно для небольших проектов.

Итак, Словоеб выполняет парсинг:

- Левой и правой колонок Wordstat;

- Rambler.Adstat;

- Поисковых подсказок Яндекса и Google.

В целом сервис делает всю ту же самую работу, что и вы при сборе ключей в Yandex Wordstat, но автоматически, освобождая вам время на выполнение других задач.

Да, в нем нет многих функций, в том числе чистки и группировки семантики, выгрузки результатов, но этим оправдана его «бесплатность».

Подробное руководство по тому, как работать в Словоебе, смотрите здесь .

Перейти на сайт программы

SpyWords

Облачный сервис для выгрузки ключевых слов (не парсер!), которыми пользуются ваши конкуренты и в целом для мониторинга конкурентов (домены, объявления, анализ ниши).

С помощью онлайн-сервиса SpyWords вы можете найти ключевые фразы, которые используют конкуренты в Яндекс или Google, и добавить их в свои рекламные кампании, если семантика нужна для контекстной рекламы.

Парсер поисковых запросов. Решение

Тут нету ничего сложного.

Во-первых,

все необходимое для получения результатов поиска передается через GET-параметры, а именно:- text — текст поискового запроса. URL-кодированный.

- p — номер страницы выдачи (p=0, 1, 2…). Without comments

- numdoc — число выдаваемых результатов на страницу(numdoc=10, 20, 30, 50; допустимы только эти значения и никакие более). Для анализа позиций сайта по ключевым словам лучше всего юзать наибольшее значение, т.к. явное уменьшение нагрузки на сервер и, как следствие — меньше подозрений, что «Я, робот»

yandex.ru/yandsearch?text=&p=&numdoc= Во-вторых,

Выдача Яндекса подвергается разбору на нужные нам составляющие, путем прогона через регулярное выражение вида:#

- preg_match_all(РЕГВЫР, HTML_ВЫДАЧИ, МАССИВ_РЕЗУЛЬТАТОВ, PREG_SET_ORDER);

В итоге,

Вот по какой схеме я работаю, чтобы найти сайт в Яндексе по определенному запросу (поиск до первого вхождения):- получаю первую страницу с выдачей

- если это не «страница недоверия» Яндекса с капчей — прогоняю через регвыр, перебираю результаты в поиске нужного.

- если нахожу, возвращаю результат — номер позиции страницы в выдаче, не нахожу — получаю следующую страницу и возвращаюсь к п.2, подождав секунды 3-5

- resultsLimit — ограничение по глубине поиска, по умолчанию

люблю ставить 200 - url — имя хоста, который ищем в выдаче. Учитывается любая страница с этого хоста

- keyword — запрос к поисковику.

Реализовано

это посредством иерархии классов (чтобы при надобности легко расширять функциональность анализатора на другие поисковики).Абстрактный класс — SomeAnalyzer:

- abstractclassSomeAnalyzer{

- //// ИНТЕРФЕЙС

- // функция анализа

- publicabstractfunction analyzeThis($url);

- // получение имени хоста из url (parse_url с дополнительным функционалом, поскольку убедился что просто parse_url не всегда почему-то работает, когда url слишком неудобочитаемый)

- publicfunction getHost($url){

- $url=@parse_url($url);

- if($url'path'

Key Collector: полное практическое руководство

Статья

63610

Key Collector – инструмент парсинга, который на слуху у всех, кто когда-либо сталкивался со сбором семантики. Что может остановить и заставить делать выбор не в пользу этой программы?

Во-первых, наличие бесплатного аналога – Словоеба. Но его функций может не хватить, если у вас большие объемы семантики и вы рекламируетесь не только в Яндексе. Во-вторых, программа платная. Однако соотношение «цена – возможности» оправдывает стоимость. В-третьих, новичка может испугать множество кнопок и настроек.

В этой статье мы охватим все аспекты в работе с Key Collector. Покажем, как настраивать эту программу, как работать с ней и не запутаться в бесконечных опциях.

Что может Key Collector

Возможности программы просто поражают воображение. На выходе она дает не просто список ключей, а ключей:

- Из самых разных популярных источников (среди них – рекламные сервисы Yandex Wordstat, Google Ads, Rambler Adstat) и поисковых подсказок систем

- Вместе со статистикой из Liveinternet, Google Analytics, Яндекс.Метрики, Яндекс.Вебмастер, Serpstat и других сервисов

- С учетом конкретного региона и сезонности

- По нужной глубине поиска

- С оценками стоимости продвижения, популярности, конкуренции, трафика и других параметров

- Со значениями частотности

- С возможностью последующей группировки (кластеризации)

- С возможностью составления минус-списков.

Key collector аналоги. Топ-10 сервисов и программ для парсинга

Парсинг данных стал неотъемлемой частью работы маркетологов, SEO-специалистов, SMM и контент-менеджеров, позволяющий получать доступ к постоянно актуальным данным и качественно использовать их в своих целях.

Приложения и сервисы для парсинга

В сети Интернет можно найти большое количество софта для сбора данных, доступны как бесплатные, так и платные, более продвинутые варианты, которые можно устанавливать на свои устройства или получить доступ онлайн через веб-браузеры. Компания Proxy-Seller выбрала топ-10 популярных программ и сервисов для парсинга, с их помощью всегда можно получить желаемый результат.

Screaming Frog что это

Screaming Frog Seo Spider являет собой программу на основе xPath, созданную для настраиваемого парсинга и обширного аудита сайтов. Она по праву считается эталоном по сбору данных и аналитике. Несмотря на громоздкий интерфейс отлично структурировано меню, пользователи всегда смогут легко и быстро получить доступ к важной информации.

Screaming Frog владеет следующими возможностями:

Парсинг данных сайтов;

Глубокий аудит SEO-показателей веб-страниц;

Сбор метаданных и заголовков;

Мониторинг рабочих и нерабочих ссылок;

Работа с sitemap и robot.txt;

Поддержка прокси, 500 адресов в бесплатной версии и неограниченное (зависит от количества прокси) в платной;

Детальные уроки и документация.

Софт совместим с операционными системами Windows, MacOS, Ubuntu.

Scraper API

Если вы владеете одним из популярных языков программирования под Интернет (PHP, Python, Ruby или NodeJS), то данный онлайн сервис отлично подойдет вам для решения задач связанных с парсингом данных. Одним из преимуществ в виде быстрого сбора информации, является неограниченное использование в Scraper API прокси.

Возможности Scraper API:

Поддержка одновременно до 40 млн IP адресов;

Дюжина удобных геолокаций;

Поддержка Java Script;

Автоматический обход капчи;

Не лимитированная пропускная способность.

Key Collector

Программа создана, как инструмент для организации семантического ядра, автоматизации рутинных процессов парсинга и подготовки отчетов по самым эффективным поисковым запросам. Приватные прокси сервера для Key Collector, которые можно купить на сайте компании Proxy-Seller, позволяют существенно минимизировать время на сбор данных.

Функции Key Collector:

Автоматический сбор фраз, присутствует возможность настроить 50 разных параметров и одновременно использовать 30 источников информации;

Использование множества фильтров и систем анализа для получения лучших запросов;

Структурирование и маркировка групп для создания сложных проектов;

Семантическое ядро Key Collector позволяет удобно работать с данными без необходимости разбивать их на множество маленьких файлов;

Анализ групп в автоматическом режиме;

Использование минус-слов;

Поиск явных и неявных дублей.

Приложение совместимо со всеми представителями семейства Windows начиная с седьмой версии. Для работы требуется установка пакетов .NET Framework 4.8 и Microsoft Visual C++ (версии Redistributable for Visual Studio 2015, 2017 и 2019).

SpyWords

SpyWords - это онлайн инструмент (сервис) для контент-менеджеров, SEO-специалистов и интернет-маркетологов. Основное предназначение поиск ключевых слов и запросов на сайтах конкурентов и в поисковых системах. Среди возможностей SpyWords следует отметить:

Быстрый и качественный анализ сайтов;

Сбор, создание и получение семантического ядра;

Поиск запросов с максимальным трафиком в конкурентов;

Определение позиций сайта в поисковых системах по заранее заданным запросам;

Сбор запросов в контекстной рекламе;

Комплексная оптимизация SEO;

Автоматический расчет бюджета на основе собранных данных.

Keys.so

Сервис специализируется на парсинге поисковых запросов и ключевых слов конкурентов с последующим структурированием данных, проведение автоматического анализа и отбора важной информации. Он поможет выделить максимально эффективную стратегию для привлечения трафика. Среди преимуществ Keys.so выделяют:

Одна из самых огромных баз-данных ключевых слов, насчитывает более 120 млн (подсветка топов);

Высокое качество ключевых запросов, проверенных через Wordstat (подсказки и запросы из метрик);

Создание групповых отчетов, неограниченное количеством доменов (пакетный анализ);

Сравнение сайтов;

Сбор и фильтрация идей для контент-плана и новых сайтов.