Top 10 Web Scraping APIs to Watch in 2025

- Top 10 Web Scraping APIs to Watch in 2025

- Связанные вопросы и ответы

- Какие будут основные преимущества и недостатки каждого из этих 10+ лучших API для веб-сканирования в 2025 году

- Какие из этих 10+ лучших API для веб-сканирования в 2025 году будут наиболее популярными среди разработчиков

- Какие из этих 10+ лучших API для веб-сканирования в 2025 году будут наиболее доступными для начинающих пользователей

- Какие из этих 10+ лучших API для веб-сканирования в 2025 году будут наиболее эффективными в плане скорости и производительности

Top 10 Web Scraping APIs to Watch in 2025

Web scraping API позволяют разработчикам легко извлекать данные из веб-сайтов без необходимости писать много кода. В этой статье мы рассмотрим 10 лучших веб-сканирующих API, которые стоит следить за в 2025 году.

1. ScrapingBee

ScrapingBee - это API для веб-сканирования, которое обеспечивает высокую скорость и точность. Он поддерживает JavaScript и CAPTCHA, что делает его идеальным выбором для разработчиков, которые хотят извлекать данные из динамических веб-сайтов.

1. Apify

Apify - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

1. ScrapingHub

ScrapingHub - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

1. Octoparse

Octoparse - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

1. ParseHub

ParseHub - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

1. Diffbot

Diffbot - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

1. Import.io

Import.io - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

1. Webhose

Webhose - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

1. SerpApi

SerpApi - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

1. Zyte

Zyte - это платформа для веб-сканирования, которая предоставляет API для извлечения данных из веб-сайтов. Он поддерживает JavaScript и обеспечивает высокую скорость и точность.

Выбор API для веб-сканирования зависит от ваших потребностей и предпочтений. Все перечисленные выше API являются отличными выборами для разработчиков, которые хотят извлекать данные из веб-сайтов.

Связанные вопросы и ответы:

Вопрос 1: Что такое веб-скрейпинг API

Ответ: Веб-скрейпинг API - это программный интерфейс, который позволяет автоматизировать процесс сбора данных с веб-сайтов. Он используется для извлечения информации из веб-страниц и предоставляет эту информацию в удобном для обработки формате, таком как JSON или CSV. Веб-скрейпинг API обычно используется для получения данных из динамических веб-сайтов, которые не предоставляют API для доступа к своим данным.

Вопрос 2: Какие преимущества использования веб-скрейпинг API

Ответ: Использование веб-скрейпинг API имеет ряд преимуществ. Во-первых, он позволяет автоматизировать процесс сбора данных, что сокращает время и усилия, необходимые для получения информации из веб-сайтов. Во-вторых, он обеспечивает доступ к данным в удобном для обработки формате, что упрощает их анализ и использование. В-третьих, он позволяет извлекать данные из динамических веб-сайтов, которые не предоставляют API для доступа к своим данным.

Вопрос 3: Какие проблемы могут возникнуть при использовании веб-скрейпинг API

Ответ: При использовании веб-скрейпинг API могут возникнуть ряд проблем. Во-первых, некоторые веб-сайты могут блокировать доступ к своим страницам для ботов и скриптов, что может ограничить возможности веб-скрейпинг API. Во-вторых, некоторые веб-сайты могут менять структуру своих страниц, что может привести к ошибкам и неправильному извлечению данных. В-третьих, использование веб-скрейпинг API может быть запрещено на некоторых веб-сайтах, что может привести к юридическим проблемам.

Вопрос 4: Какие типы данных можно извлекать с помощью веб-скрейпинг API

Ответ: С помощью веб-скрейпинг API можно извлекать различные типы данных, такие как текст, изображения, видео, аудио, таблицы, формулы и многое другое. Он позволяет извлекать данные из динамических веб-сайтов, которые не предоставляют API для доступа к своим данным, а также извлекать данные из статических веб-сайтов.

Вопрос 5: Какие факторы следует учитывать при выборе веб-скрейпинг API

Ответ: При выборе веб-скрейпинг API следует учитывать ряд факторов. Во-первых, необходимо учитывать функциональность API, его возможности и ограничения. Во-вторых, следует учитывать стоимость API, а также условия лицензирования и использования. В-третьих, необходимо учитывать репутацию и надежность API, а также наличие технической поддержки.

Вопрос 6: Какие популярные веб-скрейпинг API существуют в настоящее время

Ответ: В настоящее время существует множество популярных веб-скрейпинг API, таких как Scrapy, BeautifulSoup, Selenium, Puppeteer, Cheerio и другие. Они различаются по функциональности, возможностям и ограничениям, а также по стоимости и условиям лицензирования и использования.

Вопрос 7: Какие технологии используются для разработки веб-скрейпинг API

Ответ: Для разработки веб-скрейпинг API используются различные технологии, такие как Python, JavaScript, Ruby, PHP и другие. Они позволяют создавать API с различными функциями и возможностями, а также обеспечивают доступ к данным в удобном для обработки формате.

Вопрос 8: Какие ограничения могут быть наложены на использование веб-скрейпинг API

Ответ: Использование веб-скрейпинг API может быть ограничено рядом факторов. Во-первых, некоторые веб-сайты могут блокировать доступ к своим страницам для ботов и скриптов, что может ограничить возможности веб-скрейпинг API. Во-вторых, некоторые веб-сайты могут ограничивать количество запросов, которые можно отправить за определенный промежуток времени. В-третьих, некоторые веб-сайты могут запрещать использование веб-скрейпинг API на своем сайте, что может привести к юридическим проблемам.

Какие будут основные преимущества и недостатки каждого из этих 10+ лучших API для веб-сканирования в 2025 году

Программный интерфейс приложения — это инструмент, сообщающий системе команду от разработчика и возвращающий ему ответ. Так что воспринимайте API просто как эффективный мессенджер между вами и ПО.

С этой позиции вам сразу станет понятно, насколько полезно использовать API-интерфейсы в работе над проектами.

1.Обменный курс

Exchange Rate конвертирует больше 160 валют. Он очень прост в использовании, отличается быстродействием и высокой точностью.

Подсказка для проекта:

разработайте веб-сайт, с помощью которого пользователи смогут выбирать валюту и конвертировать ее в остальные.

2.Spotify API

Собирайте метаданные про исполнителей, их песни, а также данные пользователей.

Подсказка для проекта:

добавьте на сайт поиск по Spotify.

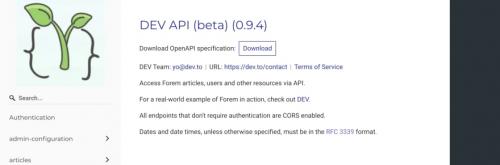

3.DEV API

Крутой API, благодаря которому вы сможете делать публикации, получать от пользователя комментарии к статьям, видеть подписки читателей на теги и пр.

Подсказка для проекта:

сделайте крутой веб-сайт со своими собственными статьями!

4.YouTube API

Используя этот официальный API для Ютуб, вы получите возможность запрашивать данные этого

Подсказка для проекта:

5.API Twilio

Крайне полезный инструмент, который можно использовать для многих целей. К примеру, чтобы отправлять сообщения с Twilio на различные другие номера.

Подсказка для проекта:

запрограммируйте бота, который будет по праздникам отправлять вашим друзьям поздравления.

Какие из этих 10+ лучших API для веб-сканирования в 2025 году будут наиболее популярными среди разработчиков

API Bright Data Web Scraper — один из самых продвинутых и одновременно простых в использовании парсеров из доступных. Это облачное решение, которое может выполнять парсинг данных на веб-странице и возвращать их в структурированном формате независимо от механизмов защиты от парсинга, которые может использовать целевой сайт:

Вот краткий обзор особенностей Bright Data Web Scraper API:

| Преимущества | Недостатки |

|---|---|

| Многочисленные настраиваемые шаблоны | Не бесплатный |

| Отличная масштабируемость | |

| Непревзойденная прокси-инфраструктура | |

| 99% времени безотказной работы и миллионы IP-адресов реальных пользователей | |

| Онлайн-поддержка 24/7 | |

| Множество вариантов доставки данных | |

| На 100% соответствует требованиям, лидер в отрасли | |

| Гибкая структура цен и бесплатная пробная версия |

API-интерфейсы Web Scraper от Bright Data чрезвычайно упрощают извлечение данных из Интернета. Доступны API-интерфейсы для многих веб-сайтов, включая популярные домены, такие как Amazon, Facebook, YouTube, LinkedIn и eBay. Эти API-интерфейсы помогают получить все точки данных, обычно собираемые с веб-сайта. Например, API парсера YouTube позволяет быстро извлекать заголовки, описания, комментарии и количество просмотров видео, а API парсера Instagram дает возможность получать информацию о подписчиках, фотографии, комментарии и множество других данных из профиля Instagram. Затем эти данные можно экспортировать в различные форматы, включая JSON, NDJSON или CSV.

Пользоваться API Web Scraper можно очень просто с помощью панели управления Bright Data. Удобная панель управления и обширная документация упрощают настройку и использование API.

Помимо простоты, еще одним преимуществом API Bright Data Web Scraper является масштабируемость. Даже по мере роста ваших потребностей в очистке данных API Web Scraper может масштабировать ваши парсеры без снижения производительности. Производительность неизменно оптимальна, а количество отказов сведено к абсолютному минимуму. Прокси-инфраструктура Bright Data не имеет себе равных: она обеспечивает доступ кпрактически во всех странах мира и доля времени ее безотказной работы составляет 99,99 %. А если у вас возникнут какие-либо проблемы, компания предлагает круглосуточную поддержку в режиме 24/7.

API Bright Data Web Scraper обладает всеми функциями, которые вы ожидаете от лучшего средства мгновенного парсинга данных, такими как автоматическая ротация IP-адресов, ротация пользовательских агентов и средства решения капч. Кроме того,и является лидером отрасли в этом отношении, поскольку ее практика соответствует различным законам о защите данных, таким каки.

Стоимость API Web Scraper от Bright Data зависит от количества записей и типа домена и начинается с 0,001 $ за запись. Вы можете выбрать план с оплатой по факту использования, и вам доступна бесплатная пробная версия, позволяющая бесплатно тестировать API Web Scraper, чтобы убедиться, что он соответствуют вашим потребностям.

Какие из этих 10+ лучших API для веб-сканирования в 2025 году будут наиболее доступными для начинающих пользователей

Интерфейсы прикладного программирования (API) являются важнейшим компонентом большинства современных программ и приложений. На самом деле, деплои в облаке и мобильные приложения сейчас сильно полагаются на API, поскольку они предназначены для управления различными элементами. Многие крупные компании, особенно те, которые ведут активную деятельность в Интернете, имеют сотни или даже тысячи API, встроенных в их инфраструктуру. Количество API-интерфейсов будет только увеличиваться с течением времени.

Гениальная особенность API заключается в том, что многие из них представляют собой всего лишь крошечные фрагменты кода. Более того, все они спроектированы так, чтобы быть небольшими и незаметными с точки зрения их требований к сетевым ресурсам . Стоит отметить, что API также гибкие в использовании и способны продолжать работать и выполнять свои основные функции даже если программа, с которой они взаимодействуют, подвержена исправлениям и доработкам.

Какими бы замечательными ни были API, у них тоже есть свои недостатки. Поскольку они могут быть спроектированы практически для чего угодно (от повторения отдельных функций снова и снова до разумного управления важнейшими аспектами различных программ или платформ), их создание практически не регулируется никакими стандартами и нормами. Большинство API-интерфейсов уникальны – многие организации создают их новые версии по мере необходимости. Это может стать настоящим кошмаром для отдела безопасности фирмы.

Еще одна особенность, из-за которой API-интерфейсы привлекательны для злоумышленников, заключается в том, что многие из них имеют избыточные разрешения . Даже API, которые выполняют всего несколько функций, часто имеют привилегии администратора. Многие разработчики просто уверены в том, что такой крошечный API не сможет причинить никакого вреда. Хакеры компрометируют API-интерфейсы, а затем используют полученные учетные данные для достижения новых целей, таких как эксфильтрация данных или глубокое проникновение в сеть . Согласно исследованию в сфере ИБ-безопасности, проведенному Akamai , почти 75% современных атак на учетные данные были нацелены на уязвимые API.

Проблема только обостряется с годами. По данным Gartner , к 2022 году уязвимости, связанные с API, будут наиболее часто связаны с атаками во всех отраслях кибербезопасности.

Какие из этих 10+ лучших API для веб-сканирования в 2025 году будут наиболее эффективными в плане скорости и производительности

Инструменты оценки уязвимостей сканируют системы на наличие известных уязвимостей, неправильной конфигурации и других недостатков. Затем эти сканеры выдают отчеты для отделов ИТ-безопасности и управлений разработкой приложений (DevOps), которые передают приоритетные задачи для устранения недостатков.

Средства тестирования уязвимостей с открытым исходным кодом обеспечивают экономически эффективные решения для обнаружения уязвимостей. Многие ИТ-команды даже развертывают один или несколько инструментов с открытым исходным кодом в дополнение к коммерческим инструментам в качестве резервной копии или для проверки уязвимостей.

Сканеры уязвимостей веб-сайтов и приложений с открытым исходным кодом

В мире разработчики непрерывно создают сложные веб-сайты и приложения. Сканеры веб-сайтов и приложений (WebApp) тестируют код различными способами, чтобы выявить ошибки программирования и уязвимости до того, каксмогут их обнаружить.

Большинство инструментов обнаруживают распространенные, но критические уязвимости, перечисленные в, такие как SQL -инъекции ( SQL i) или межсайтовый скриптинг ( XSS ). Организации будут делать свой выбор на основе гибкости развертывания, скорости сканирования, точности сканирования и подключения к другим инструментам, таким как системы продажи билетов или продукты для программирования рабочего процесса. Однако, если стоимость лицензирования не является барьером, многие команды будут внедрять несколько инструментов с открытым исходным кодом одновременно.

OSV -Scanner – лучший сканер кода с открытым исходным кодом

OSV Scanner эффективно сканируют статическое программное обеспечение на предмет уязвимостей программного кода с открытым исходным кодом. Однако OSV , разработанный Google, берет информацию из базы данныхи работает во множестве различных экосистем.

Хотя OSV является новичком, он предоставляет более широкий спектр источников и уязвимостей и должен рассматриваться как замена или, по крайней мере, дополнительный инструмент сканирования с открытым исходным кодом для команд DevOps.

Ключевые особенности

- Сканирует программное обеспечение для поиска зависимостей и уязвимостей, которые их затрагивают

- Хранит информацию о затронутых версиях в JSON , машиночитаемом формате для интеграции с пакетами разработчика

- Сканирует каталоги, спецификации программного обеспечения ( SBOM ), lockfiles, образына базеили программное обеспечение, запущенное в контейнерах Docker.

Плюсы

- Извлекает уязвимости из огромного количества источников: Apine, Android, crates.io, Debian, Go, Linux, Maven, npm, NuGet, OSS -Fuzz, Packagist, PyPl, RubyGems и другие.

- Показывает сжатые результаты, что сокращает время, необходимое для устранения.

- Может игнорировать уязвимости по ID номеру.

- Все еще находится в активной разработке Google, поэтому будут добавлены новые функции

Минусы

- Находится в активной разработке, поэтому не хватает полных возможностей для интеграции рабочего процесса разработчика, уязвимостей C/C

sqlmap – Лучший для сканирования баз данных

Некоторые команды DevOp хотят просканировать внутреннюю базу данных, прежде чем использовтаь ее.позволяет проводить сканирование уязвимостей баз данных и тестирование на проникновение на широком спектре баз данных.