Top 10 Cloud-Based Web Scraping Tools and Services for 2025

- Top 10 Cloud-Based Web Scraping Tools and Services for 2025

- Связанные вопросы и ответы

- Что такое облачные инструменты веб-скрапинга

- Какие преимущества облачных инструментов веб-скрапинга

- Какие распространенные инструменты веб-скрапинга будут доступны в 2025 году

- Какие факторы следует учитывать при выборе облачного инструмента веб-скрапинга

- Какие отличия между облачными и локальными инструментами веб-скрапинга

- Какие задачи можно решить с помощью облачных инструментов веб-скрапинга

Top 10 Cloud-Based Web Scraping Tools and Services for 2025

Web scraping is the process of extracting data from websites. It is a powerful tool for businesses, researchers, and individuals who need to gather information from the web. In recent years, cloud-based web scraping tools and services have become increasingly popular due to their ease of use, scalability, and cost-effectiveness. In this article, we will explore the top 10 cloud-based web scraping tools and services for 2025.

Importance of Web Scraping

Web scraping is important for businesses, researchers, and individuals who need to gather information from the web. It allows them to extract data from websites quickly and efficiently, without having to manually copy and paste information. Web scraping can be used for a variety of purposes, including market research, price monitoring, lead generation, and data analysis.

Top 10 Cloud-Based Web Scraping Tools and Services for 2025

1. ScrapingBee - ScrapingBee is a cloud-based web scraping service that allows users to extract data from websites without having to write any code. It offers a user-friendly interface and supports JavaScript rendering, making it ideal for scraping dynamic websites.

2. Scrapy Cloud - Scrapy Cloud is a cloud-based web scraping platform that allows users to run and manage their Scrapy spiders in the cloud. It offers a scalable infrastructure and real-time monitoring, making it ideal for large-scale web scraping projects.

3. ParseHub - ParseHub is a cloud-based web scraping tool that allows users to extract data from websites without having to write any code. It offers a user-friendly interface and supports JavaScript rendering, making it ideal for scraping dynamic websites.

4. Octoparse - Octoparse is a cloud-based web scraping tool that allows users to extract data from websites without having to write any code. It offers a user-friendly interface and supports JavaScript rendering, making it ideal for scraping dynamic websites.

5. Diffbot - Diffbot is a cloud-based web scraping service that allows users to extract data from websites without having to write any code. It offers a user-friendly interface and supports JavaScript rendering, making it ideal for scraping dynamic websites.

6. Import.io - Import.io is a cloud-based web scraping tool that allows users to extract data from websites without having to write any code. It offers a user-friendly interface and supports JavaScript rendering, making it ideal for scraping dynamic websites.

7. Webhose.io - Webhose.io is a cloud-based web scraping service that allows users to extract data from websites without having to write any code. It offers a user-friendly interface and supports JavaScript rendering, making it ideal for scraping dynamic websites.

8. Apify - Apify is a cloud-based web scraping platform that allows users to run and manage their web scraping tasks in the cloud. It offers a scalable infrastructure and real-time monitoring, making it ideal for large-scale web scraping projects.

9. Data Miner - Data Miner is a cloud-based web scraping tool that allows users to extract data from websites without having to write any code. It offers a user-friendly interface and supports JavaScript rendering, making it ideal for scraping dynamic websites.

10. Outwit Hub - Outwit Hub is a cloud-based web scraping tool that allows users to extract data from websites without having to write any code. It offers a user-friendly interface and supports JavaScript rendering, making it ideal for scraping dynamic websites.

Conclusion

In conclusion, cloud-based web scraping tools and services offer a powerful and cost-effective way to extract data from websites. The top 10 cloud-based web scraping tools and services for 2025 include ScrapingBee, Scrapy Cloud, ParseHub, Octoparse, Diffbot, Import.io, Webhose.io, Apify, Data Miner, and Outwit Hub. These tools and services offer a user-friendly interface, support JavaScript rendering, and are ideal for scraping dynamic websites.

Связанные вопросы и ответы:

1. Что такое облачный веб-скрапер

Облачный веб-скрапер - это инструмент, который используется для извлечения данных из веб-сайтов. Он работает на облачной платформе, что означает, что он не требует установки на локальном компьютере пользователя. Облачные веб-скраперы обычно предоставляются в качестве услуг и могут быть доступны через веб-интерфейс или API.

2. Какие преимущества облачных веб-скраперов

Преимущества облачных веб-скраперов включают возможность извлечения большого объема данных без необходимости установки программного обеспечения на локальном компьютере, а также возможность извлечения данных из веб-сайтов, которые могут быть защищены от скрапинга. Облачные веб-скраперы также обычно предоставляются в качестве услуг, что означает, что пользователю не нужно беспокоиться о обслуживании и обновлении программного обеспечения.

3. Какие ограничения облачных веб-скраперов

Ограничения облачных веб-скраперов включают зависимость от интернета, что означает, что если пользователь не имеет доступа к интернету, он не сможет использовать облачный веб-скрапер. Облачные веб-скраперы также могут быть более дорогими, чем локальные веб-скраперы, и могут быть ограничены в функциональности, по сравнению с локальными веб-скраперами.

4. Какие факторы следует учитывать при выборе облачного веб-скрапера

При выборе облачного веб-скрапера следует учитывать такие факторы, как стоимость, функциональность, скорость и надежность. Пользователь также должен учитывать, какие сайты он планирует извлекать данные из, и выбирать облачный веб-скрапер, который может эффективно извлекать данные из этих сайтов.

5. Какие 10 лучших облачных веб-скраперов и услуг в 2025 году

Список лучших облачных веб-скраперов и услуг в 2025 году может включать такие инструменты, как ParseHub, Octoparse, ScrapingBee, Scrapy Cloud, Diffbot, Apify, Import.io, Webhose.io, Kimono Labs и Datahut.

6. Какие проблемы могут возникнуть при использовании облачных веб-скраперов

При использовании облачных веб-скраперов могут возникнуть такие проблемы, как ограничения на количество данных, которые можно извлечь, ограничения на скорость извлечения данных, ограничения на количество запросов, которые можно отправить, и ограничения на количество сайтов, которые можно извлекать данные из. Облачные веб-скраперы также могут быть более дорогими, чем локальные веб-скраперы, и могут быть ограничены в функциональности, по сравнению с локальными веб-скраперами.

Что такое облачные инструменты веб-скрапинга

Instant Data Scraper - это бесценный инструмент для тех, кто хочет эффективно извлекать данные с веб-страниц. Вот как можно использовать это удобное расширение для Chrome:

a. Установка .

- Перейдите в Chrome Web Store и найдите "Мгновенный скребок данных" от webrobots.io.

- Нажмите кнопку "Добавить в Chrome", чтобы установить расширение. Вы увидите подтверждение о том, что расширение может считывать и изменять все ваши данные на всех сайтах, что необходимо для целей скраппинга.

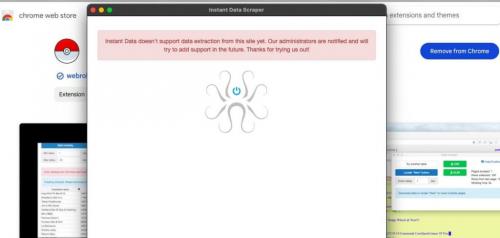

Фото: Instant Data Scraper

b. Запуск расширения .

- После установки вы найдете значок расширения на панели инструментов вашего браузера - его символизирует красный значок "Покебол" (1). Закрепите его, чтобы иметь удобный доступ.

- Посетите веб-страницу, с которой вы хотите произвести поиск. Например, если вы хотите получить данные из каталога блогов, перейдите на страницу, где отображаются объявления (2).

c. Использование прокси-серверов .

- Прежде чем приступать к скреперу, подумайте об использовании надежных прокси-серверов, таких как.или HTTP-прокси могут быть полезны для обхода ограничений или запретов на основе IP-адреса. Прокси-серверы повысят эффективность и возможности сбора данных.

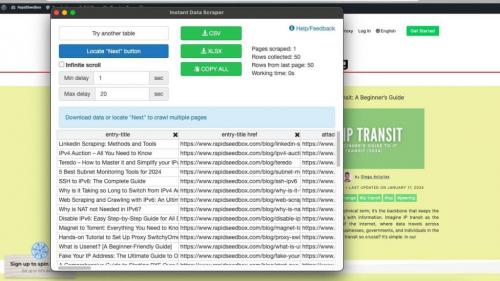

d. Запуск скребка .

- Щелкните на значке Instant Data Scraper, чтобы активировать расширение. Оно проанализирует страницу и попытается автоматически определить таблицу данных.

Фото: Instant Data Scraper

- Если данные структурированы в табличном формате, инструмент, скорее всего, сразу определит их. Если нет, вам может потребоваться направить инструмент, выбрав опцию "Попробовать другую таблицу".

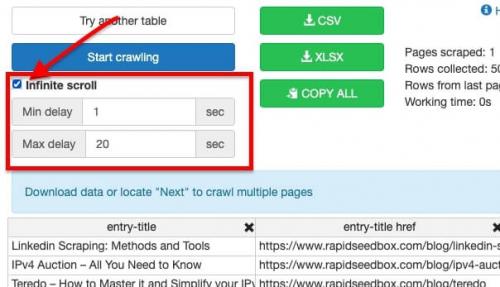

e. Настройка параметров .

- Для страниц, которые требуют прокрутки для загрузки большего количества элементов (бесконечная прокрутка), можно установить флажок "Бесконечная прокрутка", чтобы скребок собирал все данные по мере прокрутки вниз.

- Настройте параметры "Минимальная задержка" и "Максимальная задержка" в зависимости от того, как быстро загружается страница и как быстро вы хотите получить данные. Эти настройки помогают управлять скоростью сканирования, чтобы не перегружать сервер.

Фото: Instant Data Scraper

f. Навигация по страницам .

- Если данные охватывают несколько страниц, нажмите на кнопку "Найти кнопку "Далее"". Это позволит расширению понять, какую кнопку нужно нажать, чтобы перейти к следующей странице результатов.

- После настройки вы можете запустить скрепер, нажав кнопку 'Start crawling'. Расширение будет автоматически перемещаться по страницам, собирая данные.

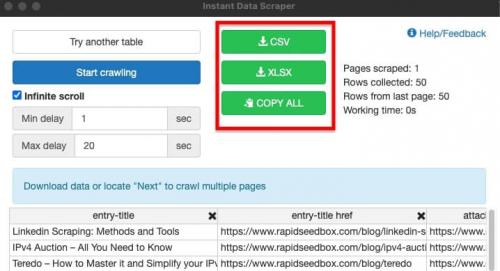

g. Экспорт данных .

- После того как скрепер соберет данные, вы можете экспортировать их, нажав на кнопки CSV или XLSX, в зависимости от предпочитаемого формата.

- Если вы хотите скопировать данные непосредственно в другое приложение, воспользуйтесь кнопкой "COPY ALL", а затем вставьте данные в нужное место.

Фото: Instant Data Scraper

h. Очистка и использование данных .

- После экспорта данных вам может потребоваться очистить их, удалив ненужные столбцы или строки. Это можно легко сделать в программе для работы с электронными таблицами, например Excel или Google Sheets.

- Очистив данные, вы можете анализировать их, вводить в CRM или использовать для маркетинговых исследований, генерации лидов или любых других целей, которые вы задумали.

Помните, что Instant Data Scraper - мощный инструмент, но он не поддерживает извлечение данных со всех сайтов, поскольку некоторые из них имеют защиту от скрапинга. В таких случаях инструмент сообщит вам, что сайт не поддерживается.

Какие преимущества облачных инструментов веб-скрапинга

Веб-скрапинг с использованием ИИ имеет ряд существенных преимуществ – о главных из них мы расскажем далее.

1. Эффективность и скорость

скраперы на базе ИИ обрабатывают большие объемы данных намного быстрее, чем люди. Они могут собирать информацию с нескольких страниц одновременно с высокой скоростью и без ошибок. Такая скорость – важнейшее преимущество для компаний, которым требуются данные в режиме реального времени.

2. Адаптивное обучение

ИИ-скраперы отличаются от традиционных тем, что им не нужны частые обновления, чтобы адаптироваться к изменениям в макетах веб-сайтов или типах контента. Вместо этого они сами учатся на прошлом опыте. Эта особенность позволяет им автоматически адаптироваться к новым структурам и форматам и уменьшает необходимость в постоянном обслуживании.

3. Сбор данных в режиме реального времени

Веб-скраперы на базе ИИ могут непрерывно собирать данные и, тем самым, предоставлять самую актуальную информацию. Эта функция особенно актуальна в таких отраслях, как e-commerce или финансы, где рыночные условия быстро меняются.

4. Качество и точность данных

Скраперы, управляемые ИИ, значительно повышают качество и точность собранных данных. Отфильтровывая ненужную информацию, ИИ снижает уровень информационного “шума” и позволяет получать только корректные и релевантные данные. Эта точность уменьшает вероятность ошибки на всех этапах сбора данных – от их извлечения до анализа.

Какие распространенные инструменты веб-скрапинга будут доступны в 2025 году

Во время анализа инструментов веб-скрапинга я добавилв мой список, потому что он легко заполняет пробел между простыми потребностями в скрапинге и сложными задачами по извлечению данных. Его готовые инструменты значительно сокращают время разработки.

Apify это продвинутый инструмент, который без усилий помог мне подключиться к таким платформам, как Zapier, Keboola и RESTful API. Он предлагает такие функции, как ротация IP и CAPTCЯзыки поддержки HA-решения, такие как Selenium и Python. Благодаря интеграции API Google Sheets и общим IP-адресам центров обработки данных пользователям предоставляется множество функций: от корпоративных решений до пользовательских вариантов хранения данных.

Преимущества:

- Управление сетью: Apifyобеспечивает поддержку HTTPS, геолокационное таргетирование и интеллектуальную ротацию IP. Это улучшило мою способность эффективно управлять сетевым трафиком.

- Парсинг страницы поисковой выдачи: Прокси-серверы Google SERP улучшили мои возможности по скрапингу страниц результатов поисковой системы. В результате я смог собирать данные из поисковых систем более точно.

- Бесплатные вызовы API: Apify наградили меня 1000 бесплатными вызовами API после регистрации. Я нашел это отличным способом начать работу с их услугами веб-скрейпинга без первоначальных затрат.

- Гибкость парсинга веб-страниц: Позволяет извлекать из Amazon, schema.org и теги. На практике этот подход доказал мне гибкость в удалении широкого спектра веб-контента и типов данных.

- Расширенное извлечение данных: Apify включает расширенные функции извлечения данных, такие как CSS-селектор, ротация IP-адресов, геолокация, CAPTCРешение HA и Javascript Рендеринг. Используя эти функции, я мог легко управлять своими сложными потребностями в скрапинге.

- Поддержка платформы: Apify совместим с различными веб-платформами, предлагая поддержку различных инструментов и сервисов. В результате я мог бы разумно интегрировать его в несколько рабочих процессов.

Какие факторы следует учитывать при выборе облачного инструмента веб-скрапинга

В современном мире данных API играет важную роль в обеспечении эффективного и структурированного доступа к информации. В отличие от веб-скрапинга, который подразумевает извлечение данных напрямую со страниц сайтов, API предоставляет разработчикам стандартизированный интерфейс для получения данных. Это не только упрощает процесс интеграции, но и снижает риск нарушения авторских прав или условий использования веб-ресурсов.

Использование API позволяет разработчикам получать доступ к актуальной и точной информации в режиме реального времени. Например, при работе с данными о погоде, финансовых рынках или социальных сетях, API обеспечивает надежный поток данных, который можно легко интегрировать в приложения или аналитические системы. Вот несколько распространенных сценариев использования API:

- Автоматическое обновление данных о товарах в интернет-магазинах

- Интеграция социальных медиа для отслеживания упоминаний бренда

- Сбор финансовой информации для анализа рынка

- Получение последних новостей и публикаций для агрегаторов контента

| Метод | Преимущества | Недостатки |

|---|---|---|

| API | Структурированные данные, легкая интеграция, меньше юридических рисков | Может быть платным, ограничения по количеству запросов |

| Веб-скрапинг | Доступ к данным без ограничений API | Трудоемкий, юридические риски, нестабильность |

Таким образом, выбор между API и веб-скрапингом зависит от конкретных потребностей проекта, доступности данных и ресурсов на их обработку. API является предпочтительным вариантом для долгосрочных и устойчивых решений, где важна надежность и соответствие законодательству.

Какие отличия между облачными и локальными инструментами веб-скрапинга

Компания Bright Data занимает лидирующие позиции в индустрии сбора веб-данных, управляя обширной и разнообразной сетью прокси-серверов по всему миру. Сеть компании насчитывает миллионы резидентных прокси-серверов , которые идеально подходят для реализации стратегий ротации IP-адресов, необходимых для эффективного веб-парсинга.

На базе этой инфраструктуры Bright Data предлагает множество инструментов и служб веб-парсинга, включая API для Web Scraper. Этот облачный инструмент позволяет получить доступ к настраиваемым конечным точкам API, предназначенным для извлечения веб-данных из популярных доменов и отвечающим сложным потребностям проектов по сбору данных.

API для Web Scraper разработаны для обеспечения масштабируемости и надежности и устранения распространенных технических препятствий, возникающих при веб-парсинге, таких как преодоление антибот-механизмов.

Поэтому такие API становятся предпочтительным решением для сбора данных для организаций, которые стремятся усовершенствовать свои инициативы, основанные на данных. При этом они снижают эксплуатационные расходы и повышают эффективность сбора данных в Интернете.

- Ротация IP-адресов через прокси-серверы

- Автоматическое решение капчей

- Ротация пользовательских агентов

- Возможности рендеринга JavaScript

- Экспорт данных в удобочитаемые форматы

Другими словами, Scraper API предлагает наибольшее количество возможностей из числа других лучших инструментов веб-парсинга в рамках одной службы. Это делает его идеальным решением для обхода проблем парсинга, снижения общих затрат и экономии времени.

Плюсы :

- Время безотказной работы: 99,9%

- Неограниченное масштабирование

- На 100% соответствует требованиям и этике

- Поддержка людьми 24/7

Минусы :

- Не бесплатный

Стоимость :

Цены зависят от количества записей и типа домена. От 0,001 $.

Доступна бесплатная пробная версия.

Какие задачи можно решить с помощью облачных инструментов веб-скрапинга

Кибардин Тимофей Николаевич – магистрант Казанского национального исследовательского технического университета им. А.Н. Туполева

Аннотация: В статье рассмотрен веб-скрейпинг, что это такое и какие задачи могут быть решены с помощью этой технологии. Проведена классификация видов веб-скрейперов, а также упомянуты инструменты, с помощью которых можно реализовать в программах логику веб-скрейпинга. Затрагиваются этический и правовой аспекты использования веб-скрейпинга, представлен случай незаконного использования веб-скрейпинга. Рассмотрены основные области применения веб-скрейпинга.

Ключевые слова: веб-скрейпинг, Интернет, мониторинг, область применения, инструмент.

Веб-скрейпинг (web-scraping) – это технология автоматического сбора данных из интернета, обычно с помощью специализированных программ или алгоритмов, которые извлекают информацию со страниц веб-ресурсов, анализируют её и преобразуют полученную информацию в нужный формат. Хотя собирать информацию с веб-страниц можно вручную, в большинстве случаев используются автоматизированные инструменты.

Веб-скрейпинг стал важным инструментом для автоматизированного сбора информации в Интернете . С помощью этой технологии решаются следующие задачи:

- Поиск нужной информации;

- Копирование, агрегация данных из Интернета;

- Мониторинг обновлений информации на веб-сайтах.

Рассмотрим несколько типов веб-скрейперов:

- Самостоятельно созданные веб-скрейперы . Подобно тому, как каждый может создать веб-сайт, каждый может создать свой собственный веб-скрейпер. Однако инструменты, доступные для создания собственного веб-скрепера, все же требуют некоторые знания в области программирования. Объем требуемых знаний увеличивается с расширением функционала скрейпера .

- Браузерные расширения . Веб-скрейперы в виде браузерных расширений имеют преимущество за счет того, что их проще запускать и интегрировать прямо в браузер. Однако такие расширения обычно ограничены только браузером. Это означает, что любые дополнительные функции, которые должны быть реализованы вне браузера, реализовать невозможно .

- С пользовательским интерфейсом . Пользовательский интерфейс разных веб-скреперов может сильно отличаться. Например, некоторые инструменты для веб-скрейпинга работают с минимальным пользовательским интерфейсом и командной строкой. Другие наоборот – имеют полноценный пользовательский интерфейс. С такими веб-скрейперами обычно проще работать людям с ограниченными техническими знаниями .

- Облачные веб-скрейперы . Работают на внешнем сервере, который обычно предоставляет компания, разработавшая сам скрейпер. Это означает, что ресурсы вашего компьютера не задействуются, пока скрейпер работает и собирает данные . Как правило, доступ к подобным скрейперам не бесплатный.

- Локальные веб-скрейперы . Работают на компьютере пользователя, используя его ресурсы и интернет-соединение. Это означает, что, если веб-скрейпер сильно загружает процессор или оперативную память, компьютер может работать довольно медленно, пока выполняется процесс скрейпинга . Как правило, локально запускаются самостоятельно созданные веб-скрейперы.