Maximizing Your Web Scraping Efficiency with Python Proxy Setup

- Maximizing Your Web Scraping Efficiency with Python Proxy Setup

- Связанные вопросы и ответы

- Что такое прокси-сервер и как он может помочь при веб-скрейпинге

- Какие есть типы прокси-серверов и какой лучше использовать для веб-скрейпинга

- Как установить прокси-сервер в Python для веб-скрейпинга

- Как настроить прокси-сервер в Python для работы с определенным сайтом

- Как избежать блокировки при использовании прокси-сервера для веб-скрейпинга

- Как определить, что прокси-сервер не работает и как его исправить

- Как изменить прокси-сервер в Python, если он не работает

- Как использовать несколько прокси-серверов для веб-скрейпинга

- Как избежать ограничений при использовании прокси-серверов для веб-скрейпинга

Maximizing Your Web Scraping Efficiency with Python Proxy Setup

Web scraping is the process of extracting data from websites. It is a powerful tool that can be used for a variety of purposes, such as data analysis, market research, and lead generation. However, web scraping can also be a challenging task, especially when dealing with websites that have complex structures or that are protected by anti-scraping measures.

One way to overcome these challenges is to use a proxy setup in your Python web scraping code. A proxy is a server that acts as an intermediary between your computer and the website you are trying to scrape. By using a proxy, you can hide your IP address and make it appear as if you are accessing the website from a different location. This can help you bypass anti-scraping measures and improve the efficiency of your web scraping efforts.

In this article, we will discuss how to set up a proxy in Python and how to use it to maximize your web scraping efficiency.

Setting Up a Proxy in Python

To set up a proxy in Python, you will need to use the `requests` library. The `requests` library is a popular library for making HTTP requests in Python. It is easy to use and has a simple API.

To install the `requests` library, you can use the following command:

```

pip install requests

```

Once you have installed the `requests` library, you can use it to make HTTP requests with a proxy. Here is an example of how to do this:

```python

import requests

proxies = {

"http": "http://username:password@proxy_address:proxy_port",

"https": "https://username:password@proxy_address:proxy_port"

}

response = requests.get("http://example.com", proxies=proxies)

```

In this example, we are making an HTTP GET request to the website `http://example.com` using a proxy. The proxy is specified in the `proxies` dictionary. The keys in the dictionary are the HTTP and HTTPS protocols, and the values are the proxy addresses.

The proxy address is in the format `username:password@proxy_address:proxy_port`. The `username` and `password` are the credentials for the proxy server. The `proxy_address` is the IP address of the proxy server, and the `proxy_port` is the port number that the proxy server is listening on.

Using a Proxy to Maximize Web Scraping Efficiency

Now that you know how to set up a proxy in Python, let's discuss how to use it to maximize your web scraping efficiency.

One way to use a proxy to improve your web scraping efficiency is to rotate your IP address. This means that you will use a different IP address for each request you make to the website. This can help you avoid being blocked by the website's anti-scraping measures.

To rotate your IP address, you can use a proxy pool. A proxy pool is a collection of proxy servers that you can use to make your HTTP requests. You can use a different proxy server for each request you make to the website.

Here is an example of how to use a proxy pool to rotate your IP address:

```python

import requests

proxy_pool = [

{"http": "http://username1:password1@proxy_address1:proxy_port1", "https": "https://username1:password1@proxy_address1:proxy_port1"},

{"http": "http://username2:password2@proxy_address2:proxy_port2", "https": "https://username2:password2@proxy_address2:proxy_port2"},

{"http": "http://username3:password3@proxy_address3:proxy_port3", "https": "https://username3:password3@proxy_address3:proxy_port3"}

]

for proxy in proxy_pool:

response = requests.get("http://example.com", proxies=proxy)

```

In this example, we are using a proxy pool with three proxy servers. We are using a different proxy server for each request we make to the website.

Another way to use a proxy to improve your web scraping efficiency is to use a headless browser. A headless browser is a web browser that runs in the background and does not have a graphical user interface. This can help you avoid being detected by the website's anti-scraping measures.

To use a headless browser with a proxy, you can use the `selenium` library. The `selenium` library is a popular library for automating web browsers in Python. It is easy to use and has a simple API.

To install the `selenium` library, you can use the following command:

```

pip install selenium

```

Once you have installed the `selenium` library, you can use it to automate a web browser with a proxy. Here is an example of how to do this:

```python

from selenium import webdriver

proxies = {

"http": "http://username:password@proxy_address:proxy_port",

"https": "https://username:password@proxy_address:proxy_port"

}

options = webdriver.ChromeOptions()

options.add_argument("--headless")

options.add_argument("--proxy-server=%s" % proxies["http"])

driver = webdriver.Chrome(options=options)

driver.get("http://example.com")

```

In this example, we are using the `selenium` library to automate a Chrome web browser with a proxy. The proxy is specified in the `proxies` dictionary. The `options` dictionary is used to specify the options for the web browser. The `--headless` option is used to run the web browser in the background, and the `--proxy-server` option is used to specify the proxy server.

Conclusion

In this article, we have discussed how to set up a proxy in Python and how to use it to maximize your web scraping efficiency. We have also discussed how to use a proxy pool to rotate your IP address and how to use a headless browser with a proxy. By using these techniques, you can improve the efficiency of your web scraping efforts and overcome the challenges of dealing with websites that have complex structures or that are protected by anti-scraping measures.

Связанные вопросы и ответы:

Вопрос 1: Что такое прокси-сервер и для чего он нужен при веб-скрейпинге

Прокси-сервер - это специальный сервер, который выступает посредником между клиентом и источником информации. При веб-скрейпинге прокси-сервер позволяет скрыть свой IP-адрес и обходить ограничения на доступ к веб-сайтам.

Вопрос 2: Какие есть типы прокси-серверов

Существует несколько типов прокси-серверов: HTTP, HTTPS, SOCKS4, SOCKS5. HTTP и HTTPS прокси-серверы используются для передачи HTTP-запросов и ответов, в то время как SOCKS4 и SOCKS5 прокси-серверы могут передавать любые типы данных, включая TCP и UDP.

Вопрос 3: Как установить прокси-сервер в Python

Для установки прокси-сервера в Python можно использовать библиотеку requests. Для этого необходимо установить библиотеку requests и импортировать ее в программу. Затем можно использовать функцию requests.get() или requests.post() с параметром proxies, указывающим на прокси-сервер.

Вопрос 4: Как узнать свой IP-адрес

Чтобы узнать свой IP-адрес, можно воспользоваться различными онлайн-сервисами, такими как whatismyip.com или ifconfig.me. Также можно узнать свой IP-адрес, используя команду в терминале: ipconfig (для Windows) или ifconfig (для Linux).

Вопрос 5: Как избежать блокировки при веб-скрейпинге

Чтобы избежать блокировки при веб-скрейпинге, можно использовать несколько прокси-серверов и менять их периодически. Также можно использовать библиотеки, которые имитируют поведение браузера, например, Selenium.

Вопрос 6: Как использовать прокси-сервер в библиотеке BeautifulSoup

Для использования прокси-сервера в библиотеке BeautifulSoup необходимо установить библиотеку requests и использовать ее для получения страницы с помощью прокси-сервера. Затем можно использовать библиотеку BeautifulSoup для парсинга страницы.

Вопрос 7: Как узнать, работает ли прокси-сервер

Чтобы узнать, работает ли прокси-сервер, можно отправить запрос на какой-либо сайт и проверить, пришел ли ответ. Если ответ пришел, значит прокси-сервер работает. Также можно использовать онлайн-сервисы для проверки прокси-серверов, такие как proxycheck.io.

Что такое прокси-сервер и как он может помочь при веб-скрейпинге

Веб-скрейпинг

Веб-скрейпинг – это сбор данных с различных сайтов, таких как Google, LinkedIn , для выполнения определенных целей, таких как исследование рынка конкурентов, выбор ценовой стратегии. Если пользователь попытается постоянно выходить из сети, используя свой реальный IP-адрес, многие сайты сочтут подобное поведение подозрительным и заблокирует ему доступ. Однако, используя резидентные прокси-серверы, человек не будет переживать по этому поводу – сайты не станут блокировать его IP.

Исследование рынка

Следить за тенденциями рынка и действиями конкурентов крайне важно для того, чтобы оставаться на плаву. Использование прокси-сервера позволяет выработать оптимизированную маркетинговую стратегию в соответствии с проведенным исследованием и полученными данными. Маркетологи могут использовать прокси для проверки контента и оценки рекламы конкурентов. Это поможет улучшить собственные маркетинговые стратегии.

Мониторинг цен

Хорошая ценовая стратегия необходима для того, чтобы убедиться, что компания не завышает цены на свои продукты и услуги. Если цена слишком высока, это отпугнет клиентов, а если она слишком занижена – даст людям повод усомниться в качестве представленного на продажу. Использование резидентных прокси-серверов позволяет проводить тщательный мониторинг, анализ и сравнение цен.

Изучение глобальной сети

Прокси-серверы помогают изучать возможности Интернета, и если пользователь делает это, используя свой реальный IP-адрес, он может быть заблокирован. Главная проблема заключается в том, что человек должен быть уверен, что полученная им информация является точной. Для этого следует использовать резидентные прокси, они помогут оставаться анонимным и продолжить свое исследование до достижения поставленных целей.

SEO

Поисковая оптимизация ( SEO ) необходима для поднятия позиций сайта в результатах выдачи поисковых систем по определённым запросам. Использование прокси-серверов позволяет проводить SEO-анализ, например, по ключевым словам, на которые ориентируются конкуренты, источники трафика и ссылки. С помощью SEO можно добавить на свой ресурс ссылки на другие авторитетные источники и перевести имеющийся контент на иностранные языки.

Социальные сети

Оставаться активным в социальных сетях и использовать различные платформы чрезвычайно важно для любого бизнеса. Можно задействовать прокси-серверы для создания учетных записей на различных платформах и легко управлять ими.

Защита бренда

Используя резидентный прокси, пользователь может увидеть, как выглядит его сайт в других местах и странах. Это поможет оптимизировать ресурс на основе полученного пользовательского опыта. Кроме того, есть вероятность обнаружить подозрительную активность или нарушение интеллектуальной собственности, чтобы защитить репутацию бренда.

Какие есть типы прокси-серверов и какой лучше использовать для веб-скрейпинга

Существует четыре типа прокси-серверов для веб-скреппинга:

1. Прокси для центров обработки данных: Эти прокси поступают от провайдеров облачных услуг и иногда отмечаются, потому что многие люди используют их, но поскольку они дешевле, пулы прокси могут использоваться для веб-скрапинга.

2. Резидентные IP-прокси: Эти прокси содержат IP-адрес местного интернет-провайдера, поэтому администратор сайта не может определить, кто просматривает сайт - скрепер или реальный человек. Они стоят дороже, чем прокси в дата-центрах, и могут повлечь за собой судебные разбирательства, поскольку владелец сайта не знает, что вы используете его IP для целей веб-скрапинга.

3. Мобильные IP-прокси: Мобильные IP назначаются провайдерами мобильных услуг (например, 4G и т. д.), и поскольку они динамически назначаются всем, кто находится рядом с сотовой вышкой, они не привязаны к одному человеку, что означает низкий риск блокировки или принудительного прохождения CAPTCHA, но они обычно дороги.

4. Прокси-провайдер: Его также называют статическим прокси для жилых домов, который размещается на сервере, расположенном в центре обработки данных, и используется для идентификации реальных пользователей. Прокси провайдера могут быть комбинацией прокси центра обработки данных и жилых прокси.

Примечания: Резидентные прокси лучше всего подходят для веб-скрапинга, так как они принадлежат надежным ASN (например, публичным интернет-провайдерам), поэтому соединения, созданные с этих IP-адресов, более надежны.

Как установить прокси-сервер в Python для веб-скрейпинга

Чтобы создать парсер Python, вам необходимы:

- Python 3.4+

- pip (менеджер пакетов)

Обратите внимание, что pip по умолчанию включен в состав Python версии 3.4 и выше. Поэтому устанавливать его вручную не требуется. Если на вашем компьютере нет Python, следуйте приведенному ниже руководству для вашей операционной системы

macOS

Раньше компьютеры Mac поставлялись с предустановленным Python 2.7, но теперь это уже не так, поскольку эта версия устарела.

Если вам нужна последняя версия Python, ее необходимо установить вручную. Для этого загрузите программу установки , дважды щелкните по ней, чтобы запустить, и следуйте указаниям мастера установки.

Windows

Загрузите программу установки Python и запустите ее. Во время работы мастера установки убедитесь, что отмечен флажок «Добавить python.exe в PATH», как показано ниже:

Окно установки Python для Windows

Таким образом, Windows будет автоматически распознавать команды python и pip в терминале. Напомним, что pip — менеджер пакетов для Python.

Linux

В большинстве дистрибутивов Linux Python уже предустановлен, однако речь может идти не о самой последней версии. Команда для установки или обновления Python в Linux зависит от менеджера пакетов. В дистрибутивах Linux на базе Debian выполните команду:

sudo apt-get install python3

Независимо от используемой ОС, откройте терминал и убедитесь, что Python успешно установлен:

python --version

В результате должно получиться что-то вроде этого:

Python 3.11.0

Теперь все готово для создания вашего первого парсера Python. Но сначала вам нужна библиотека веб-скрапинга Python!

Как настроить прокси-сервер в Python для работы с определенным сайтом

Есть несколько способов установить прокси в Requests Python. В этой статье вы рассмотрите 3 разных сценария. В первом примере вы узнаете, как устанавливать прокси прямо в модуле запросов.

To start, you need to import the Requests and Beautiful Soup packages in your Python file for web scraping. Then create a directory calledproxiesthat contains proxy server information to hide your IP address when scraping the web page. Here, you have to define both the HTTP and HTTPS connections to the proxy URL.

You also need to define the Python variable to set the URL of the web page you want to scrape the data from. For this tutorial, the URL is https://brightdata.com/

Next, you need to send a GET request to the web page using therequest.get()method. The method takes two arguments: the URL of the website and proxies. Then the response from the web page is stored in theresponsevariable.

response.contentandhtml.parseras arguments to theBeautifulSoup()method.Then use thefind_all()method withaas an argument to find all the links on the web page. Finally, extract thehrefattribute of each link using theget()method.

Как избежать блокировки при использовании прокси-сервера для веб-скрейпинга

Все устройства, когда подключаются к Интернету, обязательно получают уникальный идентификатор – это IP-адрес. О том, что это такое и как он назначается, мы рассказывали в статье про динамические IP-адреса и про то, как скрыть свой IP-адрес . Если коротко, то IP-адреса всегда закрепляются за компаниями: локальными или региональными регистраторами. «Потерять» IP невозможно, они все на учёте. Исключение составляют специальные локальные IP-адреса, предназначенные для построения внутренних сетей, но с их помощью нельзя подключиться к глобальной сети.

Так как избежать блокировки IP-адреса при парсинге? Делимся советами.

Совет 1. Читайте правила сайта и соблюдайте их

Крупные ресурсы могут оговаривать нагрузку на сервер в правилах использования. Это большая редкость, но практика такая имеется. Основная сложность заключается в том, что пользователь не может посчитать нагрузку, которую он создаёт на сервер, соответственно, ему невозможно понять вписывается он в лимиты или нет.

Обычно оговариваются «нормальная» работа пользователя. И всё, что не попадает под это описание, может блокироваться.

Параллельно с общими и юридическими документами, оговаривающими целевое использование интернет-ресурса, а также могут применяться чисто технические документы. Например, это могут быть xml-карты (здесь собираются ссылки на страницы, подлежащие индексированию, то есть обходу поисковыми роботами) или файл robots.txt (тут указываются правила обхода страниц и запреты). Обязательно нужно изучить директивы из robots.txt и соблюдать их. Не стоит пытаться парсить разделы, которые явно запрещены для обхода роботами с помощью специальных директив.

Попытка нарушения легко может привести к бану.

Совет 2. Используйте доступ к API, если он есть

Самые крупные площадки знают, что бизнес-аудитории часто требуется доступ к определённым данным. И чтобы снизить нагрузку на основную версию сайта (ту, что открывают обычные пользователи), владельцы ресурса организуют программный интерфейс – API.

С помощью API можно существенно автоматизировать процесс сбора данных, так как информация предоставляется сервисом в готовом виде (с разметкой). Вы можете запрашивать что-то конкретное: отдельные страницы, списки страниц, срезы, статистику и прочее. Все возможности программных интерфейсов описываются в документации и зависят от конкретного ресурса (техническую составляющую определяют владельцы сайта).

Доступ к API-интерфейсу осуществляется на основе ключа, одновременно выступающим идентификатором и элементом защиты.

Но у API могут быть свои лимиты и ограничения. Обязательно изучите их и соблюдайте.

Что хотелось бы выделить особенно: даже если вы «случайно» превысите лимиты запросов по IP, то скорее всего никакого бана не получите. Максимум – система будет выдавать ошибку в ответ на ваши запросы. Когда лимиты обнулятся (восстановятся), доступ к данным снова восстановится.

Обойти ограничения API будет сложнее, так как система не привязывается к вашим IP-адресам, она ориентируется на ваш API-ключ.

Совет 3. Выставляйте разные промежутки времени между запросами

Самый первый параметр, по которому вычленяются боты и парсеры – это одинаковые промежутки времени между запросами. И дело даже не в том, какое значение задаётся, одна секунда или пять минут. Вычленяется именно сама закономерность.

Если ваш парсер не умеет рандомизировать время между запросами, это нужно обязательно исправить (или нужно полностью сменить парсер).

Совет 4. Минимизируйте нагрузку на целевой сайт

Не стоит отправлять запросы слишком часто. Чем больше запросов поступает с одного IP, тем выше внимание к нему со стороны систем защиты. Реальные пользователи физически не смогут открывать по 100 страниц за секунду.

Если хотите ускорить процесс сбора – распараллеливайте экземпляры парсеров. Не нужно сокращать время между запросами с одного IP.

Тут важно помнить, что у каждого экземпляра парсера должен быть свой IP-адрес. Только в этом случае сбор данных может осуществляться параллельно.

Параллельные потоки запросов с одного IP – это большая проблема. Скорее всего ваш парсер быстро заблокируют.

Совет 5. Выявляйте и обходите ловушки для ботов

Как можно гарантированно выявить автоматический трафик и ботов? Легко: достаточно вставить на уровне HTML-кода специальную ссылку или форму, которую скрывают для отображения с помощью CSS-стилей.

Итог такой: бот или парсер при обходе видит эту ссылку, так как она есть в коде (у бота нет реального зрения, он читает код, как обычные данные из потока), и переходит по ней.

Пользователь перейти по такой ссылке не может, так как браузер не показывает её на странице.

Соответственно, все IP-адреса клиентов, перешедших по ссылкам-ловушкам, тут же попадают под бан (заносятся в чёрный список и блокируются).

Чтобы избегать таких ловушек, можно пользоваться технологиями компьютерного зрения или научить парсеры игнорировать элементы и ссылки, скрытые для отображения.

Как определить, что прокси-сервер не работает и как его исправить

Прокси предлагают широкий спектр преимуществ, включая увеличение времени безотказной работы сети, возможность обрабатывать неограниченное количество одновременных запросов, надежные IP-адреса и неограниченную ротацию. Кроме того, прокси играют решающую роль в защите ваших данных и местоположения от киберугроз, предотвращая тем самым кражу конфиденциальной информации и потенциальный ущерб вашей репутации или доверию клиентов.

Однако для более крупных организаций, которым требуется несколько прокси-серверов, эффективное управление несколькими прокси-серверами может стать проблемой.

Функция управления прокси в AdsPower помогает упростить управление и оптимизацию прокси. В этой статье будет описано руководство по эффективному управлению прокси в AdsPower и представлены решения для устранения любых сбоев прокси. Давайте начнем!

Как управлять прокси в AdsPower

AdsPower не предлагает прокси и не включает в себя какие-либо встроенные прокси. Однако раздел «Прокси» позволяет пользователям хранить приобретенные прокси в списке в AdsPower. В этом разделе пользователи имеют возможность изменять IP-адрес прокси, проверять, редактировать и удалять прокси.

Создайте список прокси

В списке прокси отображается следующая информация о прокси: ID, информация(хост:порт), тип, исходящий IP-адрес, серийный номер профиля, статус соединения, заметка, дата окончания действия и поставщик прокси.

1. Нажмите « Добавить Прокси ».

2. Заполните информацию о прокси в поле в правом верхнем углу согласно примерам.

3. Нажмите « ОК », и прокси будут добавлены в список прокси. Вы также можете изменить IP-адрес прокси, проверить, отредактировать и удалить прокси в списке прокси.

Проверьте прокси

Вы можете и проверять прокси массово, выделив их и нажав « Проверить прокси ».

Цвета состояния в столбце Исходящий IP:

Зеленый = прокси активен и тест соединения пройден

Красный = прокси неактивен и проверка соединения не прошла

Серый = ожидание проверки соединения

Поиск прокси

Чтобы найти прокси, просто нажмите кнопку « Фильтр », чтобы уточнить результаты поиска и найти нужные вам прокси.

Настройка сохраненных прокси для профилей браузера

AdsPower предоставляет два метода подключения сохраненных прокси к профилям: Настроить прокси и Случайные прокси .

Настроить прокси:

Этот метод в основном используется для назначения профилю определенных прокси. Вы можете выбрать прокси из списка прокси и назначить их соответствующим профилям.

Как изменить прокси-сервер в Python, если он не работает

К примеру, если Вы просто выполните парсинг Инстаграм, информация о пользователе не будет получена в требуемом формате. Для извлечения действительно актуальных данных и их успешного структурирования потребуется задействовать именно веб-скрейпинг. При выполнении автоматической комплексной процедуры сбор всей важной информации и её качественный анализ станет возможным лишь при успешном обходе защитных алгоритмов проверяемого сайта. Именно с этой целью потребуется подключить надежный прокси для Web Scraping. Сервер даст возможность гораздо эффективнее и быстрее выполнять маркетинговые задачи в Интернете.

Рассмотрим две основные причины использования прокси для парсинга и веб-скрейпинга.

- Запросы с сервера на сайт не будут ограничены.

Как известно, при множественном обновлении веб-страницы рано или поздно на ней запустится защитная система. Причина – выполняемые на сайте действия будут схожи с DDoS-атакой. Чтобы заблокировать её, система ограничит доступ к странице. Поскольку парсинг сайтов подразумевает отправку большого количества запросов, защита обязательно сработает, и остановит процесс сбора данных. Однако, если Вы используете один, а лучше – несколько прокси, то блокирования удастся избежать.

- Приватный сервер поможет обойти защиту от скрейпинга.

На некоторых сайтах присутствуют специальные системы, препятствующие процессам сбора данных. Так, когда с ресурса в таблицу будет выгружаться информация, она может в итоге отобразиться не в нужном формате. К примеру, Вы выполняете не парсинг ВК, а собираете данные с американского сайта. При наличии защиты на ресурсе полученная информация будет не на английском языке, а на русском. Чтобы выгрузить максимально актуальные данные, в данном случае достаточно выполнять парсинг аудитории или сайтов с использованием американского IP-адреса.

Преимущества Web Scraping с прокси

Осуществление комплексного процесса сбора данных с применением серверов proxy имеет большое количество достоинств. Среди таких преимуществ выделяется:

- Получение исключительно нужной информации без воды;

- Параллельная автоматизация сбора и обработки данных с сайта, а также структурирования при скрейпинге различных ресурсов;

- Возможность задействования мультиаккаунтинга;

- Простой доступ к массиву данных, которые защищены от парсинга;

- Обход ряда ограничений и блокировок (локальных, региональных), предотвращение бана по адресу IP.

Теперь Вы знаете, для чего нужен прокси в Web Scraping. Также отметим, что благодаря серверу скорость поиска, обработки и загрузки информации будет значительно выше. Данное преимущество обусловлено и тем, что подключение прокси выполняется через специализированное ПО. Это позволяет одновременно взаимодействовать и с сайтами, и с поисковыми системами.

Как использовать несколько прокси-серверов для веб-скрейпинга

Допустим, вы хотите написать переводчик на основе машинного обучения для исследовательского проекта, но у вас нет большого количества переведённого текста для тестирования. Многие крупные сайты предоставляют разные переводы одного и того же содержимого, в зависимости от указанных в заголовках предпочтений языка. Простое изменение `Accept-Language:en-US` на `Accept-Language:fr` в вашем заголовке может привести к тому, что сайты начнут отвечать вам «Bonjour», если это сайты крупных международных компаний, которые обычно имеют ресурсы и бюджет для поддержки перевода.

Заголовки также могут заставить веб-сайты изменить формат контента, который они предоставляют. Например, мобильные устройства часто видят упрощённые версии сайтов, без баннеров, Flash и других отвлекающих элементов. Если вы попробуете изменить ваш `User-Agent` на что-то вроде следующего, вы можете обнаружить, что сайты становятся проще для сбора данных (скрейпинга)!

User-Agent:Mozilla/5.0 (iPhone; CPU iPhone OS 7_1_2 like Mac OS X)

AppleWebKit/537.51.2 (KHTML, like Gecko) Version/7.0 Mobile/11D257

Safari/9537.53

Пояснения для новичков

1. Заголовки HTTP — это часть HTTP-запроса или ответа, которая содержит дополнительную информацию (метаданные) о запросе или ответе. Например, `Accept-Language` указывает предпочтительные языки контента.

2.Accept-Language— заголовок, который используется для указания языков, которые предпочтительны для пользователя. Изменение этого значения может привести к тому, что сайт предложит контент на другом языке.

3.User-Agent— строка, которая помогает идентифицировать тип устройства, операционную систему и браузер, который делает запрос. Изменение этого значения может заставить сайт думать, что вы используете другой браузер или устройство (например, мобильное устройство вместо десктопа).

4. Машинное обучение — это метод искусственного интеллекта, который позволяет программам учиться на данных и делать предсказания или принимать решения, не будучи явно запрограммированными на выполнение конкретной задачи.

5. Скрейпинг — это техника извлечения данных с веб-сайтов. ИзменениеUser-Agentможет помочь обойти некоторые ограничения сайтов, предназначенные для блокирования скрейпинга.

Как избежать ограничений при использовании прокси-серверов для веб-скрейпинга

Не важно, используете ли вы бесплатные прокси или покупаете у проверенных селлеров, всегда полезно протестировать их перед использованием. Учитывая, что многие продавцы предлагают возможность возврата денег, этот гайд будет особенно полезен, если прокси окажутся плохими. Да и в целом, вам разве нужны проблемы в будущем, когда кажется, что все настроено и готово к работе? :)

Ниже — 3 простых инструмента, с помощью которых можно проверить, работают ли ваши прокси, делают ли они вас анонимными и позволяют ли зайти на нужные вам сйаты.

1. А я вообще использую прокси-сервер?

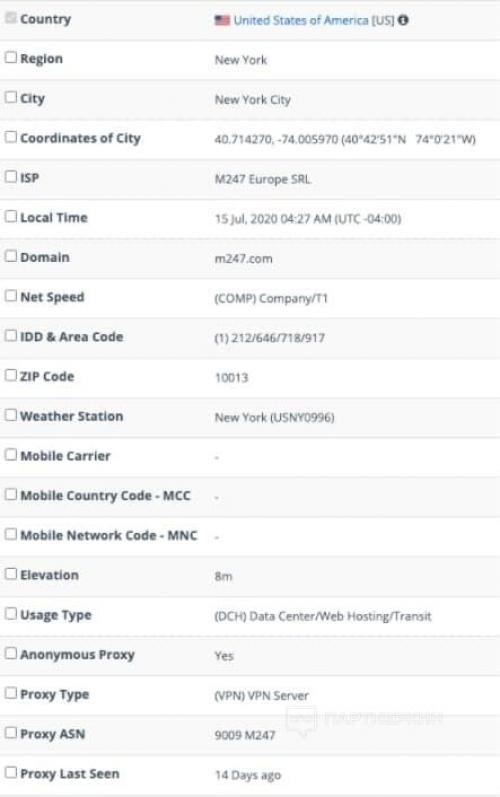

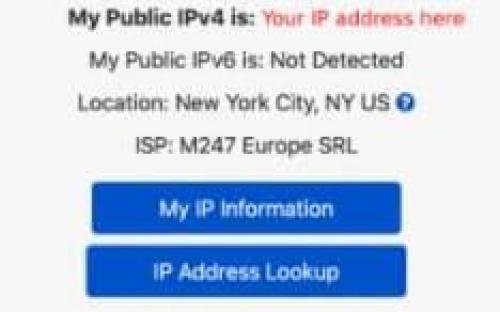

Часто для многих достаточно этой простой проверки. Принцип работы простой: вы заходите на сайт чекера (например, whatismyip) — он показывает, изменились ли ваши IP и местоположение.

Что показывает : ваш IP-адрес и местоположение Ограничения : не показывает, используете ли вы прокси-сервер; не показывает, работают ли ваши прокси с конкретными сайтами Как тестировать : настраиваем прокси в браузере, заходим на сайт чекера, жмем F5 (для rotating прокси), смотрим результат

2. Прокси работают корректно?

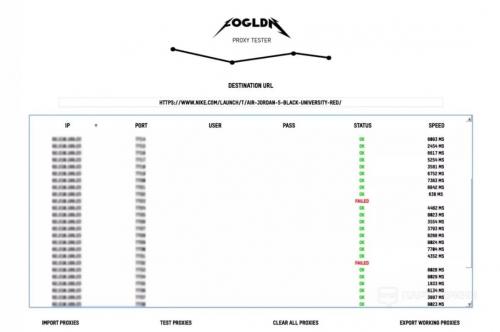

Здесь мы будем пользоваться популярным бесплатным инструментом FOGLDN Proxy Tester. Он показывает, работают ли наши прокси с определенными сайтами и сколько времени потребуется для подключения.

Что показывает : работают ли прокси с нужными сайтами, время отклика Ограничения : если тест провалился, не покажет причины; не показывает местоположение прокси-сервера, тип, анонимность; нельзя выбирать количество и скорость запросов Как тестировать : скачиваем инструмент, добавляем лист прокси, вводим URL, жмем "test proxies"

3. Узнаём больше о прокси при помощи базы данных

Хорошие базы данных IP-адресов стоят денег, хотя некоторые позволяют провести несколько бесплатных проверок. Например, IP2Location бесплатно дает совершить 50 (200 при регистрации) проверок IP-адресов в день.