Скрапинг в 2025: 10 лучших инструментов для эффективного анализа данных

- Скрапинг в 2025: 10 лучших инструментов для эффективного анализа данных

- Связанные вопросы и ответы

- Какие инструменты скрапинга будут наиболее популярными в 2025 году

- Какие функции должны быть у инструментов скрапинга для бизнеса в 2025 году

- Какие технологии используются в инструментах скрапинга в 2025 году

- Как инструменты скрапинга помогают бизнесу в 2025 году

- Какие преимущества имеют инструменты скрапинга в 2025 году по сравнению с инструментами скрапинга в 2020 году

- Какие изменения произойдут в инструментах скрапинга в 2025 году

- Как инструменты скрапинга влияют на эффективность работы команды в 2025 году

Скрапинг в 2025: 10 лучших инструментов для эффективного анализа данных

Основное их направление — веб-скрапинг, а клиенты таких сервисов собирают данные с веб-страниц и конвертируют их в нужный формат.

Что такое скрапинг

Веб-скрапинг — это извлечение данных с веб-сайта или приложения в формате, понятном обычному человеку .

- jS-рендеринг ;

- качественные прокси;

- до 20 одновременных запросов;

- геотеги;

- есть расширение Prestashop, которое синхронизируется с сайтом отслеживания цен конкурента.

Все эти данные полезны для поиска потенциальных клиентов, сбора информации , выявления тенденций рынка, маркетингового анализа и .

процесс сбора данных не запрещен , однако некоторые недобросовестные компании незаконно используют возможности парсинга . Так в октябре 2020 года Facebook подал в суд на две организации, распространявшие вредоносное расширение для Chrome. Это позволяло проводить несанкционированный веб-скрапинг из социальных сетей: собранные данные содержали контент публичного и непубличного характера. Впоследствии вся полученная информация была продана маркетинговым компаниям, что является грубым нарушением закона.

Ну а для тех, кто собирается использовать парсинг для развития бизнеса, ниже я расскажу о лучших сервисах, предоставляющих эту услугу.

Большинство сервисов парсинга данных — это платные решения для сложных задач, но есть и условно-бесплатные программы , которые подходят для простых проектов. В этом разделе мы рассмотрим оба варианта.

ScraperAPI

Его легко интегрировать — вам просто нужно отправить GET-запрос к API с ключом API и URL-адресом . Кроме того, ScraperAPI практически невозможно заблокировать, так как он меняет IP-адреса при каждом запросе, автоматически повторяет неудачные попытки и разгадывает капчи.

Функции

Официальный сайт : ScraperAPI

ScrapingBee

ScrapingBee использует API парсинга веб-страниц, который обрабатывает безголовые браузеры и управляет прокси-серверами, обходя все типы блокировки.

Компания предлагает API для сбора данных о розничной торговле и недвижимости, включая описание продукта, цену, валюту, отзывы, цену покупки или аренды, площадь, местоположение. Доступные тарифные планы, рендеринг JS, парсинг веб-страниц с использованием Angular JS, Ajax, JS, React JS, а также возможности геотаргетинга делают этот продукт незаменимым инструментом сбора данных.

Функции :

Если вам просто нужно собрать метаданные со страницы , вы можете воспользоваться бесплатным. Но бывает, что нужно копнуть гораздо глубже и извлечь больше данных, и тут без сложных (и не бесплатных ) инструментов не обойтись.

Евгений Костино о том, как сломать любое место , даже если вы совсем не дружите с программированием.

Одно из применений парсинга — наполнение каталогов новыми товарами на основе существующих страниц в Интернете.

Связанные вопросы и ответы:

1. Что такое скрапинг и зачем он нужен

Скрапинг - это процесс извлечения данных из веб-сайтов с целью их последующего использования. Это может быть использовано для анализа рынка, поиска информации, сборки базы данных и т.д.

2. Какие инструменты скрапинга будут популярны в 2025 году

В 2025 году популярными инструментами скрапинга могут стать программы, такие как Scrapy, Beautiful Soup, Selenium и Puppeteer.

3. Как будут развиваться инструменты скрапинга к 2025 году

К 2025 году инструменты скрапинга будут более интеллектуальными и умными, что позволит извлекать более сложные данные и анализировать их более эффективно.

4. Какие проблемы могут возникнуть при использовании инструментов скрапинга

При использовании инструментов скрапинга могут возникнуть проблемы с защитой конфиденциальности, нарушением авторских прав, ограничениями на доступ к веб-сайтам и другими юридическими проблемами.

5. Как избежать проблем при использовании инструментов скрапинга

Чтобы избежать проблем при использовании инструментов скрапинга, необходимо соблюдать законы и правила, использовать инструменты с краповым соглашением, не нарушать авторские права и не наносить ущерб веб-сайтам.

6. Как выбрать лучший инструмент скрапинга для своей задачи

Чтобы выбрать лучший инструмент скрапинга для своей задачи, необходимо определиться с целями и требованиями к инструменту, проанализировать доступные инструменты и выбрать наиболее подходящий.

7. Как обучиться работе с инструментами скрапинга

Чтобы научиться работе с инструментами скрапинга, можно пройти онлайн-курсы, читать учебные материалы, посмотреть видеоуроки и практиковаться самостоятельно.

8. Какие области применения инструментов скрапинга будут наиболее популярными в 2025 году

В 2025 году наиболее популярными областями применения инструментов скрапинга могут стать анализ рынка, поиск информации, сбор данных для исследований и анализа, создание баз данных и т.д.

Какие инструменты скрапинга будут наиболее популярными в 2025 году

Мы рассмотрели несколько доступных в интернете инструментов для скраппинга, начиная с официальных Скребок для Twitter к сторонним сервисам и даже библиотекам Python с открытым исходным кодом, и перечислил их ниже.

Первый метод, который мы рассмотрим, - это скреперы Twitter на основе API, к которым относятся Twitter API V2, Apify, Brightdata и Scrapingdog.

Twitter API v2 - это последняя версия API Twitter, официального и одного из наиболее часто используемых API для разработчиков, создающих приложения с социальным взаимодействием, или исследователей/индивидуалов, собирающих данные для своих конкретных целей. Использование новых API позволяет легко отслеживать и анализировать живые разговоры в социальных сетях.

Недавно Twitter добавил несколько новых функций, таких как конечные точки, варианты полезной нагрузки для сообщений твитов, наборы идентификаторов разговоров и аннотации. Эти изменения весьма впечатляют. Однако новая структура ценообразования вызвала серьезные опасения у разработчиков и сторонних приложений. С новой структурой ценообразования доступ к сервисам резко сократился, а цены резко выросли.

Ценовые планы Twitter/X API v2 имеют три уровня: Бесплатный, базовый и корпоративный.

- В бесплатном уровне разработчики могут размещать до 1500 твитов в месяц предназначен для использования только для записи и тестирования API Twitter.

- Базовый уровень стоит $100 в месяц и позволяет разработчикам публиковать до 3 000 твитов в месяц на уровне пользователя и 50 000 твитов (с лимитом чтения 10 000) на уровне приложений.

- Шина Enterprise включает в себя более продвинутые функции, предназначенные для бизнеса. Однако за корпоративный план разработчики/бизнесмены будут платить непомерно высокую цену Почти 42000$ в месяц .

4.1.2. Apify

С помощью программы Apify's Twitter Scraper можно извлекать информацию из общедоступных данных Twitter, таких как хэштеги, темы, ответы, изображения и многое другое. Недавние изменения в Twitter наложили новые ограничения на просмотр и скраппинг твитов на этой платформе, так как пользователи могут извлекать только до 100 твитов на профиль. Этот скрепер не может скрести последние твиты, но может извлечь наиболее понравившиеся. Извлеченные данные могут быть доступны в форматах HTML, JSON, Excel и CSV.

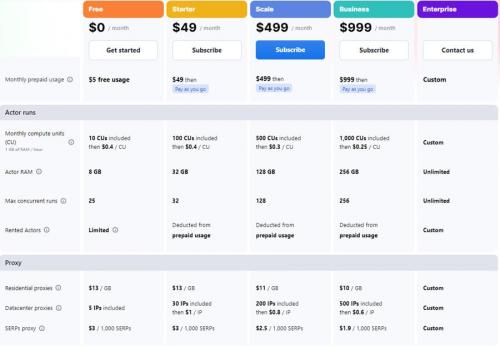

На следующем рисунке показана ежемесячная стоимость услуг компании Apify. Кроме того, компания предлагает скидку 10% на годовой план. Для получения дополнительной информации посетите Ценообразование в Apify .

Фото: Apify

4.1.3. Brightdata

Фото: Brightdata

Bright Data - это платформа для сбора данных, предлагающая такие инструменты для веб-скрейпинга, как прокси-серверы, API и решения, не требующие кода. Web Scraper от Bright Data дает пользователям возможность извлекать данные из публичных профилей Twitter, включая изображения,

Цены начинаются с ежемесячной платы 500$ за 151000 загрузок страниц . Сборщик данных Bright Data Twitter scraper совместим со всеми веб-сервисами и выводит данные в формате Excel. Он также предлагает 7-дневную пробную версию, и вы можете протестировать платформу, прежде чем заплатить 500 баксов.

4.1.4. Scrapingdog

Scrapingdog - это веб-скраппинг API, который поможет вам скрапить любой сайт, включая Twitter. Он позволяет скрести твиты, используя идентификаторы твитов, или скрести публичные страницы, чтобы извлечь такие детали, как количество подписчиков, число последователей и ссылки на сайт.

Скрап Twitter стоит 0,0009$ за страницу. в стандартном тарифном плане, что является одним из лучших показателей по сравнению с другими лучшими скреперами Twitter. Они также предоставили бесплатную пробную версию; вы можете отменить подписку в любое время и легко вернуть свои деньги. Для получения дополнительной информации о том, как соскребать данные с помощью Scrapingdog, вы можете посетить сайт Документация по Twitter Scraping API .

Фото: ScrapingDog

4.2. Библиотеки и пакеты Python для скраппинга Twitter

Теперь, когда вы знакомы с API Twitter и такими приложениями, как Apify, пришло время взглянуть на библиотеки и пакеты Python для работы с Twitter.

4.2.1. Tweepy

Фото: Tweepy

Tweepy - это пакет Python с открытым исходным кодом, который позволяет разработчикам получать доступ к конечным точкам Twitter плавно и прозрачно. Однако вы должны знать, что Twitter наложил ограничения на количество запросов, отправляемых к API X/Twitter, где Разрешено 900 запросов каждые 15 минут . В этом разделе мы рассмотрим функциональность Tweepy и приведем простой пример.

Для начала установите пакет Tweepy с помощью команды "pip install Tweepy" в вашей Python IDE, а затем импортируйте Tweepy. Следующим шагом будет регистрация вашего клиентского приложения в Twitter. Создайте новое приложение. После этого вы получите токен на предъявителя.

Какие функции должны быть у инструментов скрапинга для бизнеса в 2025 году

Один из наиболее распространённых способов использования веб-скрапинга заключается в сборе с различных сайтов информации о ценах товаров. Есть люди, которые создают скраперов, запускающихся ежедневно и собирающих цены на конкретный товар. Когда цена на товар упадёт до определённого уровня, программа автоматически покупает товар, стремясь сделать это до того, как этот товар окажется распроданным. Затем, так как спрос на товар будет выше предложения, тот, кто до этого купил товар по низкой цене, перепродаёт его по более высокой цене и получает прибыль. Это — пример лишь одной из тактик перепродажи товаров, купленных по низким ценам, которой пользуются создатели веб-скраперов.Ещё одна схема, пример которой я сейчас продемонстрирую, может помочь вам хорошо сэкономить или достойно заработать.В каждом интернет-магазине бывают всяческие спецпредложения и распродажи. В карточках соответствующих товаров обычно показывают исходную цену и цену со скидкой. Правда, обычно разницу между новой и старой ценой, выраженную в процентах, не показывают. Например, если часы обычно стоят $350, а на распродаже — $300, то можно подумать, что $50 — это отличная скидка. Но это, на самом деле, скидка всего в 14,2%. А вот, например, майка, которая обычно стоит $50, а на распродаже её предлагают за $40. Вроде бы $10 — это не так уж и много, но это — скидка в 20%, то есть — более высокая, чем скидка на часы. Эти сведения позволяют экономить или зарабатывать, находя товары с самыми высокими скидками, выраженными в процентах.Применим эти рассуждения к анализу цен на товары в универсальном интернет-магазине. У них постоянно бывают распродажи товаров самых разных марок. Мы, пользуясь технологиями веб-скрапинга, собираемся найти товары с самыми высокими скидками.После обработки сайта скрапер выдал более 900 товаров, и, как можно заметить, среди них есть всего один, скидка на который превышает 50%. Это — товар Perry Ellis Solid Non-Iron Dress Shirt.Это — предложение, ограниченное по времени, поэтому цена на рубашку, в итоге, скоро вернётся к своему обычному уровню примерно в $90. Поэтому, если бы я купил эту рубашку за $40 и потом продал бы её на $30 дешевле её обычной цены, то есть, за $60, я заработал бы $20.Этот метод, если найти подходящую нишу, способен помочь в заработке серьёзных денег.

Какие технологии используются в инструментах скрапинга в 2025 году

Скрапинг — это способ автоматизировать сбор информации. Например, вы составили X-ray-запрос и получили выдачу в гугле на 40 страниц. Что делать дальше? Можно вручную заходить на каждую страницу, выбирать и сохранять подходящие профили. На это уйдет вечность.

А можно воспользоваться скрапером — специальной программой, которая за минуту сама пробежится по страницам и сохранит все профили в таблице, разложив данные о кандидатах по ячейкам.

Основная задача скрапинга — ускорение сорсинга. Но скрапинг используется и в других случаях, когда нужно вытащить и структурировать информацию с какого-то ресурса.

Скрапинг нужен не всегда, это инструмент для продвинутого сорсинга. Вот когда он пригодится:

- Для работы с большой поисковой выдачей. Например, при поиске кандидатов по популярному стеку технологий среди всех людей, которые есть в выбранной стране. А если вы составили запрос и получили всего 10 профилей, то скрапить здесь нечего.

- Чтобы оценить рынок и сформировать лонглист. Для рекрутера, особенно внешнего, важно, чтобы заказчик осознавал объем рынка. Можно рассказать ему на словах, сколько всего есть кандидатов. Но лучше показать полный список людей, которым можно предложить вакансию: так убедительнее.

- Чтобы освободить время. Скрапинг экономит часы работы на сбор и систематизацию информации, составление таблиц, отчетов и пайплайнов. Освободившееся время можно потратить на персонализацию общения и копирайтинг. Ведь наша задача — не только найти кандидата, но и сделать все, чтобы заинтересовать его.

Как инструменты скрапинга помогают бизнесу в 2025 году

Apify — это платформа, на которой разработчики создают, развертывают и контролируют инструменты очистки веб-страниц с открытым исходным кодом и инструменты автоматизации браузера. Извлечение данных упрощается с помощью Crawlee, их популярной библиотеки для создания надежных парсеров.

Они предлагают сотни готовых инструментов для вашего проекта веб-скрапинга или автоматизации. Одним из примеров является Web Scraper, универсальный и простой в использовании инструмент для сканирования произвольных веб-страниц и извлечения структурированных данных с веб-страниц. Web Scraper можно настроить и запустить вручную в пользовательском интерфейсе или программно с использованием API. Извлеченные данные сохраняются в наборе данных, откуда их можно экспортировать в различные форматы, такие как JSON, XML или CSV.

Другой пример — Google Maps Scraper. Этот инструмент расширяет возможности извлечения данных Google Maps, выходя за пределы ограничений официального API Google Places. Он обеспечивает более высокую скорость и позволяет собирать различные детали, такие как имена, контактную информацию, обзоры, популярное время, рейтинги, геолокацию и многое другое. Вы можете выполнять сбор данных по поисковому запросу, местоположению, координатам или URL-адресу, ориентируясь на несколько мест, город или всю область.

Особенности :

- Разработка с использованием инструментов с открытым исходным кодом

- Поддерживает лучшие в мире команды, работающие с данными

- Сотни готовых скребков

- Выдержки из Youtube/Amazon/Twitter/Google Maps и других источников.

Какие преимущества имеют инструменты скрапинга в 2025 году по сравнению с инструментами скрапинга в 2020 году

Puppeteer – это JavaScript-библиотека, разработанная командой Chrome Browser Automation (входит в состав официальных разработчиков Google Chrome), она реализует высокоуровневый API-интерфейс для протокола Chrome DevTools Protocol и драйвера WebDriver BiDi . В первую очередь такая прослойка нужна для унификации синтаксиса при написании скриптов тестирования сайтов и web-приложений.

Как можно догадаться, протокол Chrome DevTools предназначен для работы только с браузерами Google Chrome или Chromium.

Немного сложнее дела обстоят с веб-драйвером BiDi – с недавних пор он поддерживает работу с Firefox, поэтому при желании Puppeteer можно интегрировать не только с Хромом (как это изначально задумывалось), но и с Огнелисом.

Официальный сайт Puppeteer . Упоминание инструмента на портале для разработчиков Chrome DevTools .

Разработка Puppeteer ведётся с 2017 года (через год после запуска headless-Chrome). Существует упрощённая версия библиотеки, puppeteer-core, которая может интегрироваться с любым установленным в системе Chromium-браузером, например, с Edge.

Преимущества использования Puppeteer для веб-скрапинга

- Совместимость с браузерами на базе Chromium и Firefox.

- Кроссплатформенность (на самом деле библиотеке важно только наличие поддержки языка программирования, поэтому она может работать в любой операционной системе, в которой есть совместимый браузер).

- Это образец того, как может и должна выглядеть автоматизация браузера Хром на базе Node.js. Соответственно, можно задействовать языки программирования JavaScript и TypeScript.

- Взаимодействие с Хромом происходит без web-драйвера – через оригинальный протокол Chrome DevTools (проще и быстрее настройка, не нужно качать отдельный headless-браузер).

- Простой и понятный синтаксис.

- Возможность перехвата запросов (интерцепторы).

- Автоматическое ожидание показа элементов вёрстки + ряд специфических методов.

- Возможность параллельного выполнения сценариев с изолированием контекстов (экземпляров браузера).

- Новый экземпляр браузера по умолчанию запускается в headless-режиме и потребляет минимум вычислительных ресурсов.

- Возможность быстрого создания скриншотов и PDF-версий страниц.

- Базовый набор возможностей для тестирования и трассировки.

- За созданием и обслуживанием стоит крупный вендор – компания Google.

Какие изменения произойдут в инструментах скрапинга в 2025 году

Как мы уже говорили, услуги веб-скрапинга дают несколько преимуществ вашему бизнесу.

Чтобы получить максимальную выгоду от веб-скрапинга, важно четко определить цели вашего бизнеса . Четкое определение целей вашего бизнеса поможет вам выбрать лучший инструмент веб-скрапинга для ваших конкретных нужд.

Веб-скрапинг может позволить вашему бизнесу достичь нескольких целей и задач, включая такие варианты использования, как:

- Машинное обучение: Веб-скрапинг позволяет генерировать большие объемы обучающих и тестовых данных, которые можно использовать для построения моделей машинного обучения. Услуги веб-скрапинга могут обеспечить необходимые обучающие данные для моделей машинного обучения путем извлечения данных из различных источников и преобразования их в структурированный, пригодный для использования формат.

- Конкурентная разведка: Услуги веб-скрапинга позволяют получить ценные сведения для компаний, стремящихся повысить свою конкурентоспособность. С помощью веб-скрапинга можно расширить возможности маркетинговых исследований и разработать стратегию бизнеса, собрав данные об услугах и продуктах конкурентов, а также о широких рыночных тенденциях и поведении потребителей.

- Бизнес-инсайты: Услуги веб-скрапинга позволяют компаниям получать данные о клиентах, что дает им возможность принимать обоснованные решения о том, как лучше позиционировать продукты и услуги.

- Сравнение цен: Услуги веб-скрапинга позволяют компаниям получать данные в режиме реального времени для эффективного сравнения цен на товары и услуги на нескольких веб-сайтах. Инструмент веб-скрапинга позволяет компаниям оптимизировать цены на основе данных и предлагать на рынке более конкурентоспособные по цене предложения.

- Генерация лидов: Веб-скрапинг позволяет компаниям извлекать контактную информацию и другие персонально идентифицируемые данные (PII) с веб-сайтов, что дает им возможность генерировать лиды для продаж и маркетинга.

- Исследование рынка: Веб-скрапинг позволяет легко и эффективно собирать данные из различных источников, обеспечивая полное и актуальное представление о клиентах, рынках и конкурентах.

Как инструменты скрапинга влияют на эффективность работы команды в 2025 году

Мгновенный скребок данных это автоматизированный инструмент для сбора информации с веб-сайтов, разработанный webrobots.io . Он доступен в виде расширения для Google Chrome. Инструмент использует искусственный интеллект для прогнозирования и извлечения наиболее важных данных из HTML-страниц. Кроме того, инструмент очень прост в использовании. Он отлично подходит как для новичков, так и для профессионалов, позволяя извлекать данные без необходимости писать сложный код или создавать скрипты для конкретного сайта. Это довольно удобный инструмент для решения самых разных задач - от маркетинговых исследований до генерации лидов, что делает его универсальным инструментом в сфере извлечения данных.

a. Ключевые особенности:

- Обнаружение данных с помощью искусственного интеллекта: Инструмент использует алгоритмы искусственного интеллекта для автоматического определения и извлечения релевантных данных с веб-страниц. Эта функция помогает сократить ручной ввод и повысить эффективность.

- Динамическое обнаружение нагрузки на данные: Instant Data Scraper может обнаружить, когда на веб-странице загружаются динамические данные. Он обеспечивает полное извлечение данных.

- Настраиваемая скорость ползания: Пользователи могут установить задержку и максимальное время ожидания. Эта функция позволяет настроить скорость скраппинга в соответствии с конкретными требованиями.

- Поддержка пагинации: Инструмент поддерживает пагинацию, что позволяет ему осуществлять навигацию и соскабливать данные на нескольких страницах, в том числе с бесконечной прокруткой.

- Параметры экспорта данных: Извлеченные данные можно легко экспортировать в форматы Excel (XLS, XLSX) или CSV. Эта особенность облегчает интеграцию с другими инструментами анализа данных.

- Настройка извлечения: Пользователи могут настраивать выборку данных для повышения точности, если автоматические прогнозы ИИ не удовлетворяют их.