Какие инструменты веб-парсинга использовать в 2022 году: наши рекомендации

- Какие инструменты веб-парсинга использовать в 2022 году: наши рекомендации

- Связанные вопросы и ответы

- Что такое веб-парсинг и для чего он используется

- Какие инструменты веб-парсинга являются лучшими в 2022 году

- Какие функции должен иметь инструмент веб-парсинга для того, чтобы считаться лучшим

- Какие типы данных можно извлечь с помощью веб-парсинга

- Как выбрать подходящий инструмент веб-парсинга для своих задач

- Какие преимущества имеют платные инструменты веб-парсинга по сравнению с бесплатными

- Какие ограничения могут быть связаны с использованием инструментов веб-парсинга

Какие инструменты веб-парсинга использовать в 2022 году: наши рекомендации

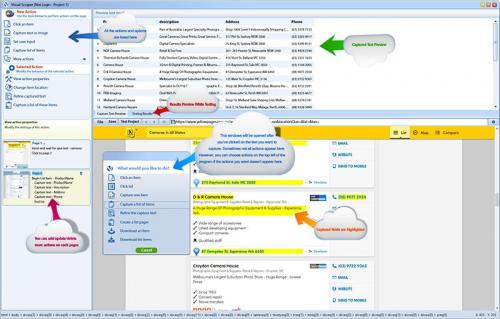

Octoparse — это программа для ПК, которая не требует знаний в области программирования для парсинга веб-сайтов. Это визуальный веб-парсер, использующий систему «укажи и нажми», что упрощает использование, даже если вы никогда раньше не выполняли парсинг веб-сайтов и не писали код:

Давайте кратко рассмотрим, что предлагает Octoparse:

| Преимущества | Недостатки |

|---|---|

| Инструмент без кода, интерфейс «укажи и нажми» | Бесплатный план очень ограничен, другие планы относительно дорогие |

| Большая библиотека шаблонов | Система кредитов для использования важных функций |

| Простое создание и настройка шаблонов | |

| Хорошая документация и руководства | |

| Множество вариантов экспорта |

Одна из самых полезных функций Octoparse — библиотека шаблонов. Эта библиотека содержит предустановленные шаблоны для некоторых из самых популярных веб-сайтов в Интернете, позволяющие получать данные за считанные секунды. Например, вы можете легко выполнить парсинг вакансий LinkedIn (и получить подробную информацию, например название должности, сведения о компании и описание вакансии), продуктов Amazon или всех твитов из определенного аккаунта X (ранее Twitter).

Даже если шаблон для вашего конкретного варианта использования отсутствует, вы можете с легкостью создать и настроить собственные парсеры. Используя визуальную панель управления Octoparse, вы можете открывать веб-страницы, входить в аккаунты и вводить текст. Кроме того, обработанные данные можно экспортировать в несколько различных форматов, такие как CSV, HTML, XLSX и TXT.

Octoparse также позволяет планировать работу парсеров, поскольку облачное решение доступно 24/7. Другие функции включают прокси-серверы, решение капч, ротацию IP-адресов, бесконечную прокрутку, автоматический экспорт данных и поддержку OpenAPI.

Несмотря на свои преимущества, у Octoparse также есть несколько недостатков. Как и ScraperAPI, он относительно дорогой. Бесплатный план очень ограничен и лучше всего подходит для тестирования инструмента перед покупкой. Стандартный план Octoparse стоит 89 $ в месяц, а профессиональный план — 249 $ в месяц. Однако самая большая проблема Octoparse заключается в том, что она использует кредитную систему для премиум-шаблонов, прокси-серверов и средства решения капч. При использовании этих функций затраты могут быстро возрасти.

В 2022 году веб-парсинг стал более популярным, чем когда-либо. Многие компании и индивидуумы используют веб-парсинг для извлечения данных из веб-страниц, чтобы анализировать рынок, получать информацию о конкурентах, а также для автоматизации бизнес-процессов.

В этом году мы рекомендуем использовать Octoparse, программу для ПК, которая не требует знаний в области программирования для парсинга веб-сайтов. Octoparse - это визуальный веб-парсер, использующий систему "укажи и нажми", что упрощает использование, даже если вы никогда раньше не выполняли парсинг веб-сайтов и не писали код.

Что предлагает Octoparse?

Одна из самых полезных функций Octoparse - библиотека шаблонов. Эта библиотека содержит предустановленные шаблоны для некоторых из самых популярных веб-сайтов в Интернете, позволяющие получать данные за считанные секунды. Например, вы можете легко выполнить парсинг вакансий LinkedIn (и получить подробную информацию, например, название должности, сведения о компании и описание вакансии), продуктов Amazon или всех твитов из определенного аккаунта X (ранее Twitter).

Даже если шаблон для вашего конкретного варианта использования отсутствует, вы можете с легкостью создать и настроить собственные парсеры. Используя визуальную панель управления Octoparse, вы можете открывать веб-страницы, входить в аккаунты и вводить текст. Кроме того, обработанные данные можно экспортировать в несколько различных форматов, такие как CSV, HTML, XLSX и TXT.

Octoparse также позволяет планировать работу парсеров, поскольку облачное решение доступно 24/7. Другие функции включают прокси-серверы, решение капч, ротацию IP-адресов, бесконечную прокрутку, автоматический экспорт данных и поддержку OpenAPI.

Преимущества и недостатки Octoparse

Несмотря на свои преимущества, у Octoparse также есть несколько недостатков. Как и ScraperAPI, он относительно дорогой. Бесплатный план очень ограничен и лучше всего подходит для тестирования инструмента перед покупкой. Стандартный план Octoparse стоит 89 $ в месяц, а профессиональный план - 249 $ в месяц. Однако самая большая проблема Octoparse заключается в том, что она использует кредитную систему для премиум-шаблонов, прокси-серверов и средств решения капч. При использовании этих функций затраты могут быстро возрасти.

Связанные вопросы и ответы:

Вопрос 1: Что такое веб-парсинг

Ответ: Веб-парсинг - это процесс извлечения данных из веб-страниц. Он используется для автоматизации сбора информации с веб-сайтов и создания баз данных. Веб-парсинг может быть использован для различных целей, таких как создание индексов, поиск информации, аналитика и многие другие.

Вопрос 2: Какие инструменты веб-парсинга используются в 2022 году

Ответ: В 2022 году используются различные инструменты веб-парсинга, такие как Beautiful Soup, Scrapy, ParseHub, Octoparse, Import.io, WebHarvy и many more. Каждый инструмент имеет свои особенности и преимущества, и выбор инструмента зависит от конкретных задач и требований пользователя.

Вопрос 3: Какие преимущества имеет веб-парсинг

Ответ: Веб-парсинг имеет множество преимуществ, таких как автоматизация сбора информации, уменьшение времени на обработку данных, улучшение качества данных, уменьшение человеческих ошибок и многие другие. Веб-парсинг также позволяет собирать данные из большого количества источников, что делает его эффективным и экономически выгодным.

Вопрос 4: Какие ограничения имеет веб-парсинг

Ответ: Веб-парсинг имеет свои ограничения, такие как ограничения на количество запросов, ограничения на IP-адреса, ограничения на скорость запросов и другие. Также некоторые сайты используют защитные механизмы, такие как капчи, чтобы предотвратить веб-парсинг.

Вопрос 5: Как выбрать подходящий инструмент веб-парсинга

Ответ: Выбор инструмента веб-парсинга зависит от конкретных задач и требований пользователя. Важно учитывать такие факторы, как скорость парсинга, возможность обработки больших объемов данных, возможность парсинга динамических веб-страниц, возможность сохранения данных в различных форматах и другие.

Вопрос 6: Как избежать проблем с веб-парсингом

Ответ: Чтобы избежать проблем с веб-парсингом, важно соблюдать некоторые правила, такие как не использовать большое количество запросов, не использовать один и тот же IP-адрес для запросов, не использовать капчи и другие защитные механизмы, не использовать нелегальные методы веб-парсинга и другие.

Вопрос 7: Как использовать веб-парсинг для аналитики

Ответ: Веб-парсинг может быть использован для аналитики, чтобы собирать данные с веб-сайтов и анализировать их для получения полезной информации. Например, веб-парсинг может быть использован для анализа поисковых запросов, анализа контента веб-сайтов, анализа трафика на веб-сайтах и многих других.

Что такое веб-парсинг и для чего он используется

Парсинг применяется в любых областях, где требуется проанализировать и систематизировать большой объем данных:

- В программировании. Компьютер может воспринимать и «понимать» только машинный код — набор нулей и единиц. Чтобы заставить машину выполнить какую-либо операцию, человек использует языки программирования, которые непонятны компьютеру. Поэтому специальное приложение сначала проводит парсинг написанной пользователем программы и переводит полученные данные в бинарный машинный код.

- В создании сайтов. Как и языки программирования, языки разметки (например HTML) непонятны компьютеру. Чтобы он смог отобразить HTML-разметку в виде визуально структурированного и понятного интерфейса сайта, парсер браузера анализирует исходный код страницы, вычленяет нужные данные, переводит их в понятный машине формат. Также парсинг позволяет выявить ошибки и недочеты в созданном сайте.

- Веб-краулинг. Это частный случай парсинга. Робот-парсер поисковика в ответ на запрос пользователя просматривает релевантные ему сайты, после чего выбирает наиболее подходящую по содержанию страницу. Особенность краулеров в том, что они не извлекают данные со страниц, как другие парсеры, а ищут в них совпадения с запросом пользователя.

- Агрегация новостей. Для упорядоченной подачи новостей сайты-агрегаторы или новостные агентства используют парсеры. Они собирают обновления со всех доступных источников, анализируют их и подают сотрудникам для конечной редактуры и публикации.

- Интернет-маркетинг. В SEO и SMM с помощью парсеров собираются и анализируются данные пользователей, товарные позиции в интернет-магазинах, метатеги (заголовки, title и description), ключевые слова и другая информация. Эти данные используются для оптимизации сайта, продвижения коммерческих групп в социальных сетях, настройки таргетированной и контекстной рекламы. Проверка размещенного на веб-ресурсе текста на плагиат также является разновидностью парсинга.

- Мониторинг цен. Парсерами можно извлечь расценки товаров на сайтах-конкурентах, чтобы проанализировать текущую ситуацию на рынке и выработать ценовую политику. Также с их помощью можно привести прайс-листы на собственном сайте в соответствие с ценами у поставщиков.

Какие инструменты веб-парсинга являются лучшими в 2022 году

Парсинг — набор технологий и приемов для сбора общедоступных данных и хранения их в структурированном формате. Данные могут быть представлены множеством способов, таких как: текст, ссылки, содержимое ячеек в таблицах и так далее.

Чаще всего парсинг используется для мониторинга рыночных цен, предложений конкурентов, событий в новостных лентах, а также для составления базы данных потенциальных клиентов.

Выбор инструмента будет зависеть от множества факторов, но в первую очередь от объема добываемой информации и сложности противодействия защитным механизмам. Но всегда ли есть возможность или необходимость в привлечении специалистов? Всегда ли на сайтах встречается защита от парсинга? Может быть в каких-то случаях можно справиться самостоятельно?

Тогда что может быть сподручнее, чем всем привычный Google Chrome? !

Расширения для браузера — это хороший инструмент, если требуется собрать относительно небольшой набор данных. К тому же это рабочий способ протестировать сложность, доступность и осуществимость сбора нужных данных самостоятельно. Всё что потребуется — скачать понравившееся расширение и выбрать формат для накопления данных. Как правило это CSV (comma separated values — текстовый файл, где однотипные фрагменты разделены выбранным символом-разделителем, обычно запятой, отсюда и название) или привычные таблички Excel.

Ниже представлено сравнение десяти самых популярных расширений для Chrome.

Забегая вперед:

все платные расширения имеют некоторый бесплатный период для ознакомления;

только три — Instant Data Scraper, Spider и Scraper — полностью бесплатны;

все платные инструменты (кроме Data Miner) имеют API (Application Program Interface — программный интерфейс, который позволяет настроить совместную работу с другими программами) .

Какие функции должен иметь инструмент веб-парсинга для того, чтобы считаться лучшим

Webhose.io

Webhose.io позволяет напрямую в онлайн-режиме выходить к структурированной информации, полученной после парсинга многочисленных интернет-площадок. Программа собирает web-данные на более 240 языках, сохраняя результаты в разных форматах, в том числе XML, JSON и RSS.

Webhose.io представляет собой web-приложение для браузера. Парсит данные по собственной уникальной технологии, позволяющей анализировать сведения в огромных объемах из множества источников с единственным API. Вы можете пользоваться бесплатным тарифным планом и ежемесячно обрабатывать тысячу запросов. Также предусмотрена платная премиум-версия: за $50 можно обрабатывать 5 тысяч запросов в месяц.

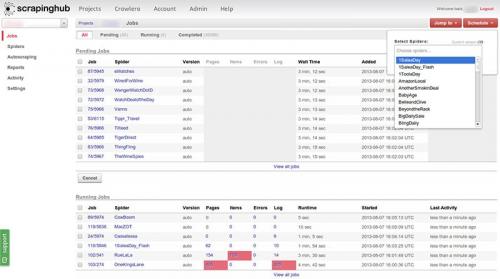

Scrapinghub

Scrapinghub – облачная программа для парсинга, с помощью которой можно искать и отбирать необходимую для любых целей информацию. Scrapinghub использует Crawlera, умный прокси-ротатор с функциями обхода защиты от ботов. Программа умеет работать с огромными пластами информации и интернет-площадками, защищенными от роботов.

Scrapinghub способна преобразовывать веб-страницы в структурированный контент. Группа профессионалов гарантирует индивидуальный подход к каждому клиенту и обещает создать решение под любой уникальный случай. При использовании базового бесплатного тарифа вам становится доступен один поисковый робот (обработка до 1 Гб информации, потом — $9 ежемесячно). При покупке премиального тарифа предоставляются 4 пакета параллельных поисковых ботов.

Какие типы данных можно извлечь с помощью веб-парсинга

Автоматический сбор информации имеет несколько преимуществ:

- Самостоятельная работа. Специалист ставит задачу, а парсер находит и сортирует данные по указанным параметрам при наличии стабильного доступа к Интернету. Время работы не ограничено. Программа может собирать сведения 24 часа в сутки без перерывов.

- Анализ и систематизация. Специалист указывает один или несколько параметров, по которым парсер сводит сведения. Количество настроек не ограничено. Готовый отчет содержит только необходимый контент без спама, ошибок или нерелевантной информации.

- Отсутствие ошибок. При использовании парсера человеческий фактор исключен. Программа не устает и не допускает ошибки по невнимательности.

- Удобный отчет. Парсер формирует сведения в удобной форме. Пользователь настраивает форму отчета сам.

- Распределение нагрузки. Парсер учитывает требования по частоте обращений к сайту и минимизирует риск взлома чужого сайта. Вас не обвинят в умышленной DDOS-атаке.

Единственный существенный недостаток парсинга — невозможность сбора данных с ресурсов с запретом на автоматический сбор сведений.

Владелец чужого сайта может запретить собирать данные по IP-адресам, включить настройки блокировки для поисковых ботов. Во всех остальных случаях парсинг — это быстрый и надежный способ сбора информации.

Если вы не хотите, чтобы конкуренты парсили ваш сайт, заблокируйте сторонние запросы через robots.txt или настройте капчу. Хотя эти способы не дают 100% защиты от парсинга конкурентов.

Обойти блокировку можно двумя способами:

- Настроить отображение бота по именем YandexBot, Googlebot и проверить отсутствие блокировки на эти имена в site.ru/robots.txt/IP.

- Включить VPN Капча для автоматического распознавания капчи.

Как выбрать подходящий инструмент веб-парсинга для своих задач

Этот инструмент может быть полезен в различных сферах — от бизнеса до науки. Вот несколько реальных примеров того, как веб-парсинг может помочь:

Отслеживание цен

Веб парсинг можно использовать для регулярного мониторинга цен на популярных e-commerce платформах, таких как Wildberries, Ozon, Яндекс.Маркет, Ebay, Amazon и других. При помощи этого метода автоматического сбора данных, компании легко отслеживают изменения цен у своих конкурентов, что позволяет им всегда быть конкурентоспособными в условиях постоянно меняющегося рынка. Обладая актуальными данными можно ежедневно обновлять информацию о ценах, скидках и акциях, а также своевременно реагировать на изменения и корректировать свою стратегию ценообразования.

Агрегация данных

Веб парсинг позволяет собирать данные с различных источников для получения максимально полной и точной информации. Это может быть полезно для более глубокой аналитики рынка, сбора данных о пользователях, продукции конкурентов или трендах в определенной отрасли. Например, агрегаторы данных часто используются в таких отраслях, как финансы, медицина и ритейл, где важно анализировать большие объемы данных, поступающих из разных источников. Это позволяет лучше понимать, что происходит на рынке в данный момент и принимать стратегические решения на основе собранных данных.

Генерация лидов для найма и продаж

Компании могут использовать веб парсинг для автоматической генерации лидов, будь то для отдела продаж или HR. Например, парсинг сайтов с резюме, таких как HeadHunter, помогает находить подходящих кандидатов по ключевым параметрам: профессии, опыту, навыкам. В свою очередь, для продаж можно использовать парсинг сайтов с отзывами (например, IRecommend) и бизнес-каталогов, чтобы находить потенциальных клиентов или партнеров. Это значительно ускоряет процесс поиска и позволяет автоматизировать рутинные задачи, связанные с генерацией лидов.

Защита бренда

Скрапинг может быть эффективным инструментом для защиты бренда от контрафактной продукции и неправомерного использования товарных знаков. В интернет пространстве нередки случаи появления сайтов, которые продают поддельные товары под известными брендами. С помощью парсинга можно отслеживать упоминания бренда на различных платформах, выявлять нелегальные сайты и своевременно принимать меры по их блокировке. Это помогает не только защитить репутацию бренда, но и минимизировать убытки, связанные с продажей подделок.

Инвестиционная аналитика

В финансовой сфере веб парсинг может использоваться для сбора данных о рынке труда. Например, парсинг вакансий на HeadHunter и Rabota.ru, может помочь инвесторам оценить спрос на специалистов в конкретной отрасли.

Можно также анализировать отзывы сотрудников о работе в компаниях на таких платформах как Glassdoor или Antijob. Это способ позволяет получить представление о корпоративной культуре и возможных проблемах внутри компании. Зная эти данные ты можешь выбрать компанию с наименьшим количеством проблем внутри коллектива для принятия решения о долгосрочном сотрудничестве или инвестировании.

Анализ настроений потребителей

С помощью веб скрапинга можно собирать и анализировать отзывы пользователей со всевозможных площадок, форумов и соцсетей. Это позволяет понять, что именно думают клиенты о том или ином продукте или услуге, какие проблемы они отмечают и какие изменения в продукте/услуге хотят видеть в будущем.

Мониторинг SEO

Веб парсинг широко используется для мониторинга SEO-показателей конкурентов С его помощью можно отслеживать позиции сайтов в поисковой выдаче (особенно для Яндекса), анализировать используемые ключевые слова и следить за качеством и количеством обратных ссылок. Это помогает корректировать собственную SEO-стратегию, улучшать ранжирование и эффективнее продвигать сайт в поисковых системах. В наше время это особенно актуально для любого бизнеса, так как конкуренция за первые места в поисковой выдаче очень высока.

Тестирование и мониторинг сайтов/приложений

Веб парсинг в сочетании с использованием прокси-серверов может применяться для тестирования и мониторинга корректности работы сайтов и приложений в разных странах и регионах. Например, если у компании несколько версий сайта для разных стран, парсинг позволяет проверить, как локализован контент и работает ли сайт корректно в каждой стране.

Также это может быть полезно для тестирования нагрузки, когда необходимо проверить, выдерживает ли сайт большие потоки трафика.

Обучение моделей машинного обучения

Веб парсинг играет важную роль в обучении нейросетей, так как позволяет собирать большие массивы данных для анализа и обработки. Например, парсинг текстов с новостных сайтов, блогов или форумов может помочь в обучении моделей для анализа тональности текстов или разработки рекомендательных систем.

Какие преимущества имеют платные инструменты веб-парсинга по сравнению с бесплатными

Помимо политики веб-сайта, вам следует придерживаться кодекса поведения. Этические стандарты парсинга помогут вам избежать блокировки и проявить уважение по отношению к правам и ресурсам вашего целевого сайта.

Соблюдение этих рекомендаций крайне важно:

- Не бомбардируйте серверы постоянными запросами . Делайте достаточные временные промежутки между ними. Некоторые сайты могут обнаруживать и блокировать парсеры, которые быстро извлекают большие объемы данных, потому что это не похоже на поведение человека. Чтобы выглядеть более естественно и снизить вероятность блокировки, рекомендуется добавлять временную задержку к запросам. Однако вместо фиксированной временной задержки лучше использовать нерегулярные интервалы, чтобы более точно имитировать поведение человека.

- Не собирайте личные данные без согласия . Это не только этический, но и зачастую юридический вопрос. Убедитесь, что у вас есть необходимые разрешения, прежде чем парсить личные данные.

- Уважайте данные, которые вы получаете . Используйте данные, которые вы собираете, ответственно и законно. Убедитесь, что вы делаете это в соответствии со всеми применимыми законами и правилами, такими как законы об авторском праве и Общий регламент по защите данных (GDPR).

Ниже мы показали, как вы можете создать нерегулярные интервалы между запросами в Python:

import time

import random

urls =

for url in urls:

response = requests.get(url)

# Process response

sleep_time = random.uniform(1, 10) # Generate a random sleep time between 1 and 10 seconds

time.sleep(sleep_time) # Sleep for a random time between requests

Этот код циклически просматривает списокurls-адресов в массиве urls. Для каждого URL он делает запрос на его получение, а затем приостанавливается, используя функциюtime.sleep(), прежде чем перейти к следующему запросу. Эти случайные интервалы помогают имитировать поведение человека в Интернете, снижая вероятность обнаружения.

Какие ограничения могут быть связаны с использованием инструментов веб-парсинга

JavaScript предлагает широкий выбор библиотек веб-скрапинга, которые упрощают этот процесс и повышают эффективность. Некоторые библиотеки включают Axios , Cheerio , Puppeteer и Playwright , каждая из которых отвечает разным требованиям и предпочтениям парсинга. Разработчики могут воспользоваться инструментами и функциями, которые предлагают эти библиотеки, упрощая процесс парсинга и облегчая извлечение и обработку данных из нескольких источников.

В качестве примера предлагаем рассмотреть фрагмент кода, который показывает, как использовать Puppeteer для парсинга заголовка веб-страницы:

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://example.com');

const pageTitle = await page.evaluate(() => {

return document.title;

});

console.log(`Title of the webpage: ${pageTitle}`);

await browser.close();

})();

Как видите, Puppeteer запускает браузер, переходит на сайтexample.com, извлекает заголовок страницы, выводит его на консоль и закрывает браузер.

JavaScript, наряду с HTML и CSS, – три основные технологии, которые лежат в основе современной сети. Неудивительно, что это один из лучших вариантов для веб-скрапинга. Гибкость JavaScript, легкая кривая обучаемости и обширные библиотеки для парсинга — сильные стороны, которые отличают его от других языков, таких как C++ и PHP. Он был бы бесспорным победителем в этих сегментах, если бы в списке не присутствовал Python.

Чтобы узнать больше о парсинге с помощью JavaScript, прочитайте наше руководство по веб-скрапингу с помощью JavaScript .