ТОП-8 Лучших программ парсинга данных: как выбрать идеальное решение для вашего проекта

- ТОП-8 Лучших программ парсинга данных: как выбрать идеальное решение для вашего проекта

- Связанные вопросы и ответы

- Какие критерии важны при выборе программы парсинга данных

- Какие уникальные функции предлагают топ-8 программ парсинга данных в 2022 году

- Какие выгоды могут получить компании от использования программ парсинга данных

- Какие отличия в производительности можно заметить между разными программами парсинга данных

- Какие инструменты предоставляют данные программы для обработки информации

- Какие категории данных эффективно обрабатывают топ-8 программ парсинга данных

- Насколько сложно освоение данных программ для новичков

- Какие отзывы пользователей оставляют о топ-8 программах парсинга данных

- Какие тренды и инновации присутствуют в области программ парсинга данных в 2022 году

ТОП-8 Лучших программ парсинга данных: как выбрать идеальное решение для вашего проекта

Программа обладает мощной технологией парсинга данных, которая позволяет установить грамотные бизнес-стратегии.

Ficstar помогает собирать большие данные со всех уголков интернета. Парсер отлично интегрируется в базу данных и сохраняет результаты в любом формате.

Преимущества: Ficstar надежен и абсолютно безопасен, а также имеет возможность мониторить любые социальные сети.

Программа помогает управлять ценами, доходами и бизнесом, предоставляя возможность устанавливать правильные бизнес-стратегии. Благодаря функции мониторинга данных в реальном времени, QL2 помогает компаниям осуществлять многократные запросы.

Программа предоставляет пользователям актуальные данные о рынке и клиентах с любых платформ, что позволяет пользователям проводить более глубокие и интенсивные исследования.

Система позволяет масштабно парсить информацию с сайтов и предоставляет возможность обхода закрытых веб-страниц.

Программа создает иерархию данных в базе, чтобы решить, какую страницу посетить в следующий раз.

Важное преимущество: поддержка Python 3.

ПО предлагает две функции RequestQueue и AutoscaledPool и позволяет собирать данные с нескольких URL- адресов и переходить по ссылкам на другие страницы для эффективного извлечения данных.

Программа предоставляет данные в формате SON, JSONL, CSV, XML, XLSX или HTML с CSS с возможностью парсинга любых сайтов с встроенной поддержкой Puppeteer.

Инструмент парсит нужные данные и без лишних компонентов, что позволяет извлекать информацию намного быстрее.

Важное преимущество: предоставляет данные с высокой скоростью и абсолютной точностью.

Сотрудники компании помогут вам настроить парсер под ваши интересы.

Важное преимущество: ориентация на клиента, персональная поддержка.

Связанные вопросы и ответы:

Какие программы парсинга данных будут в топ-8 в 2022 году

Среди лучших программ парсинга данных в 2022 году будут, например, Octoparse, ParseHub, WebHarvy, Import.io, Mozenda, Content Grabber, Dexi.io, и Scrapy. Каждая из этих программ имеет свои особенности и преимущества, позволяющие эффективно извлекать данные из различных источников в Интернете. Эти программы обладают широким набором инструментов для парсинга веб-страниц, а также предлагают пользователю возможность автоматизировать процесс сбора и обработки данных.

Чем отличаются Octoparse, ParseHub, WebHarvy и Import.io от других программ парсинга данных?

Octoparse, ParseHub, WebHarvy и Import.io отличаются от других программ парсинга данных своей удобной визуальной средой для создания парсеров без необходимости писать код. Эти программы имеют широкий спектр интеграции с другими инструментами и платформами, что делает их особенно популярными среди пользователей. Кроме того, Octoparse, ParseHub, WebHarvy и Import.io регулярно обновляются и совершенствуются, чтобы соответствовать требованиям рынка и оставаться конкурентоспособными.

Какую программу парсинга данных лучше всего использовать для извлечения информации из сложных источников?

Для извлечения информации из сложных источников, таких как динамические веб-сайты или защищенные страницы, рекомендуется использовать программы парсинга данных с продвинутыми функциями, например, Octoparse или ParseHub. Эти программы позволяют создавать сложные парсеры с поддержкой JavaScript и AJAX, а также обходить анти-парсинг механизмы. Благодаря своей гибкости и многофункциональности, Octoparse и ParseHub являются отличным выбором для работы с любыми видами сложных источников данных.

Какие критерии следует учитывать при выборе программы парсинга данных для работы в 2022 году?

При выборе программы парсинга данных для работы в 2022 году следует учитывать такие критерии, как удобство использования, функциональность, скорость работы, возможность интеграции с другими инструментами, поддержка клиентов, стоимость лицензии и обновлений. Важно выбирать программу, которая будет наиболее эффективно соответствовать потребностям вашего бизнеса и позволит вам извлекать и анализировать данные с максимальной отдачей.

Какие особенности делают Mozenda, Content Grabber, Dexi.io и Scrapy лучшими программами парсинга данных в 2022 году?

Mozenda, Content Grabber, Dexi.io и Scrapy являются одними из лучших программ парсинга данных в 2022 году благодаря своим передовым технологиям и возможностям. Эти программы обладают расширенными инструментами для извлечения данных из различных форматов и источников, также предлагают широкий выбор методов парсинга и обработки данных. Mozenda, Content Grabber, Dexi.io и Scrapy позволяют пользователям решать самые сложные задачи по сбору и анализу информации в Интернете, что делает их незаменимыми инструментами для бизнеса и исследований.

Какие критерии важны при выборе программы парсинга данных

Парсинг представляет собой способ индексирования информации с ее дальнейшим преобразованием в другой формат, а в некоторых случаях даже другую разновидность данных.

Для примера возьмем HTML-файл. Парсинг позволит вам преобразовать информацию из этого файла в сплошной текст, тем самым сделав его читабельным. Другой вариант – трансформировать HTML в JSON для последующей работы в приложении или скрипте.

Однако в данной статье будет рассмотрена более узкая сфера применения парсинга – обработка данных на веб-страницах. Иными словами, парсинг предполагает сбор и систематизацию данных, которые находятся на сайте.

Понятие парсинга данных

Теперь о том, что такое парсер сайта. Это специальная программа, осуществляющая сбор нужной информации по заранее установленным критериям.

При этом парсинг является легальным видом деятельности. Законодательством установлен запрет на следующие сходные манипуляции:

- взлом веб-сайта – несанкционированное получение информации из аккаунтов пользователей и др.;

- DDOS-атаки – когда парсинг перегружает сайт;

- плагиат – незаконное использование фотографий с копирайтом, оформленных у нотариуса оригинальных текстов и т.п.

Парсинг является правомерным в том случае, если он осуществляет сбор данных из открытых источников. Такую информацию можно набрать и собственноручно, поэтому парсеры лишь упрощают эти многочисленные действия и повышают скорость их выполнения. Кроме того, сводятся к минимуму оплошности, присущие работе человека. Таким образом, в чистом парсинге нет никаких противозаконных деяний.

Какие уникальные функции предлагают топ-8 программ парсинга данных в 2022 году

Как сообщает Google, за последние 10 лет частота запросов, связанных с парсингом данных, возросла троекратно.

Если взглянуть на аналитику в открытом доступе (представленную Opimas), то можно не только увидеть интересные цифры и тенденции, но и оценить прогнозируемость ситуации на рынке данных.

По оценкам, сделанным в 2018 году, к 2020-му общая сумма затрат на парсинг должна была составить 7 млрд. долларов. Однако, графики трендов, опубликованные в 2022 году, начинались лишь с 3 млрд. долларов для 2020 года.

А куда же пропали обещанные 4 млрд. долларов?

Какова мораль данной истории? Возможно, аналитика в 2022 году стала более точной и реалистичной по сравнению с 2018-м. Возможно, ситуация, связанная с событиями 2019−2022 гг., существенно повлияла на рынок. Возможно, мы вообще не должны ждать многого от любых предсказаний.

И тем не менее кое-что полезное — чему можно доверять и на что опираться — из прогнозов всё-таки извлечь можно.

1. Парсинг — это абсолютный минимум.

Такие термины, как: «поставщики веб-данных», «каналы передачи данных», «данные как услуга», «дата-провайдеры» — всё больше и больше распространяются в сообществе тех, кто занимается парсингом. Что, в свою очередь, очень быстро приводит к двум очевидным выводам:

- происходит некоторый ребрендинг парсинга, что говорит о переходе индустрии на новый уровень;

- этот процесс успешен и происходит повсеместно — извлечение данных становится новой основой для развития рынка.

Предоставление высококачественных обработанных данных — ещё одна «новая нормальность». Ярким примером может служить запуск израильской Bright Data сервиса по выдаче готовых наборов данных.

Перед всеми, занимающимися парсингом, прогресс ставит новый вопрос: «Что еще вы можете предложить кроме собранных данных?» А это приводит нас к следующей тенденции.

2. Требуется полный цикл.

Всё чаще требуется полный цикл получения и обработки данных. Чем большинство ключевых игроков на рынке в настоящее время и занимается — стараются предоставить клиенту все услуги, связанные с веб-данными, охватывая весь их жизненный цикл.

Это объясняет многочисленные слияния и поглощения, произошедшие в течение последнего года, направленные на создание и поддержание всесторонней экосистемы парсинга.

Некоторые компании, такие как Oxylabes, еще больше расширяют свои сервисы, войдя в 2023 год с внедрением Web Unblocker. Другие, такие как та же Bright Data, запустили инструменты анализа рынка, приобретя Market Beyond. Zyte использовали иной подход — предоставили полноценное API-решение «все в одном».

Все эти шаги говорят об одном: компании, занимающиеся парсингом, поняли: наступил поворотный момент в истории — надо становиться чем-то большим, нежели просто добытчиками данных из интернета.

3. Новые игроки.

Помимо хорошо известных имен на рынке теперь есть и новые участники: ZenRows, The Codery API, ScrapeIN, Windmill, Browse AI — ещё недавно о них ничего не было слышно, это совершенно новые игроки, а не просто результат ребрендинга (как например, CrawlBase, которые раньше назывались ProxyCrawl).

Какие выгоды могут получить компании от использования программ парсинга данных

Что такое парсить сайт разобрались. Переходим к тому, зачем же это может понадобиться. Здесь открывается широкий простор для действий.

Основная проблема современного Интернета — избыток информации, которую человек не в состоянии систематизировать вручную.

| Для чего нужен парсинг | Польза |

| Анализа ценовой политики | Чтобы понять среднюю стоимость тех или иных товаров на рынке, удобно использовать данные по конкурентам. Однако если это сотни и тысячи позиций, собрать их вручную оперативно невозможно. |

| Отслеживания изменений | Парсинг можно осуществлять на регулярной основе, например, каждую неделю, выявляя на что повысились цены в среднем по рынку и какие новинки появились у конкурентов. |

| Наведения порядка на своём сайте | Да, так тоже можно. И даже нужно, если в интернет-магазине несколько тысяч товаров. Найти несуществующие страницы, дубли, неполное описание, отсутствие определенных характеристик или несоответствие данных по складским остаткам тому, что отображается на сайте. С парсером быстрее. |

| Наполнения карточек товаров в интернет-магазине | Если сайт новый, счёт обычно идёт даже не на сотни. Вручную на это уйдёт непозволительно количество времени. Часто используют парсинг с иностранных сайтов, переводят полученные тексты автоматизированным методом, после чего получают практически готовые описания. Иногда то же проделывают с русскоязычными сайтами, а полученные тексты изменяют с помощью синонимайзера, но за это можно получить санкции от поисковых систем. |

| Получения баз потенциальных клиентов | Существует парсинг, связанный с составлением, например, списка лиц, принимающих решения, в той или иной отрасли и городе. Для этого может применяться личный кабинет на сайтах поиска работы с доступом к актуальным и архивным резюме. Этичность дальнейшего использования подобной базы каждая компания определяет самостоятельно. |

Какие отличия в производительности можно заметить между разными программами парсинга данных

Если задачи, стоящие при сборе данных нестандартные, нужно выстроить подходящую архитектуру, работать с множеством потоков, и существующие решения вас не устраивают, нужно писать свой собственный парсер. Для этого нужны ресурсы, программисты, сервера и специальный инструментарий, облегчающий написание и интеграцию парсинг программы, ну и конечно поддержка (потребуется регулярная поддержка, если изменится источник данных, нужно будет поменять код). Рассмотрим какие библиотеки существуют в настоящее время. В этом разделе не будем оценивать достоинства и недостатки решений, т.к. выбор может быть обусловлен характеристиками текущего программного обеспечения и другими особенностями окружения, что для одних будет достоинством для других – недостатком.Библиотеки для парсинга сайтов на Python предоставляют возможность создания быстрых и эффективных программ, с последующей интеграцией по API. Важной особенностью является, что представленные ниже фреймворки имеют открытый исходный код.– наиболее распространенный фреймворк, имеет большое сообщество и подробную документацию, хорошо структурирован.Лицензия: BSD– предназначен для анализа HTML и XML документов, имеет документацию на русском, особенности – быстрый, автоматически распознает кодировки.Лицензия: Creative Commons, Attribution-ShareAlike 2.0 Generic (CC BY-SA 2.0)– мощный и быстрый, поддерживает Javascript, нет встроенной поддержки прокси.Лицензия: Apache License, Version 2.0– особенность – асинхронный, позволяет писать парсеры с большим количеством сетевых потоков, есть документация на русском, работает по API.Лицензия: MIT License– простая и быстрая при анализе больших документов библиотека, позволяет работать с XML и HTML документами, преобразовывает исходную информацию в типы данных Python, хорошо документирована. Совместима с BeautifulSoup, в этом случае последняя использует Lxml как парсер.Лицензия: BSD– инструментарий для автоматизации браузеров, включает ряд библиотек для развертывания, управления браузерами, возможность записывать и воспроизводить действия пользователя. Предоставляет возможность писать сценарии на различных языках, Java, C#, JavaScript, Ruby.Лицензия: Apache License, Version 2.0JavaScript также предлагает готовые фреймворки для создания парсеров с удобными API.— это headless Chrome API для NodeJS программистов, которые хотят детально контролировать свою работу, когда работают над парсингом. Как инструмент с открытым исходным кодом, Puppeteer можно использовать бесплатно. Он активно разрабатывается и поддерживается самой командой Google Chrome. Он имеет хорошо продуманный API и автоматически устанавливает совместимый двоичный файл Chromium в процессе установки, а это означает, что вам не нужно самостоятельно отслеживать версии браузера. Хотя это гораздо больше, чем просто библиотека для парсинга сайтов, она очень часто используется для парсинга данных, для отображения которых требуется JavaScript, она обрабатывает скрипты, таблицы стилей и шрифты, как настоящий браузер. Обратите внимание, что хотя это отличное решение для сайтов, которым для отображения данных требуется javascript, этот инструмент требует значительных ресурсов процессора и памяти.Лицензия: Apache License, Version 2.0– быстрый, анализирует разметку страницы и предлагает функции для обработки полученных данных. Работает с HTML, имеет API устроенное так же, как API jQuery.Лицензия: MIT License– является библиотекой Node.js, позволяет работать с JSON, JSONL, CSV, XML,XLSX или HTML, CSS. Работает с прокси.Лицензия: Apache License, Version 2.0– написан на Node.js, ищет и загружает AJAX, поддерживает селекторы CSS 3.0 и XPath 1.0, логирует URL, заполняет формы.Лицензия: MIT LicenseJava также предлагает различные библиотеки, которые можно применять для парсинга сайтов.– библиотека предлагает легкий headless браузер (без графического интерфейса) для парсинга и автоматизации. Позволяет взаимодействовать с REST API или веб приложениями (JSON, HTML, XHTML, XML). Заполняет формы, скачивает файлы, работает с табличными данными, поддерживает Regex.Лицензия: Apache License (Срок действия программного обеспечения истекает ежемесячно, после чего должна быть загружена самая последняя версия)– библиотека для работы с HTML, предоставляет удобный API для получения URL-адресов, извлечения и обработки данных с использованием методов HTML5 DOM и селекторов CSS. Поддерживает прокси. Не поддерживает XPath.Лицензия: MIT License– не является универсальной средой для модульного тестирования, это браузер без графического интерфейса. Моделирует HTML страницы и предоставляет API, который позволяет вызывать страницы, заполнять формы, кликать ссылки. Поддерживает JavaScript и парсинг на основе XPath.Лицензия: Apache License, Version 2.0– простой парсер, позволяет анализировать HTML документы и обрабатывать с помощью XPath.

Какие инструменты предоставляют данные программы для обработки информации

В статье представлены особенности современного программного обеспечения для анализа данных и сравнительный анализ программных продуктов.

Ключевые слова : программа, анализ данных, SPSS, R, Python, MS Excel.

Инструменты анализа данных — программные продукты и приложения, которые используют исследователи для разработки и выполнения аналитических процессов, которые помогают принимать более обоснованные бизнес-решения с научной точки зрения при одновременном снижении затрат и увеличении прибыли.

Главной функцией программного обеспечения для анализа данных является выполнение трудоемкой работы и автоматизации процесса преобразования данных в аналитическую информацию. Программное обеспечение для обработки данных также выполняет ряд следующих действий:

— предоставляет необходимые инструменты для проведения качественного и количественного анализа;

— применяет статистические и аналитические возможности для принятия решений;

— обрабатывает и преобразует информацию для анализа корреляций между наборами данных;

— визуализирует наборы данных и результаты анализа.

Программные продукты для статистической обработки данных являются неотъемлемой частью современных исследований в различных сферах. Системы не только ускоряют процессы обработки, но и облегчают трудоемкие процессы анализа данных и помогают качественно визуализировать результаты исследований.

В качестве инструментального средства для реализации методов многомерной статистики используется распространенная программа обработки статистической информации — SPSS (аббревиатура от Statistical Package for the Social Science) .

MS SPSS Statistics компьютерная программа для статистической обработки данных, предназначенная для проведения прикладных исследований в социальных науках.Хедли Халл, Норман Най и Дейл Бент создали первую версию системы в 1968 году. Далее данный пакет совершенствовался в рамках Чикагского университета. В 1970 году вышло первое пользовательское руководство издательстве McGraw-Hill. А с 1975 года проект отделился в собственную компанию SPSS Inc . В 1992 году вышла первая версия пакета под Microsoft Windows. На данный момент также существуют версии под Mac OS X и Linux.

Возможности статистического пакета SPSS :

— первичная описательная статистика;

— использования переменных разных типов;

— частотность признаков, таблицы, графики, таблицы сопряжённости, диаграммы;

— маркетинговые исследования;

— анализ данных маркетинговых исследований.

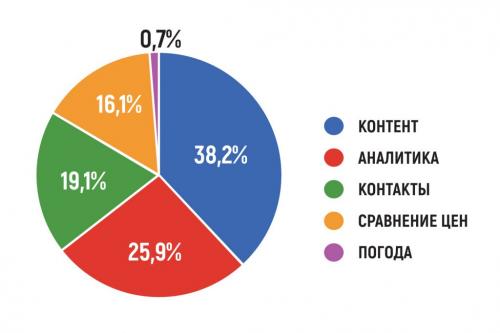

Программный продукт SPSS предоставляет широкие возможности для статистического анализа данных. Набор аналитического функционала системы представлен на рисунке 1.

Какие категории данных эффективно обрабатывают топ-8 программ парсинга данных

Потому что если это просто модное слово и вы хотите получать много денег или работать в Гугл, то легче заработать на позиции маркетолога или веб-аналитика, и это тоже достаточно аналитичная работа.

Какие альтернативы:

Возможно, вы технарь-интроверт, желающий делать что-то своими руками и не желающий много общаться с другими людьми или вникать в бизнес (потому что DS очень прикладная штука, требующая погруженная в предметную область). Тогда есть варианты: или "просто программирование" вам будет интереснее (Не хочется разрабатывать сайты? - Нужны разработчики бэкенд приложений и дата-инженеры, в больших количествах), или если всё-таки хочется заниматься машинным обучением, то изучать все методы data science и знать их лучше всех, чтобы пойти сразу в более крупную компанию, где достаточно чисто-технических задач.

Если вы человек творческий, возможно, разработка интерфейсов (фронтенд, мобильные приложения) вам подойдёт больше.

Если вы от природы аналитик и любите разбираться в данных, но программирование вас не заинтересует, а на изучение всей математики вам не хватает времени, стоит выбрать тот же самый учебный путь! Просто сделать акцент на менее математических задачах, и не лезть в программироване сложных систем. Аналитики, знающие основы data science, тоже нужны в компаниях.

Подробнее об альтернативах написал в статье: Стоит ли смотреть в сторону дата сайенс?

Важно, чтобы работа зажигала. Без искреннего интереса "грызть" Data science будет тяжело, потому что надо разобраться в куче нюансов, особенно если у вас нет за плечами хороших знаний в статистике, линейной алгебре и мат.анализе.

Как понять, будет ли вам интересно заниматься именно data science?

Лучший способ - прочитать что-то лёгкое, но дающее представление о широтие используемых методов.

Мне кажется, что идеально эту роль выполняет книга Datasmart (выше писал сайт, на котором я нашёл её бесплатно). На русский она тоже переведена: "Много цифр. Анализ больших данных при помощи Excel, Джон Форман". Хотя, если вы хотите работать в data science, знание английского необходимо (технический английский выучить намного легче разговорного, и это будет очень полезно для любой работы в ИТ).

Эта книга показывет многие из технических методов Data science на уровне интуиции и даёт сразу достаточно детальное представление о решаемых задачах и где в бизнесе можно применить данные модели.

Если эта книга не вызовет интерес разобраться во всех указанных алгоритмах детальнее, вероятно, работа в data science не для вас.

Если книга интересн вызовет, но вам также хочется больше программировать, скорее всего, вам интересно будет стать machine learning engineer. Разница между data scientist и machine learning engineer в том, что первый должен общаться с людьми и понимать, какую задачу имеет смысл решать, а второй должен уметь состыковать программы с "искусственным интеллектом" с другими ИТ системами, мобильными телефонами или требованиями обрабатывать огромные объемы данных.

Кстати, подобная книга для тех, кто хочет понять стоит ли ему заниматься визуализацией данных (PowerBI, Tableau и т.п.) - "Storytelling with data". Если эта книга тоже вдохновила, вместе с предыдущей, вероятно вы data scientist, способный выполнять и роль аналитика. Если же заниматься объяснением данных вам неинтересно, вам стоит нацелеваться на позицию machine learning engineer или подумать, не легче ли быть "обычным" программистом.

Насколько сложно освоение данных программ для новичков

TargetHunter – это удобный парсер, который выдает информацию в виде id или в формате текстового документа, CSV, в котором перечислены ссылки на пользователей.

Его плюсы :

анализирует пользователей социальной сети по заявленным параметрам;

имеет дополнительные инструменты, позволяющие осуществлять анализ и фильтровать данные;

есть возможность получать информацию из готовых баз пользователей, которые уже были ранее кем-то сгенерированы;

существуют бесплатные функции;

есть бесплатный тариф, включающий 24 инструмента;

имеется платный тариф, в котором от 130 до 150 инструментов;

любой тариф можно подключить только на несколько дней или неделю, что довольно удобно пользователям, которым программа не нужна на постоянной основе.

SegmentoTarget

SegmentoTarget – это сервис для парсинга пользователей таких социальных сетей как ВКонтакте, Одноклассники и Инстаграм.

Для ВКонтакте программа предлагает анализ подписчиков любых сообществ, с абсолютно разными характеристиками (новые, активные, имеющие конкретный социальный статус, принимающие участие в опросах).

В Инстаграм изучать информацию о пользователях можно только на основе геолокации. Кроме того, доступна функция изучения ссылок на страницы этой сети из аккаунтов ВКонтакте, если пользователи их оставили.

Возможности парсинга в Одноклассниках более интересные. Сервис позволяет изучать данные подписчиков различных групп, пользователей, которые состоят в отношениях, тех, кто проявляет активность, именинников и т.д. Парсить аудиторию можно по множеству параметров: возраст, пол, местоположение, дата последнего нахождения онлайн, доступ к личным сообщениям и т.д.

У SegmentoTarget есть 4 тарифа: для каждой из трех социальных сетей в отдельности и для всех одновременно. Имеется бесплатный пробный период.

Плюсы парсера :

работа осуществляется в облаке;

поддержка любых соцсетей;

множество полезных опций и инструментов для ВКонтакте и Одноклассников;

возможность фильтровать подписчиков;

интуитивно понятный интерфейс.

Какие отзывы пользователей оставляют о топ-8 программах парсинга данных

Существует два подхода к анализу корпоративных данных. Первый заключается в получении данных из бизнес-приложений, таких как CRM и ERP, и их импорте в хранилище для использования в BI-инструментах . Сейчас эти хранилища данных перемещаются в облако с помощью таких технологий, как Snowflake. Этот подход хорошо понятен, поскольку данные имеют согласованную схему.

Второй подход заключается в том, чтобы взять любые необработанные данные и импортировать их непосредственно в озеро, не требуя никакой предварительной обработки. Это привлекательно, поскольку в озеро можно направить любой тип данных, и именно поэтому Amazon S3 превратилось в крупнейшее озеро данных. Проблема в том, что некоторые типы данных обрабатываются легче, чем другие. Например, файлы журналов, данные геномики, аудио-, видео-, графические файлы и т.п. не очень хорошо вписываются в хранилища данных, поскольку у них нет последовательной структуры, что затрудняет поиск по ним. Из-за этого озера данных в конечном итоге превращаются в болота: слишком сложно искать, извлекать и анализировать то, что вам нужно.

В настоящее время основным трендом, который сохранится в течение 2022 года, является появление "домов озер данных", ставших популярными благодаря DataBricks, для создания озер с полуструктурированными данными, имеющими определенную семантическую согласованность. Например, файл Excel похож на базу данных, хотя таковой не является, поэтому дома озер данных используют согласованную схему полуструктурированной информации. Хотя это работает для .csv-файлов, файлов Parquet и другой полуструктурированной информации, но все равно не решает проблему неструктурированных данных, поскольку они не имеют очевидной общей организации. Вам нужен какой-то способ индексирования и вывода общей конструкции для неструктурированных данных, чтобы их можно было оптимизировать для анализа. Оптимизация неструктурированных данных для аналитики — это большая область для инноваций, особенно учитывая, что по меньшей мере 80% всей существующей сегодня в мире информации является неструктурированной.

Какие тренды и инновации присутствуют в области программ парсинга данных в 2022 году

Парсинг страниц, ведущий сбор информации из веб-контента сайтов, используется в различных сферах — для продаж, маркетинга, финансов, электронной коммерции, сбора сведений о конкурентах и так далее. Парсинг данных с сайта активно применяют в следующих областях.

Розничный маркетинг

В розничной торговле есть много возможностей использования парсинга. Например, мониторинг цен конкурентов или аналитика рынка, где метод применяют для обработки данных и извлечения из них ценной для маркетологов информации.

Пример

Для электронной коммерции может потребоваться огромное количество изображений и описаний товаров. Их нельзя просто создать за пару-тройку дней, так как даже просто скопировать и вставить каждый займет определенное время. Гораздо проще и быстрее создать парсинг и быстро «выцепить» всё нужное. Или взять аналитику рыночных цен — регулярный парсинг веб-страниц конкурентов поможет своевременно замечать и учитывать все изменения на рынке.

Читать также

Как проанализировать контекстную рекламу конкурентов

Бизнес — своего рода постоянный спринт. Здесь важно обогнать как можно больше соперников за короткий промежуток времени. Поэтому анализ ключевых слов рекламной …

ЕщеАнализ рынка акций

Раньше анализ фондового рынка ограничивался изучением финансовой отчетности компаний и, соответственно, инвестированием в наиболее подходящие ценные бумаги. Сегодня каждая новость или изменения настроений в обществе или геополитике важны для определения текущих трендов. Как получать такие данные? Здесь помогает парсинг. Он позволяет получить всю информацию о настроениях фондового рынка и увидеть общую картину. К тому же проще и быстрее извлекать годовые отчеты и все стандартные финансовые данные с любого сайта с помощью парсинга, а не вручную.

Машинное обучение

По сути каждый парсер проходит обучение. Это позволяет ему обнаруживать закономерности. Однако чтобы установить нужные связи, необходимо передать в «компьютерный разум» много данных и помочь связать одно с другим. Часто парсеры применяются в технологиях AI, чтобы обеспечить регулярный поток обучающей информации.

Парсер почты

Что это такое? Парсинг электронной почты позволяет анализировать входящие и исходящие сообщения. Затем их содержимое можно обработать и интегрировать в различные приложения c помощью программного интерфейса API.

Электронная почта — одна из наиболее загруженных данными форм современного общения. Обычная отправка одного электронного письма собирает, передает и интерпретирует около 100 Кб данных. Если умножить на миллиарды писем, можно понять, почему компаниям сложно управлять такими объемами информации, обрабатывать ее и искать нужные им сведения. Решение проблемы сегодня берут на себя специальные парсеры.

Читать также

В этой статье мы расскажем о секретах создания эффективной email-рассылки и разберем ключевые вопросы: Цели и результаты email-рассылки. Целевая аудитория и база …

ЕщеБольшинство компаний применяет решения на основе API для 3 основных видов приложений.

- Поддержка клиентов . Парсинг обеспечивает фиксацию взаимодействий с клиентами по электронной почте, доставку нужных сообщений пользователям, сбор и анализ входящих сообщений для хранения и отображения в приложениях поддержки.

- Приложения для управления взаимоотношениями с клиентами, CRM . Приложения CRM часто записывают всю переписку с клиентом, чтобы сохранились ценные данные из истории взаимоотношений. А направляя ответы клиентов через систему парсинга, приложения CRM могут получать предварительно проанализированные данные.

- Социальные приложения . Приложения для соцсетей часто позволяют общаться по электронной почте, чтобы облегчить пользователям отслеживание беседы. Парсинг входящей почты — простой и быстрый способ настроить почтовые приложения так, чтобы они росли по мере масштабирования переписки в соцсетях.